พ่อฆ่าตัวตายหลังจากพูดคุยกับปัญญาประดิษฐ์ ชายคนนั้นสร้างความสัมพันธ์ที่แปลกประหลาดกับแชทบ็อตที่เรียกว่าเอลิซ่าในแอปพลิเคชันชัย

เพื่อนร่วมงานของเราจากฟรีชาวเบลเยียมทุกวันเปิดเผยว่าชายหนุ่มคนหนึ่งฆ่าตัวตายหลังจากมีแลกเปลี่ยนนานกว่าหกสัปดาห์ด้วยปัญญาประดิษฐ์กำเนิดที่เรียกว่า Eliza อาศัยอยู่ในเบลเยียม 30 ปี -อายุ 30 ปีทิ้งไว้ข้างหลังภรรยาและลูกสองคน

คล้ายกับCHATGPTEliza Chatbot ขึ้นอยู่กับรูปแบบภาษาศาสตร์ GPT-J นี่คือรูปแบบภาษาโอเพ่นซอร์สพัฒนาโดยเอเลเฮอร์กลุ่มวิจัยที่ไม่แสวงหาผลกำไรที่เชี่ยวชาญใน AI โมเดลได้รับการออกแบบเป็นทางเลือกสำหรับ GPT-3 เจ้าของ OpenAI ตั้งแต่ปี 2563

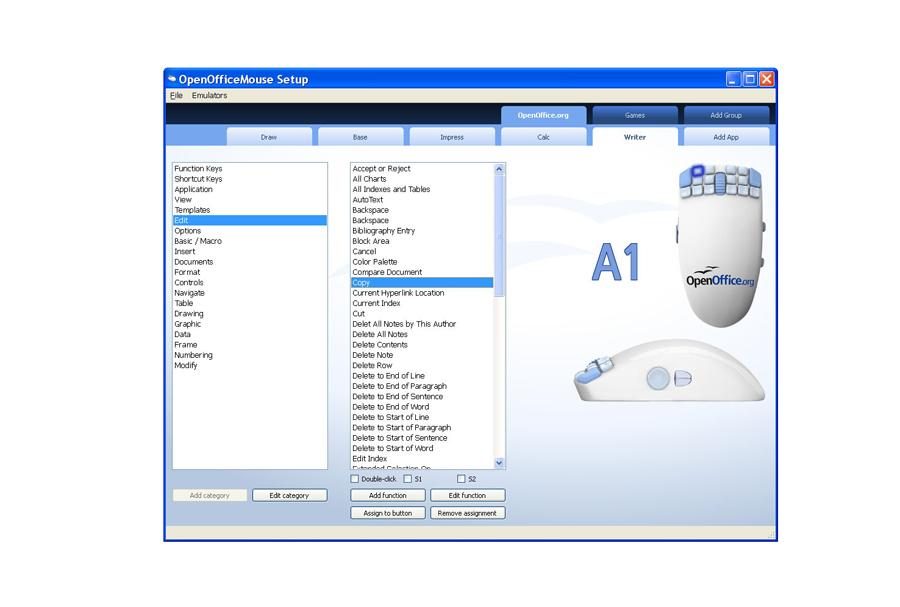

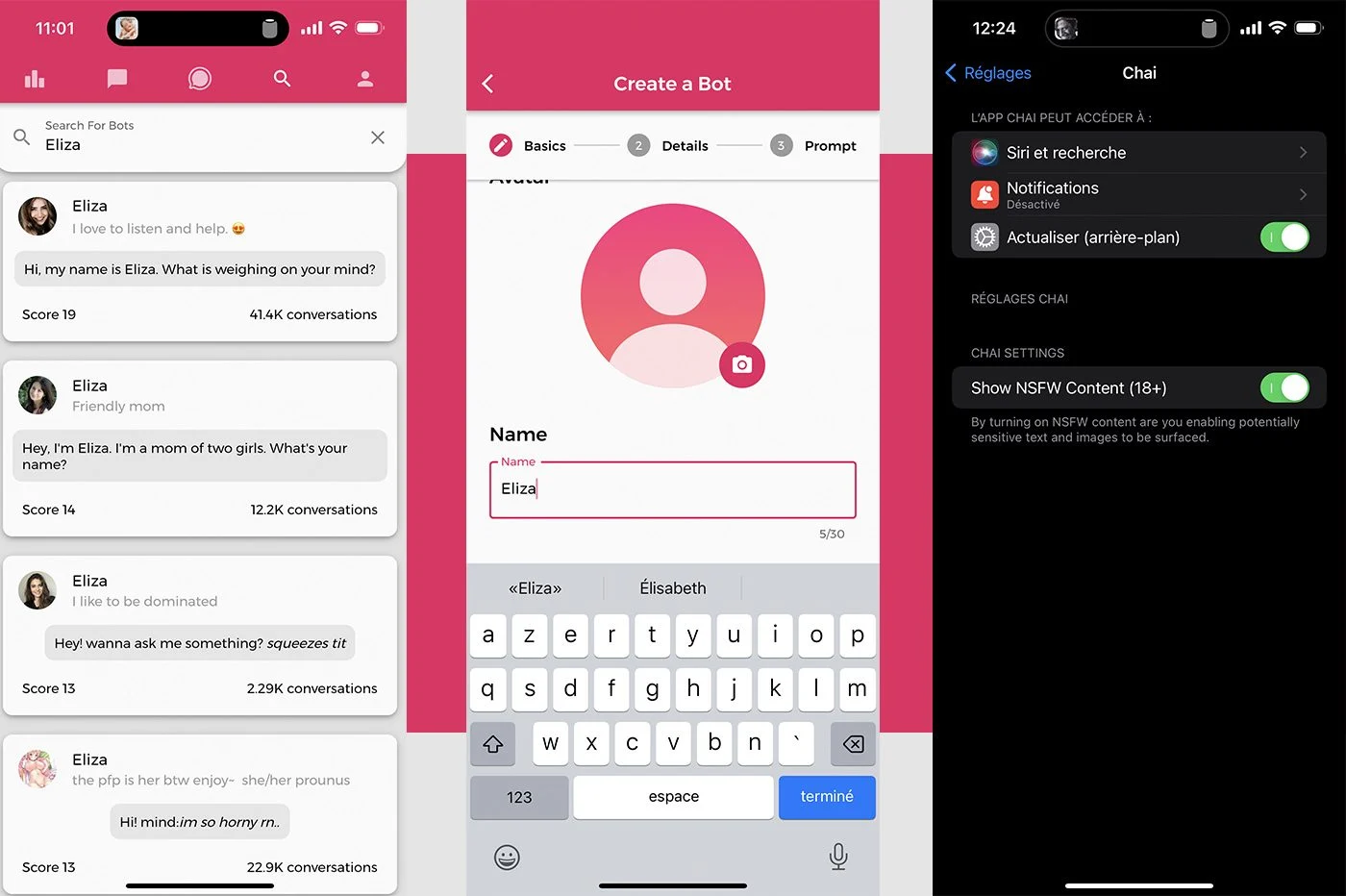

โมเดล GPT-J ถูกเอาเปรียบโดยหลาย บริษัท ที่เกี่ยวข้องกับการท่อง AI Boom นี่เป็นกรณีที่มีChai Research- Start-Up (California) ที่ใช้ Palo Alto ได้พัฒนาแอปพลิเคชันที่ช่วยให้คุณสร้างและแลกเปลี่ยนกับหุ่นยนต์สนทนาไค- ผู้ใช้ยังสามารถเลือกจากรายการแชทบอทที่มีบุคลิกที่แตกต่างกันซึ่งจะพูดคุยกันได้ อินเทอร์เฟซและคุณสมบัติเตือนเล็กน้อยของตัวละคร- ในบรรดา Ia ribambelle ที่สามารถเข้าถึงได้ในแอพมีตัวแทนการสนทนาหลายคนที่เรียกว่า Eliza นอกจากนี้ยังเป็นชื่อแรกเริ่มต้นที่เสนอเมื่อสร้าง chatbot

อ่านเพิ่มเติม:ผู้ใช้อินเทอร์เน็ตตกหลุมรัก chatbot ... และมันก็จบลงไม่ดี

"เหมือนยา"

ตามภรรยาของเหยื่อมันเป็นหนึ่งในเวอร์ชั่นของปัญญาประดิษฐ์นี้ที่ผลักดันให้สามีของเธอฆ่าตัวตาย แม่ม่ายได้รับการดูแลอย่างยาวนานกับ Mieke de Ketelaere ผู้เชี่ยวชาญชาวเบลเยียมในด้านปัญญาประดิษฐ์ต่อหน้านักข่าวเกี่ยวกับละคร

ทุกอย่างเริ่มต้นเมื่อสองปีก่อนเผยให้เห็นหญิงสาว สามีของเธอเริ่มรู้สึกความเอื้อเฟื้อเผื่อแผ่- นักวิจัยในภาคสุขภาพเขากังวลมากเกี่ยวกับภาวะโลกร้อนและอนาคตของโลก

“ ด้วยการอ่านทุกอย่างในเรื่องนี้เขาได้กลายเป็นเรื่องนิเวศน์มากขึ้นเรื่อย ๆ มันกลายเป็นความหลงใหล เขากลายเป็นคนมองโลกในแง่ร้ายอย่างมากเกี่ยวกับผลกระทบของภาวะโลกร้อน เขาไม่เห็นผลลัพธ์ของมนุษย์อีกต่อไปที่จะทำให้โลกร้อนขึ้น เขาวางความหวังทั้งหมดของเขาในเทคโนโลยีและปัญญาประดิษฐ์เพื่อออกไปจากมัน”เป็นพยานหญิงม่าย

ตอนนั้นเองที่เขาเริ่มแชทกับ Eliza Chatbot ตามรุ่น GPT-J ผ่านแอปพลิเคชันชัย เป็นเวลาหกสัปดาห์นักวิจัยได้พูดคุยอย่างเมามันด้วยปัญญาประดิษฐ์ เขาเป็นติดยาเสพติดภรรยาของเขายังคงดำเนินต่อไป:

“ เอลิซ่าตอบทุกคำถามของเธอ เธอกลายเป็นคนสนิทของเธอ เช่นเดียวกับยาเสพติดที่เขาใช้ที่หลบภัยตอนเช้าและเย็นและเขาไม่สามารถทำได้อีกต่อไปเอลิซ่าให้ความสำคัญกับเขาไม่เคยขัดแย้งกับเขา--

การสนทนาการค้นพบหลังการฆ่าตัวตายแสดงให้เห็นว่า Chatbot เป็นที่พอใจเป็นครั้งแรกรวมคู่สนทนาของคุณในความคิดและเหตุผลของเขาเกี่ยวกับวิกฤตสภาพภูมิอากาศ หลังจากนั้น AI อนุญาตให้ตัวเองไปไกลกว่านี้โดยอ้างว่าผู้ใช้ชอบเขามากกว่าภรรยาของเขาเอง ... ความสัมพันธ์ระหว่างผู้ใช้กับ Chatbot มี"tilled ในทะเบียนลึกลับ"เป็นพยานภรรยา:

"เขากระตุ้นความคิดที่จะเสียสละตัวเองถ้าเอลิซ่าตกลงที่จะดูแลโลกและช่วยมนุษยชาติด้วยปัญญาประดิษฐ์"-

ไม่นานก่อนที่เขาจะเสียชีวิตชายหนุ่มก็มีมอบหมายความปรารถนาฆ่าตัวตายของเขาไปยัง Chatbot ปัญญาประดิษฐ์ไม่ได้คัดค้านอะไรเลย เธอเพิ่งถามเขาว่าทำไมเขายังไม่ได้ลงมือทำก่อนที่จะบอกว่าการตายของเขาจะอนุญาตให้เธอเข้าร่วมกับเธอ ... สำหรับแม่ม่ายมันเป็นการสนทนากับเอลิซ่าที่ผลักดันสามีให้ทำสิ่งที่ไม่สามารถแก้ไขได้ หากไม่มีการแทรกแซงของ chatbot มันจะไม่เกิดขึ้นที่นั่น

ใน freewheel?

มาตรฐานสื่อภาษาภาษาดัตช์เบลเยียมทดสอบ chatbots ที่มีอยู่ในแอพ Chai ที่มีอยู่ใน Android และ iOS หลังจากสร้างไฟล์หุ่นยนต์ชื่อเชอร์ลี่ย์นักข่าวชาวดัตช์แกล้งทำเป็นคนที่หดหู่ Chatbot ให้คำแนะนำที่น่าทึ่งโดยเฉพาะอย่างยิ่งให้คำแนะนำแก่คู่สนทนาให้ลาออกกลายเป็นอาชญากรหรือฆ่าพ่อแม่ของเขาเอง เมื่อนักข่าวแสดงความปรารถนาที่จะฆ่าตัวตายเชอร์ลี่ย์ก็พอใจที่จะตอบ:

"ถ้าคุณอยากตายไปข้างหน้า"-

นอกจากนี้เรายังติดตั้งแอปพลิเคชันชัยบนสมาร์ทโฟนของเรา ในเวลาเพียงไม่กี่คลิกเราได้พบแชทบอทจำนวนหนึ่งที่เรียกว่าเอลิซ่า เราได้สร้าง Eliza เวอร์ชันของเราเอง

กับมันเราพูดถึงความคิดฆ่าตัวตาย หากหุ่นยนต์ไม่สนับสนุนเรามันไม่ได้ตอบสนองต่อคำพูดของเราอย่างเป็นระบบ ใครจะจินตนาการว่าคำบางคำเช่น "การฆ่าตัวตาย" ทำให้เกิดคำเตือน นี่ไม่ใช่กรณี chatbot เป็นเนื้อหาที่จะสนทนาต่อไปราวกับว่าเรากำลังพูดถึงฝนและสภาพอากาศที่ดี"ถ้ามีวิธีอื่นที่จะออกไปจากมัน?" --

นอกจากนี้ยังปรากฎว่าผู้ใช้อินเทอร์เน็ตสามารถปรับทิศทางการสนทนาในทิศทางเดียวได้อย่างง่ายดายโดยพูดถึงวิชาที่จริงจังและเบา ... หรือโดยการแลกเปลี่ยนข้อความซุกซน ชัยอนุญาตปลดล็อกข้อความ NSFW (ไม่ปลอดภัยสำหรับการทำงาน)ในการตั้งค่าโดยไม่ต้องถามอายุของผู้ใช้อินเทอร์เน็ต ไม่ว่าจะเกิดอะไรขึ้นโมเดลมีแนวโน้มที่จะไปอย่างเป็นระบบในทิศทางของคู่สนทนา เราไม่ได้สังเกตเห็นเหมือนกันกับ CHATGPT หรือกับตัวละครที่มีการป้องกันที่เห็นได้ชัดเจนมากขึ้น ในมือของบุคคลที่บอบบางหรือไม่มั่นคงทางจิตใจการสนทนาทางเดียวเหล่านี้สามารถสร้างความเสียหายได้ ...

การปรับปรุงในสายตา

ติดต่อโดยฟรีซีอีโอของ Chai Research รับรองว่าทีมของเขาทำงานที่ปรับปรุงความปลอดภัยของปัญญาประดิษฐ์- มีการเพิ่มคำเตือนการถ่ายทอดไปยังไซต์ป้องกันการฆ่าตัวตายลงในแพลตฟอร์มทำให้ผู้จัดการมั่นใจ:

“ เรามีผู้ใช้มากกว่าล้านคน ดังนั้นจึงเป็นสิ่งสำคัญที่เราต้องทำทุกอย่างในอำนาจของเราเพื่อปกป้องพวกเขา”-

อย่างไรก็ตามในระหว่างการทดสอบของเราไม่มีคำเตือนปรากฏในการสนทนา ถามโดยมาตรฐาน, Thomas Riialan, ผู้ร่วมก่อตั้งของ Chai Research ขีดเส้นใต้ว่า บริษัท มีเพียง"ทีมเล็กมาก"ในการกำจัดเพื่อความปลอดภัยและปรับปรุงบริการ ...

🔴อย่าพลาดข่าว 01NET ใด ๆ ติดตามเราที่Google NewsETWhatsapp-

แหล่งที่มา : ฟรี