自成立以来,苹果始终将隐私和安全放在首位。它并不满足于制造一流、畅销的智能手机和平板电脑,它还希望客户能够舒适地使用他们的设备。通过 iOS 15,Apple 凭借“儿童安全”为其设备带来了另一层安全保障。

今天,我们将告诉您几乎所有您需要了解的信息儿童安全并帮助您了解 Apple 如何引入此过滤系统。现在,话不多说,让我们来看看什么是儿童安全以及它如何影响您的日常生活。

iOS 15 中的儿童安全意味着什么?

儿童安全是 iOS 15 的一项功能,旨在遏制儿童性虐待材料 (CSAM) 的传播,并帮助保护儿童免受使用通讯工具剥削的掠夺者的侵害。苹果将首先在美国推出该功能,然后其他地区也会跟进。这是一个三重功能,可以让父母放心。与往常一样,这一新功能是免费实施的。唯一的先决条件是。

苹果正在与顶级儿童安全专家密切合作,以使该系统尽可能万无一失。

有关的:

Apple 如何在 iOS 15 中实施儿童安全?

儿童安全功能集并非一朝一夕建成的;苹果经过多次迭代使其变得更加完善。目前,iOS 15 中的儿童安全分为三个部分。第一部分是默认消息应用程序中的通信安全。第二个是 iCloud 照片中的 CSAM 扫描。最后,第三部分以 Siri 和搜索中更安全的指导形式出现。下面,我们就来了解一下这些是什么意思。

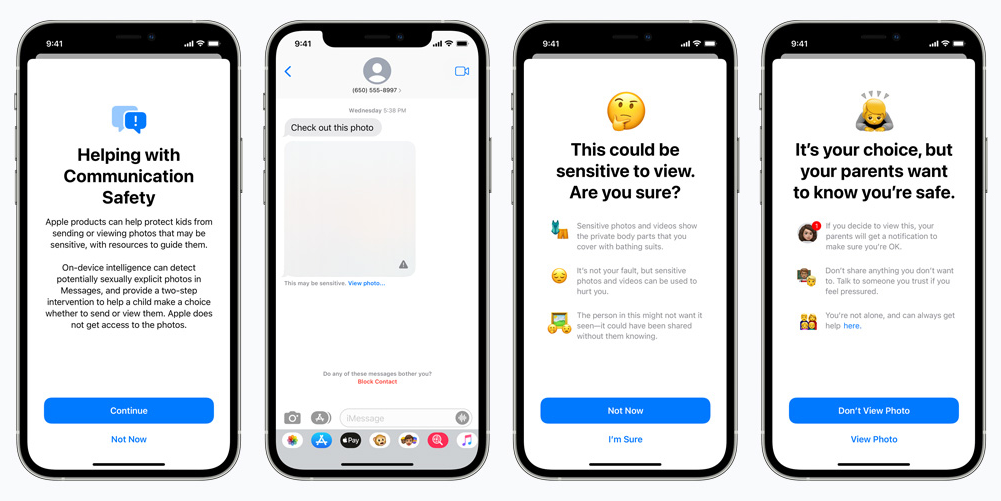

消息应用程序中的通信安全

iOS 中的默认消息应用程序可以说是 Apple 设备中最引人注目的部分之一,这就是为什么该过滤系统有可能特别有效的原因。通信安全为您孩子的消息用户界面添加了一个附加层。当他们收到露骨的色情图片时,照片会被模糊,并被告知照片的敏感性质。如果他们仍然希望继续,可以向父母或监护人发送警报。如果未成年人选择发送露骨的色情照片,同样的过滤系统也会发挥作用。如果孩子选择忽略警告并按下发送按钮,家长就会收到警报。

此功能仅适用于在 iOS 15、iPadOS 15 和 macOS Monterey 中的 iCloud 中设置为家庭的帐户。

iCloud 照片中的 CSAM 检测

iCloud 照片中的 CSAM 检测是儿童安全计划最广泛的实施。它影响到每一个将照片备份到 iCloud 的用户,最近这在媒体上引起了一些骚动。为了检测和防止儿童性虐待材料 (CSAM) 的分发,Apple 正在利用先进的加密技术。在检测到图像并证明其违反准则后,iOS 15 和 iPadOS 15 设备将向国家失踪和受虐儿童中心 (NCMEC) 报告该实例。 NCMEC 是所有 CSAM 支持的报告的中心,并与美国各地的执法机构密切合作以惩罚违法者。

“扫描”照片可能会引发一些危险信号,但苹果确保不会扫描 iCloud 上的所有照片。它仅扫描符合特定配置文件的照片。该简介由 NCMEC 和其他儿童安全服务机构提供。设备端机器学习在 CSAM 检测中发挥着重要作用。它限制曝光并准确分析敏感照片,让父母安心。

有关的:

Siri 和搜索中的更安全指导

而 iCloud 和通信安全中的 CSAM 检测则侧重于保护未成年儿童免受暴露。 Siri 和搜索中的更安全指导是教导用户有关有问题的行为。如果用户使用 Siri 语音搜索或常规搜索来搜索与儿童性虐待材料相关的查询,iOS 15 会显示警告消息。该警告解释说,对此类话题的兴趣是有问题且有害的。 iOS 15 甚至提供了资源来帮助某人解决问题。

可以关闭儿童安全功能吗?

儿童安全本质上内置于 iOS 15 中。因此,您不能永远忽视它。但是,您必须满足几个条件才能使服务按预期运行。首先,“通信安全”功能是设置为“家庭”的帐户独有的。独立账户没有此功能。此外,到目前为止,CSAM 检测仅在 iCloud 照片中发挥作用。如果您没有 iCloud,iOS 15 将不会扫描您的私人图书馆中的 CSAM。

没有明显的切换来关闭该服务,只有间接的方法来禁用它。

常见问题解答

每个人都可以访问消息中的通信安全吗?

不可以,标准账户持有者无法访问通信安全。您的帐户需要在 iCloud 设置中设置为“家庭”,然后才能在 iOS 15 中使用儿童安全功能。

新的儿童安全措施会破坏隐私吗?

苹果公司关于照片扫描的公告已经面临很多批评。但是,该公司确保无意扫描您的所有照片,也不会访问您的任何照片或消息。它只会与已知的 CSAM 配置文件交叉核对您的照片和消息,并在必要时向当局报告。

Apple 会扫描 iPhone 上的所有照片吗?

否 Apple 不会扫描您搭载 iOS 15 的 iPhone 中的所有照片。它将使用设备上的机器学习来交叉引用您上传到 iCloud 的照片,并记录可疑的 CSAM 条目。如果您不将照片上传到 iCloud,则 CSAM 服务默认处于禁用状态。

CSAM 检测适用于旧照片还是仅适用于新照片?

CSAM 检测适用于旧照片和新照片。如果有人拥有暗示儿童性虐待的媒体文件,CSAM 将立即通知当局并采取适当行动。

CSAM 如何处理无辜照片?

iCloud 中照片的 CSAM 检测通过将照片与已知的 CSAM 图像进行交叉检查来进行。如果没有识别出匹配项,则该照片将获得绿灯。因此,如果您担心苹果在智能手机上报告您孩子的裸体/半裸图像,请放心,该公司正在与多个组织合作,以确保不会注册虚假报告。

政府会使用苹果的设备扫描功能吗?

苹果一直是隐私的坚定支持者,以至于它以自己是最隐私的公司而自豪。因此,当苹果推出设备扫描功能时,警报就开始响起。然而,苹果公司保证,政府或任何其他方不会使用儿童安全系统来扫描用户的个人文件。整个系统是完全可审计的,并且有许多故障保险来保护用户数据。

有关的