Nvidia 週二推出了 Nvidia NeMo Guardrails,這是一個工具包,旨在使大型企業能夠控制大型語言模型和生成 AI 系統如 ChatGPT 讓他們更安全、更值得信賴。

英偉達的一部分 AI 平台,Nvidia NeMo 是一個雲原生企業框架,企業可以使用它來構建、定制和部署生成式 AI 楷模。

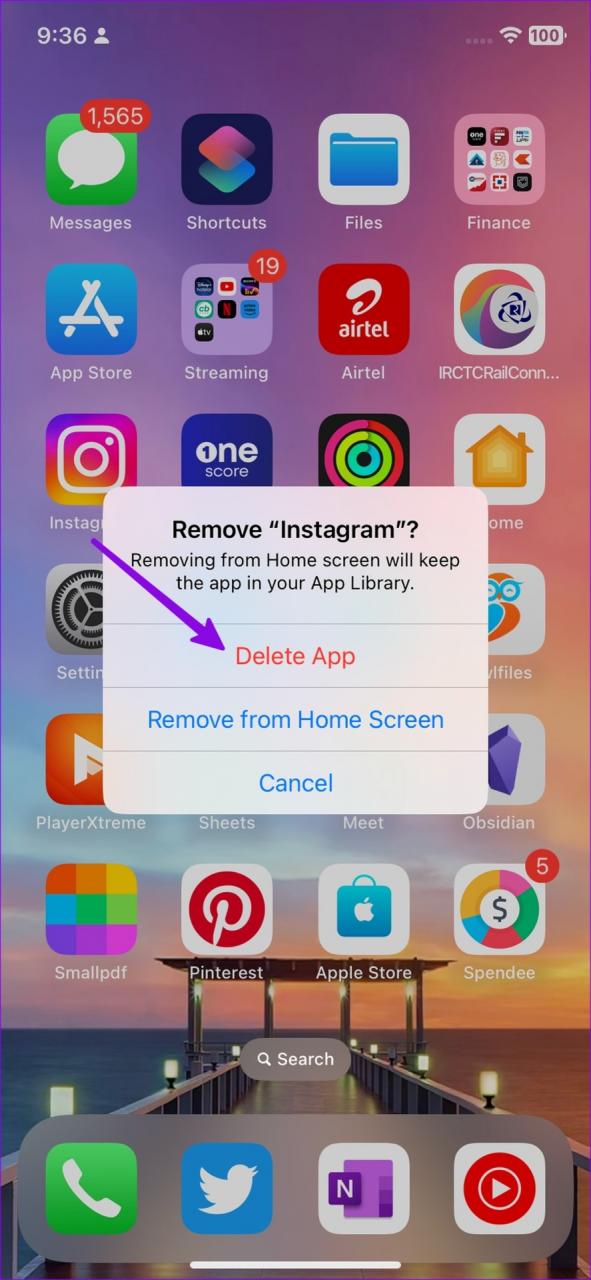

NeMo Guardrails 是一個開源軟件工具包,位於用戶和大型語言模型 (LLM) 應用程序之間。 據 Nvidia 稱,它使企業能夠開發安全且值得信賴的 LLM 對話系統。 Guardrails 適用於所有法學碩士,包括 ChatGPT 從 Microsoft 夥伴 OpenAI。

該工具包可以輕鬆地與LangChain或Zapier等社區工具包集成。 LangChain 是 GitHub 上圍繞 LLM 應用程序構建的框架,可用於摘要、聊天機器人和生成式問答。

護欄是建立在 科朗,一種建模語言。 Colang 為用戶提供了一個可讀且可擴展的接口來控制其行為 AI 使用自然語言的機器人。

NeMo Guardrails 用戶可以將可編程規則添加到他們的 AI 聊天機器人定義用戶交互並保護人類和生成器之間的對話 AI 系統。

Nvidia NeMo Guardrails 幫助企業控制響應 AI 聊天機器人必須進行不同的詢問。

降低焦慮

護欄將有助於減少一些擔憂 AI 寒武紀說,聊天機器人 AI 創始人兼分析師卡爾·弗羅因德。

“這會降低焦慮水平,有助於 [enterprises] 他們可以定制工具來滿足他們的業務需求,並提供安全性和主題指導,並減少對大型語言模型產生幻覺的機會,”弗羅因德說。

生成式 AI “幻覺”包括系統將不應該放在一起且沒有意義的想法和詞語組合在一起,或者聊天機器人發明了不存在的東西(例如書籍或權威學術來源的參考文獻)。

NeMo Guardrails 也是 Nvidia 幫助企業更輕鬆地開始使用生成式技術的一種方式 AI 弗羅因德補充道,因為這項技術的目標是信任問題。 很多企業不信任 AI 聊天機器人,例如 ChatGPT 因此不願意部署自己的生成 AI 系統。

“這將降低溫度,讓人們有信心控制我們創造的這個怪物, GPT-4,”弗羅因德說,指的是最新版本的 OpenAI的顯性生成 AI 文本系統。

Opus Research 分析師丹·米勒 (Dan Miller) 表示,雖然使用法學碩士來平衡或檢查法學碩士可能看起來很奇怪,但這是不可避免的。

新的 Nvidia 生成 AI 安全系統反映了對人與人之間平衡的關注 AI, 他說。

“我們人類不想被完全取代,”米勒說。 “但如果可以的話,我們應該認識到我們的部分責任是建立這些護欄或限制產出 [of AI] 將是。 使用 AI 可以讓我們更有效率地做到這一點。”

此外,弗羅因德說,用一個法學碩士來保護另一個法學碩士是明智的做法。

“你不會通過編寫 C 代碼來解決這個問題,”他說,指的是 1970 年代仍在使用的編程語言。 “你將通過利用法學碩士的力量來幫助限制法學碩士可能說的話來解決這個問題。 [an inquiry]”。

行業監管

此外,雖然 NeMo Guardrails 並不是對法學碩士提出的道德問題的完美回應,但它是一個 example Futurum Research 分析師丹·紐曼 (Dan Newman) 表示,在聯邦政府和全球監管努力稀疏的情況下,該行業自我監管的重要性。

紐曼表示:“雖然我們希望在全球範圍內看到有意義的政策,但該行業必須在一段時間內進行自我監管。” 自我監管可能不是最佳的,但像 Nvidia 這樣的供應商, Microsoft 和 Google 他補充說,這些機構將領導自律運動。

“是時候嘗試創建一些護欄,至少可以讓我們不斷創新,因為你無法將精靈放回瓶子裡,”紐曼說。 “但與此同時, [we can] 盡力阻止那些試圖從創新中做出最壞結果的人的惡意行為。”

NeMo Guardrails 現已作為 GitHub 上的開源工具包提供。

Esther Ajao 是一位報導人工智能軟件和系統的新聞撰稿人。