OpenAI ได้รณรงค์กับสมาชิกสภานิติบัญญัติแห่งยุโรปเพื่อให้ระบบ AI แบบกำเนิดเช่น ChatGPT หรือ Dall-E จะได้รับการพิจารณาว่าเป็น "ระบบที่มีความเสี่ยงสูง" ซึ่งเป็นหมวดหมู่ที่กำหนดไว้ในกฎระเบียบของยุโรปเกี่ยวกับ AI และคำขอบางส่วนของเขาซึ่งมีจุดมุ่งหมายเพื่อลดภาระผูกพันในอนาคตของเขาอย่างมีนัยสำคัญรวมอยู่ในข้อความ - ไม่สุดท้าย - นำโดยรัฐสภายุโรปเมื่อวันที่ 14 มิถุนายน

มันเป็นเรื่องราวของสังคมที่ในอีกด้านหนึ่งยังคงทำซ้ำว่าปัญญาประดิษฐ์จะต้องได้รับการควบคุม ในทัวร์ยุโรปเมื่อเดือนที่แล้วแซมอัลท์แมนซีอีโอของOpenaiบอกใครก็ตามที่อยากได้ยินมันเป็นเรื่องเร่งด่วนที่จะออกกฎหมายสำหรับภาคนี้- มันเป็นสังคมเดียวกันนี้ซึ่งอีกอย่างหนึ่งพยายามลดขอบเขตของกฎในอนาคตเหล่านี้อย่างรอบคอบภาระด้านกฎระเบียบ»วางแผนโดยอนาคตกฎระเบียบของยุโรปเกี่ยวกับ AI, รายงานไฟล์เวลา,วันอังคารที่ 20 มิถุนายนนี้ เพื่อนร่วมงานของเราแสดงให้เห็นว่าการเริ่มต้นขึ้นทำให้ Chatgpt เข้าหาผู้ออกกฎหมายชาวยุโรปเพื่อแนะนำการเปลี่ยนแปลงในกฎระเบียบเกี่ยวกับปัญญาประดิษฐ์ในช่วงสิบสองเดือนที่ผ่านมาเหล่านี้

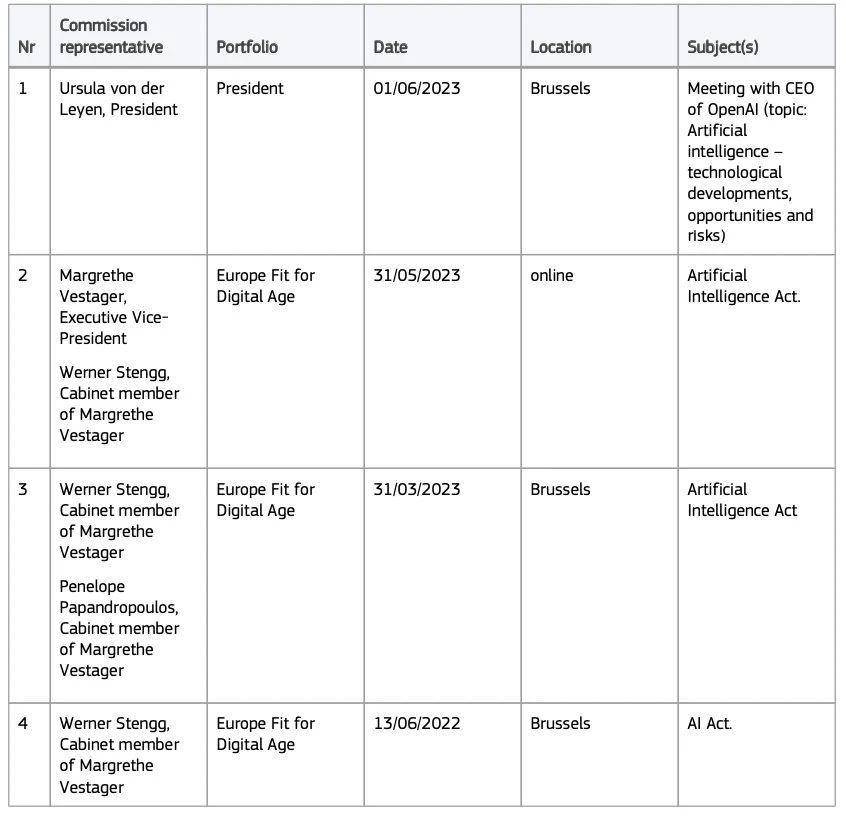

และการดำเนินการวิ่งเต้นเหล่านี้ซึ่งถูกกฎหมายอย่างสมบูรณ์จะมีประสิทธิภาพ ข้อโต้แย้งบางอย่างที่ออกให้เชื่อมั่นว่า MEPs ที่พวกเขาได้รับการรับรองอย่างที่เราเห็นในเวอร์ชันของพวกเขาโหวตในการประชุม Plenary เมื่อวันที่ 14 มิถุนายน มันจะเริ่มเกือบหนึ่งปีที่ผ่านมาในเดือนมิถุนายน 2565 นานก่อนที่จะเปิดตัวCHATGPTรายงานเพื่อนร่วมงานของเรา ในทะเบียนความโปร่งใสของสมาชิกสภานิติบัญญัติยุโรปฐานข้อมูลออนไลน์ที่สามารถเข้าถึงได้สำหรับทุกคนที่แสดงรายการกลุ่มและองค์กรล็อบบี้ที่พยายามมีอิทธิพลต่อสมาชิกสภานิติบัญญัติยุโรปมีการนัดหมายครั้งแรกแน่นอนเมื่อวันที่ 13 มิถุนายน 2565 กับสมาชิกของคณะรัฐมนตรีของ Margrethe Vestager รองประธานคณะกรรมาธิการยุโรปในกรุงบรัสเซลส์

ในระหว่างการประชุมครั้งแรกนี้ตัวแทน OpenAI จะแสดงความกังวลเกี่ยวกับระบบ AI สำหรับการใช้งานทั่วไป - เป็น GPT3 - ซึ่งจะรวมอยู่ในระบบที่มีความเสี่ยงสูงหมวดหมู่ที่กำหนดไว้ในกฎระเบียบของยุโรป .

หาก chatgpt ถูกจัดประเภทในหมวดหมู่นี้มันควรจะผ่านขั้นตอนการประเมินเบื้องต้นและการควบคุมการปฏิบัติตามกฎระเบียบก่อนที่ชาวยุโรปจะสามารถเข้าถึงได้ OpenAI ยังมีข้อผูกมัดในการตั้งค่าระบบการจัดการความเสี่ยงนโยบายการกำกับดูแลข้อมูลที่เข้มงวดที่ใช้สำหรับการฝึกอบรมการควบคุมมนุษย์ของระบบนอกเหนือจากการปฏิบัติตามความถูกต้องความทนทานและความทนทานและความปลอดภัยทางไซเบอร์ แล้วสเปกตรัมของการตั้งครรภ์แทนและผลกระทบต่อนวัตกรรมจะได้รับการรับรองจากการเริ่มต้นในระหว่างการประชุมครั้งแรกนี้ตามแหล่งที่มาของเวลาที่ต้องการไม่ระบุชื่อ คราวนี้ตัวแทนของ Openai จะไม่ไปไกลกว่านี้ พวกเขาจะไม่ขอกฎที่ยืดหยุ่นมากขึ้นอย่างชัดเจน

การแบ่งปันกระดาษสีขาวพร้อมคำขอแก้ไขข้อความ

แต่ในเดือนกันยายน 2565 หลังกลับมาที่ค่าใช้จ่ายโดยส่งกระดาษสีขาวถึงตัวแทนของคณะกรรมาธิการและสภาสหภาพยุโรปเอกสารเจ็ดหน้าเผยแพร่โดยเพื่อนร่วมงานของเรา เราสามารถอ่านข้อโต้แย้งของ OpenAI ซึ่งอธิบายถึงการป้องกันที่แตกต่างกันที่วางไว้เพื่อป้องกันไม่ให้ระบบ AI กำเนิดของมันไม่แข็งแรงตามการเริ่มต้น มาตรการทั้งหมดเหล่านี้ควรเพียงพอที่จะไม่จำแนก AI กำเนิดของพวกเขาในเครื่องมือที่มีความเสี่ยงสูงขอร้อง บริษัท -ในตัวเอง GPT-3 ไม่ใช่ระบบที่มีความเสี่ยงสูง แต่ [มัน] มีความสามารถที่สามารถใช้ในกรณีการใช้งานที่มีความเสี่ยงสูง"เขียนผู้เขียนกระดาษขาว

-สิ่งที่พวกเขาพูดโดยทั่วไปคือ: เชื่อใจเราในการควบคุมตนเอง-ความคิดเห็น Daniel Lefer นักวิเคราะห์ทางการเมืองที่เชี่ยวชาญใน AI ภายในการเข้าถึงตอนนี้สัมภาษณ์โดยเวลา. "มันสับสนมากเพราะพวกเขาส่งถึงนักการเมืองที่พูดกับพวกเขาว่า" โปรดควบคุมเรา "พวกเขาโอ้อวดมาตรการ [ความปลอดภัย] ทั้งหมดที่พวกเขาใช้ แต่ทันทีที่คุณพูด ชั้นกำกับดูแล” พวกเขาบอกว่าไม่เขาดำเนินการต่อเมื่อเดือนพฤษภาคมที่ผ่านมาซีอีโอของ Openai ได้เตือนว่าเขาสามารถ "หยุดกิจกรรมในยุโรปถ้าเขาคิดว่าตัวเองไม่สามารถปฏิบัติตามกฎระเบียบของยุโรปเกี่ยวกับ AIข้อความที่เขามี "มาก"นักวิจารณ์ ... ก่อนย้อนรอย

คำขอบางอย่างที่ดำเนินการในข้อความของสมาชิกรัฐสภายุโรป

กระดาษสีขาวก็ไปไกลกว่านั้นใน "แนะนำการแก้ไข»: Openai ตัวอย่างเช่นหวังว่าระบบการอัปเดตด้วยเหตุผลด้านความปลอดภัยไม่จำเป็นต้องรีดด้วยการประเมินของสหภาพยุโรปใหม่ที่จะอยู่ในตลาด บริษัท ยังได้อ้อนวอนสำหรับการใช้ AI ในการศึกษาและการจ้างงานบางอย่างเพื่อพิจารณาว่ามีความเสี่ยงสูงเช่นการสร้างข้อเสนองาน ข้อโต้แย้งของเขากระทบตาของวัวหรือไม่?

ใช่สำหรับบางคนเพราะหลายเดือนต่อมารัฐสภายุโรปจบลงด้วยการเผยแพร่กฎระเบียบรุ่นที่ 705 MEPs ตกลงกัน ประโยคที่มีอยู่ในรุ่นก่อนหน้าของคณะกรรมาธิการและสภาซึ่งชี้ให้เห็นว่าระบบ IA สำหรับการใช้งานทั่วไปจะต้องได้รับการพิจารณาอย่างแท้จริงที่มีความเสี่ยงสูงหายไป ข้อความที่นำมาใช้โดยรัฐสภาทำให้นักพัฒนาของ "โมเดลพื้นฐาน" หรือระบบ AI ที่ผ่านการฝึกอบรมเกี่ยวกับข้อมูลจำนวนมาก หลังควรปฏิบัติตามภาระผูกพันเพียงเล็กน้อยเช่นกล่าวว่าระบบได้ถูกดึงไปยังข้อมูลที่ได้รับการคุ้มครองตามลิขสิทธิ์หรือหลีกเลี่ยงการสร้างเนื้อหาที่ผิดกฎหมาย

ความสำเร็จของ Openai อาจไม่ได้ถูกนำมาใช้ในเวอร์ชันสุดท้ายของข้อความ

ความสำเร็จอีกประการหนึ่งสำหรับ Openai: ในกระดาษสีขาวการเริ่มต้นขึ้นคัดค้านข้อเสนอเพื่อแก้ไข MEPS ที่ใครจะจำแนกระบบ AI ที่เกิดขึ้นได้เช่น CHATGPT และ Dall-e ในหมวดหมู่ "ความเสี่ยงสูง"จากช่วงเวลาที่ข้อความหรือรูปภาพที่สร้างขึ้นสำหรับการสร้างโดยมนุษย์- ซึ่งจะนำไปสู่การจำแนก AI เหล่านี้โดยอัตโนมัติเป็นนำเสนอความเสี่ยงสูง Openai อธิบายว่าข้อผูกพันที่จะกล่าวถึง "เนื้อหาที่สร้างโดย AI" นั้นเพียงพอแล้ว และในที่สุดการแก้ไขปัญหาก็ไม่ได้ถูกเก็บรักษาไว้โดยสมาชิกรัฐสภายุโรป

ในที่สุดในระหว่างการประชุมครั้งล่าสุดลงวันที่ 31 มีนาคมจดทะเบียนในทะเบียน OpenAI นำเสนอเจ้าหน้าที่ของยุโรปที่ทำงานตามกฎหมายเกี่ยวกับฟังก์ชั่นความปลอดภัยของ CHATGPT รายงานเพื่อนร่วมงานของเรา พวกเขาจะหลีกเลี่ยงการมีสูตรสำหรับการผลิตสารอันตรายที่ออกโดย Chatgpt แต่การป้องกันนั้นถูกข้ามได้ง่ายขีดเส้นใต้เวลา, chatgpt ที่สามารถนำไปสู่เขียนอีเมลฟิชชิ่งหรือสร้างคำแนะนำเพื่อสร้างสารที่ผิดกฎหมาย

หาก Openai สามารถยืนยันมุมมองของมันสิ่งต่าง ๆ ยังคงเปลี่ยนแปลงได้เนื่องจากกฎระเบียบของ AI ยังไม่ได้รับการโหวตตอนนี้จะต้องมีการหารือใน Trilogue รุ่นสุดท้ายที่รัฐสภายุโรปสภาและคณะกรรมาธิการยุโรปจะเห็นด้วยอาจรวมถึงกฎที่เข้มงวดยิ่งขึ้นสำหรับระบบ AI สำหรับการใช้งานทั่วไปเช่น CHATGPT ... สำหรับความโชคร้ายที่ยิ่งใหญ่ที่สุดของ Sam Altman

อ่านเพิ่มเติม:ยาเสพติดการฆาตกรรมขโมย: เราทดสอบ "chatgpt" ที่ไม่สะอาด ... และนั่นก็น่ากลัว

🔴อย่าพลาดข่าว 01NET ใด ๆ ติดตามเราที่Google NewsETWhatsapp-

แหล่งที่มา : เวลา