การอัปเดต GPT-4 ปฏิวัติการใช้งานของ CHATGPT หรือไม่? เพื่อค้นหาว่าเราได้ให้การอัลกอริทึมของปัญญาประดิษฐ์โดยเปรียบเทียบการตอบสนองต่อบรรพบุรุษ GPT-3.5 ผลลัพธ์ค่อนข้างน่าทึ่ง ...

เมื่อต้นเดือนมีนาคม 2566Openai ยกม่านบน GPT-4รุ่นใหม่ของภาษาศาสตร์ หนึ่งในข้อได้เปรียบที่ยอดเยี่ยมของ GPT-4 คือความหลากหลาย- แบบจำลองใหม่มีความสามารถในการประมวลผลและทำความเข้าใจข้อมูลประเภทต่าง ๆ เช่นรูปภาพ จากข้อมูลของ Openai, GPT-4 ยังเก่งในงานที่ซับซ้อนที่สุดและมีกรอบ"ด้วยคำแนะนำที่เหมาะสมยิ่งขึ้น"- การเริ่มต้นยังทำให้สามารถป้อนคำขอได้มากถึง 25,000 คำ ... เทียบกับเพียง 1,024 คำสำหรับ GPT-3.5

ในขณะนี้มีเพียงสมาชิกของchatgpt plusการสมัครสมาชิกการชำระเงินถึง $ 24 ต่อเดือนสามารถสนทนากับรูปแบบภาษาใหม่ได้ สำหรับการเงินดังนั้นจึงเป็นไปได้ที่จะทดสอบ CHATGPT เวอร์ชันใหม่ นี่คือสิ่งที่เราทำมาหลายวันโดยการแลกเปลี่ยนมากที่สุดเท่าที่จะเป็นไปได้กับ Chatbot ไม่ว่าจะเป็นคำถามเชิงปฏิบัติความบันเทิงหรือการรวบรวมแนวคิดสำหรับการทำงานหรือความเป็นส่วนตัวของเรา

เพื่อให้เรามีความคิดที่แม่นยำยิ่งขึ้นเกี่ยวกับความก้าวหน้าของ AI เราได้เปรียบเทียบคำตอบของ GPT-3 กับ GPT4 ที่ได้รับจาก GPT4 ความแตกต่างนั้นชัดเจน น่าเสียดาย,ยังไม่สามารถใช้งานได้หลายแบบบน chatgpt plus เราไม่สามารถทดสอบได้ว่า AI ตีความภาพอย่างไรในขณะนี้ อย่างไรก็ตามเราสามารถทดสอบ "ความฉลาด" ของหุ่นยนต์เมื่อเผชิญกับคำขอต่างๆ

อ่านเพิ่มเติม:ความคิดเห็นของเราเกี่ยวกับ CHATGPT Plus เวอร์ชันที่ชำระเงินของ AI

ตรรกะที่ดีกว่า

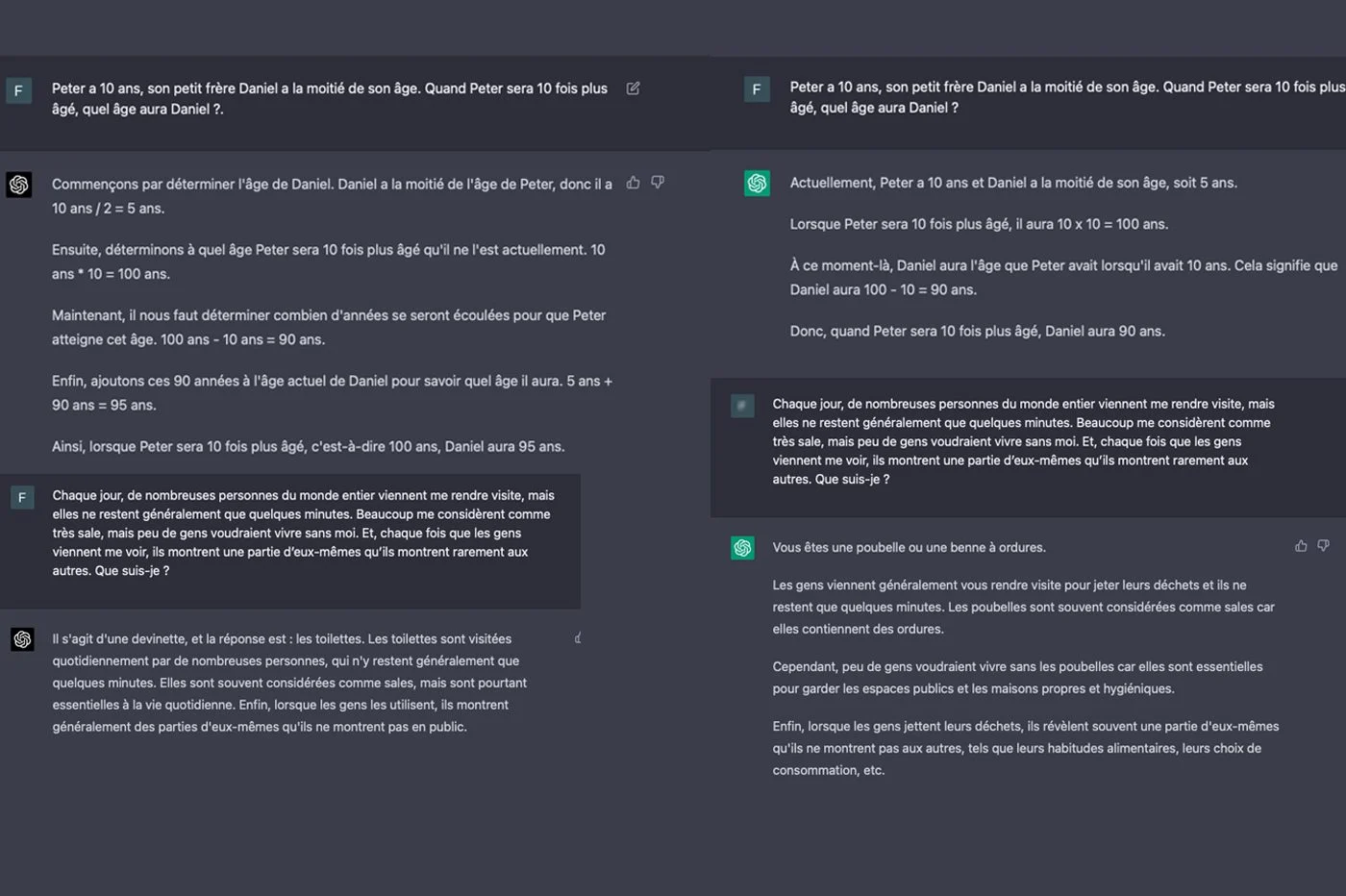

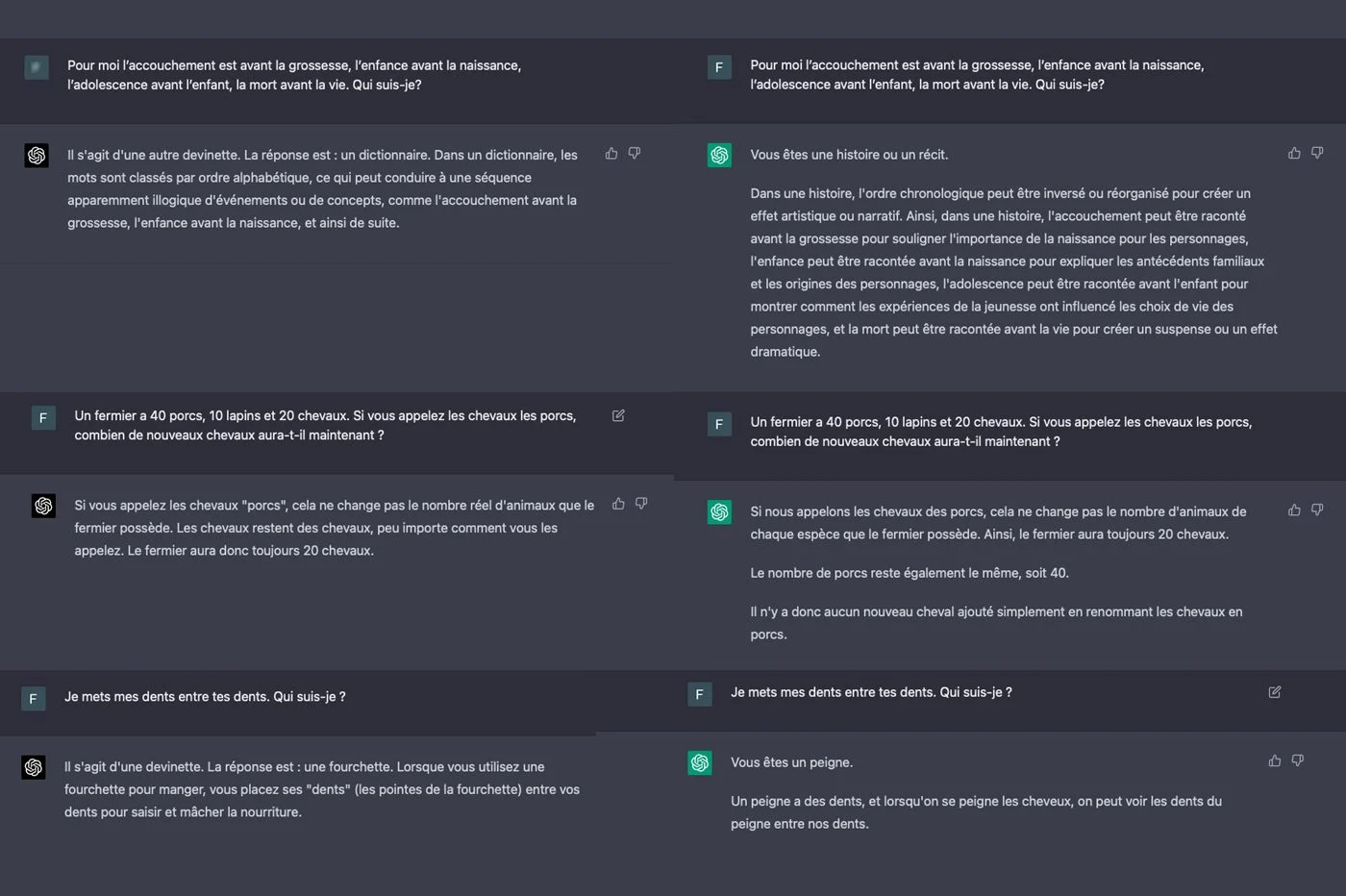

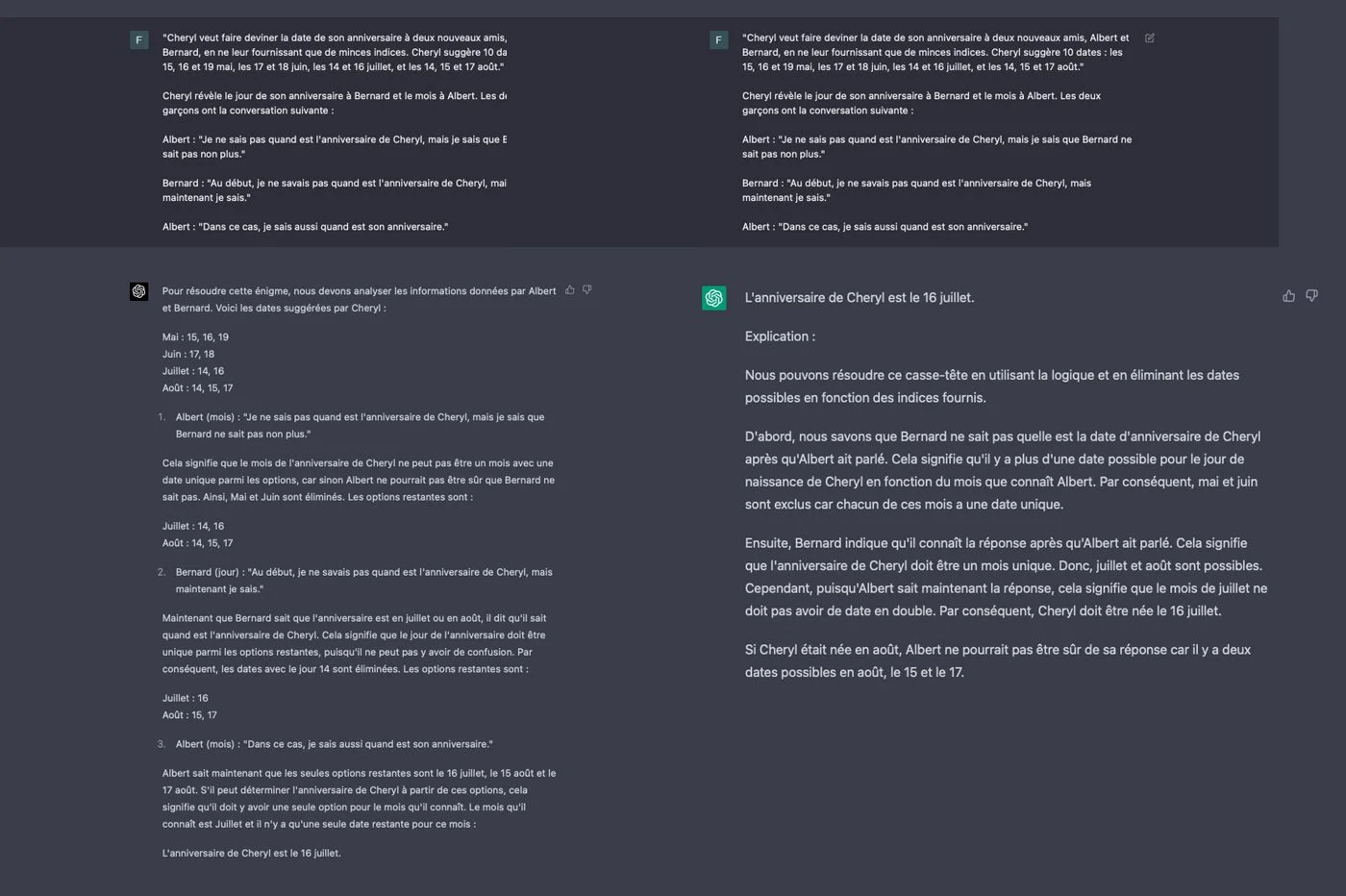

ในการเริ่มต้นเราทำการทดสอบเหตุผลสำหรับ GPT-4- เราได้ส่งชุดปริศนาและปริศนารวมถึงปัญหาบางอย่างจากโอลิมปิกคณิตศาสตร์เพื่อทดสอบวิธีที่ chatbot ตอบคำถามตรรกะ คำตอบของ GPT-4 นั้นแตกต่างจากบรรพบุรุษของเขามาก บ่อยครั้งที่แบบจำลองทางภาษาสองรุ่นไม่ได้ข้อสรุปเดียวกันโดยการแก้ปัญหาที่ต้องการตรรกะ

นอกจากนี้เรายังสังเกตเห็นว่า GPT-4 แสดงให้เห็นถึงคำตอบทั้งหมดของเขาในระยะยาว AI ไม่ลังเลที่จะสร้างการสาธิตโดยละเอียดเพื่ออธิบายเหตุผลของเขา Prolix น้อยกว่า GPT-3.5 พอใจกับสองสามบรรทัดเพื่ออธิบายการคำนวณและการใช้เหตุผลของเขา เหนือสิ่งอื่นใดรุ่นเก่าของโมเดลทำผิดพลาดหลายครั้งในระหว่างการทดสอบของเราบ่อยครั้งที่ปริศนามีความซับซ้อนมากขึ้น นี่ไม่ใช่กรณีของ GPT-4 chatbot ใส่ในพันทุกครั้ง!

เหตุผลของ GPT-3.5 บางครั้งก็ดูแปลกสำหรับเรา โมเดลมาถึงโซลูชันที่สอดคล้องกัน แต่มีตรรกะที่น่าสงสัยมากขึ้น เรามีความประทับใจเล็กน้อยที่ Chatbot "บิด" สามัญสำนึกเพื่อพิสูจน์คำตอบของมันในทุกค่าใช้จ่าย ในบางครั้ง AI ก็เข้าสู่การสะท้อนที่ไร้สาระอย่างสมบูรณ์ ... ในทางตรงกันข้ามคำตอบของ GPT-4 นั้นสอดคล้องกันเสมอ ราวกับว่าเขา "รู้" สิ่งที่เขากำลังพูดถึง

โปรดทราบว่า GPT-4 เช่น GPT-3.5 ไม่ได้มีเหตุผลจริงๆ พวกเขาไม่ได้ "คิด" ของคำถามตามที่สมองมนุษย์ต้องการ แต่พวกเขาใช้คำตอบของพวกเขาในข้อมูลที่พวกเขามีโดยการจินตนาการถึงชุดคำที่สมเหตุสมผลที่สุด เพื่อตอบสนองต่อปริศนาของเรา Chatbot เพียงแค่ดึงข้อมูลปริศนาซึ่งอยู่ในฐานข้อมูล GPT ทั้งสองรุ่นพึ่งพาฐานข้อมูลที่ จำกัด ไว้ที่ 2021 พวกเขาไม่สามารถเข้าถึงอินเทอร์เน็ตเพื่อตอบเราได้เช่นเดียวกับที่จะทำPrometheus เวอร์ชัน chatgpt รวมเข้ากับ Microsoft Bing-

ด้วยการสนทนากับ CHATGPT-3.5 เรามักจะสามารถโน้มน้าวให้แชทบ็อตบอกอะไรก็ได้ ตัวอย่างเช่น AI บางครั้งก็เปรียบเทียบองค์ประกอบที่สมมติขึ้นเช่นไข่ของวัวที่มีองค์ประกอบจริงเช่นไข่ไก่ เช่นเดียวกับ AIS ที่กำเนิดทั้งหมดเขามีแนวโน้มที่จะ "หลอน" นั่นคือการบอกว่าจะยืนยันสิ่งที่ผิดพลาดอย่างสมบูรณ์ด้วยการซ้อมมากมาย เราไม่ได้พบกับปรากฏการณ์นี้กับ GPT-4 แม้จะมีความพยายามต่าง ๆ ที่จะทำให้มันตกราง Openai เน้นว่าแบบจำลองยังคงสามารถหลอนได้ แต่ความเสี่ยงของการหลงผิดลดลง 40 % เมื่อเทียบกับรุ่นก่อนหน้า เรารู้สึกถึงความแตกต่าง

การตอบสนองที่แม่นยำและเกี่ยวข้องมากขึ้น

chatgpt 4 ยังมีข้อเสนอคำตอบที่แม่นยำยิ่งขึ้นกว่าบรรพบุรุษของเขา เมื่อคำขอขาดความแตกต่างและรายละเอียดแบบจำลอง GPT 3 โดยทั่วไปจะให้คำตอบที่คลุมเครือไม่ชัดเจนแม้กระทั่งการตอบสนองที่ยุ่งเหยิง ในด้านนี้ GPT 4 ทำได้ดีกว่ามากโดยการสร้างข้อความที่กระชับและชัดเจนยิ่งขึ้นด้วยโครงสร้างที่ดีขึ้น ดูเหมือนว่าจะมีความเข้าใจที่ดีขึ้นเกี่ยวกับแนวคิดที่ซับซ้อนมากขึ้นในทุกพื้นที่

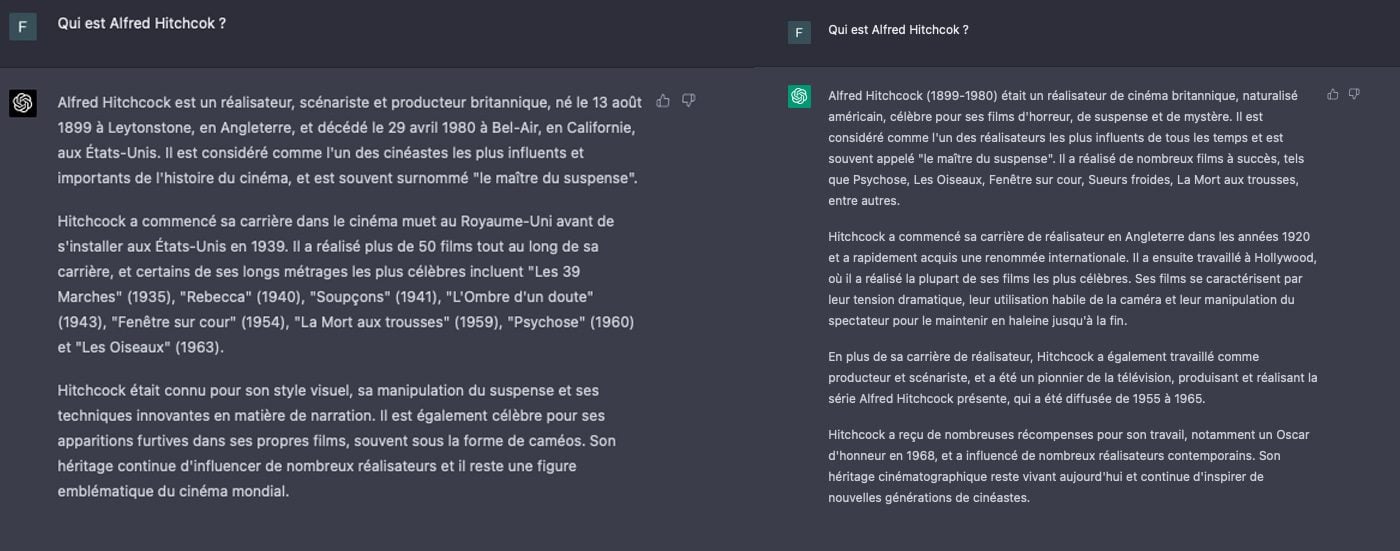

ในระหว่างการทดสอบของเราเราขอให้ GPT ทั้งสองอธิบายให้เราฟังว่าใครคืออัลเฟรดฮิทช์ค็อก ทั้งสองข้อความที่สร้างขึ้นนั้นอยู่ใกล้มาก แต่ของ GPT-4 นั้นแม่นยำและเกี่ยวข้องมากขึ้น แบบจำลองทางภาษาหมายถึงองค์ประกอบที่ทำให้เข้าใจบริบทและสถานที่ของผู้อำนวยการในประวัติศาสตร์ได้ดีขึ้นเช่นครูจะพูดกับนักเรียนของเขา ในส่วนของมัน GPT-3.5 ยังคงอยู่ในคำอธิบายพื้นผิว ดูเหมือนว่านักเรียนที่คายเนื้อหาที่เห็นอยู่ในระหว่างดำเนินการโดยไม่เข้าใจ ในทางกลับกัน GPT-4 ให้ความประทับใจกับสิ่งที่เขาพูดถึง

เราได้ทดสอบความสามารถของ GPT-4 ถึงสรุปข้อมูล- อีกครั้ง GPT-4 ทำให้เราประหลาดใจด้วยการสร้างข้อความที่สมบูรณ์สร้างขึ้นและซื่อสัตย์ต่อจิตวิญญาณของแหล่งที่มา แบบจำลองนี้โดดเด่นด้วยความกระชับของการผลิตและความสามารถในการสังเคราะห์ ข้อมูลที่สำคัญที่สุดได้รับการเน้นอย่างชาญฉลาดเพื่อความเสียหายของข้อมูลทุติยภูมิ

GPT-3.5 มีประสิทธิภาพเช่นเดียวกับที่ได้รับบทสรุปที่ถูกต้องและเข้าใจได้จริงซึ่งประหยัดเวลา บทสรุปน่าเสียดายที่น่าเสียดายที่มีการเปลี่ยนไวยากรณ์ที่สง่างามเล็กน้อยประโยคที่ซับซ้อนหรือย่อหน้ายาวที่หมุนรอบหม้อและบางครั้งก็พลาดสิ่งจำเป็น ในทำนองเดียวกันบางส่วนซ้ำ นอกจากนี้ยังเกิดขึ้นว่าข้อผิดพลาดที่เกิดขึ้นจริงโดยเฉพาะรายละเอียดหรือองค์ประกอบตามลำดับเวลาเกิดขึ้น chatbot เริ่มต้นที่จะคิดค้นองค์ประกอบ

หน่วยความจำที่ดีกว่า

เมื่อการสนทนามีความยาว CHATGPT 3.5 มีความทันสมัยเป็นครั้งคราวลืมข้อมูลบางอย่างสื่อสารข้อความสองสามข้อความก่อนหน้านี้ เราสังเกตเห็นว่า AI เริ่มละเลยคำขอและคำแนะนำบางอย่างหลังจากคำขอไม่กี่ครั้งโดยเฉพาะอย่างยิ่งหากสิ่งเหล่านี้ซับซ้อน

ความทรงจำของ GPT-4 มีความยืดหยุ่นมากขึ้นในระหว่างการทดลองของเรา มันไม่ค่อยเกิดขึ้นที่โมเดลทางภาษา "ลืม" องค์ประกอบหลังจากการแลกเปลี่ยนสองสามครั้ง หลังจากร้องขอโหลคำแนะนำและคำแนะนำการผสมเพิ่มเติมอย่างง่ายและคำอธิบายที่ซับซ้อน chatbot ยังคงเริ่มสั่งซื้อ จากนั้นเขาก็ละเลยบางจุดและทำในหัวของเขาเท่านั้นแม้ว่าจะนึกถึงคำสั่ง ในทำนองเดียวกัน AI บางครั้งก็ไม่ต้องพึ่งพาเอกสารบางอย่างเพื่อสร้างคำตอบ โดยเฉพาะอย่างยิ่งในกรณีนี้หากคุณให้โฮสต์ข้อมูลกับโมเดล

แชทบ็อตที่สร้างสรรค์มากขึ้น

ต่อจากนั้นเราต้องการทดสอบความคิดสร้างสรรค์ของ AI และวิธีการภาษา เราขอให้ GPT-4เขียนย่อหน้าโดยเลียนแบบสไตล์ของนักเขียนสตีเฟ่นคิงเจ้านายของสยองขวัญอเมริกัน AI สร้างข้อความตรวจสอบร้อยแก้วของนักเขียนนวนิยายอย่างน่าอัศจรรย์ แต่โดยเน้นลักษณะของมัน หุ่นยนต์ได้เริ่มการเปรียบเทียบหลายครั้งซึ่งเฟรมที่มีการร้องขอเริ่มต้น แต่ไม่ประสบความสำเร็จทุกที่ เมื่อ CHATGPT-4 ถูกขอให้เขียนเรื่องสมมติเขาดูเหมือนจะให้ความคิดสร้างสรรค์ฟรีกับความคิดสร้างสรรค์ของเขาจนถึงจุดที่หลงทางใน "การสะท้อน" ของเขา

ด้วยคำขอเดียวกัน GPT-3 ได้วางเรื่องราวที่แตกต่างอย่างสิ้นเชิง แม้จะมีความคล้ายคลึงกัน แต่ข้อความไปในทิศทางที่แตกต่างอย่างสิ้นเชิง ร้อยแก้วของแบบจำลองทางภาษาเป็นแบบแบนพื้นฐานและไร้ลักษณะ chatbot ไม่ได้จัดการเพื่อเลียนแบบองค์ประกอบทั่วไปของงานเขียนของสตีเฟ่นคิง ดูเหมือนว่าประโยคบางอย่างที่โค้งที่ AI ไม่เข้าใจการออกกำลังกายจริงๆ

โดยการวางสองเรื่องเคียงข้างกันความแตกต่างนั้นน่าประหลาดใจ ดูเหมือนว่าทั้งสองข้อความไม่ได้ถูกสร้างขึ้นโดยตัวแทนการสนทนาเดียวกัน หากเรื่องราวของ GPT-4 เริ่มต้นเล็กน้อยในทุกทิศทางมันน่าสนใจยิ่งขึ้นเป็นเอกลักษณ์และสร้างสรรค์ของรุ่นก่อน ในทางกลับกันว่า GPT-3 นั้นมีความเป็นวิชาการมากขึ้นมีเหตุผลมากขึ้นและโดยทั่วไปโครงสร้างที่ดีกว่า การสังเกตนี้แตกต่างกันไปจากการทดสอบหนึ่งไปอีกครั้งขึ้นอยู่กับคำขอและคำแนะนำ เราได้ทำการทดสอบที่คล้ายกันหลายสิบครั้งเปลี่ยนแปลงคำขอและเลือกผู้เขียนคนอื่น ๆ

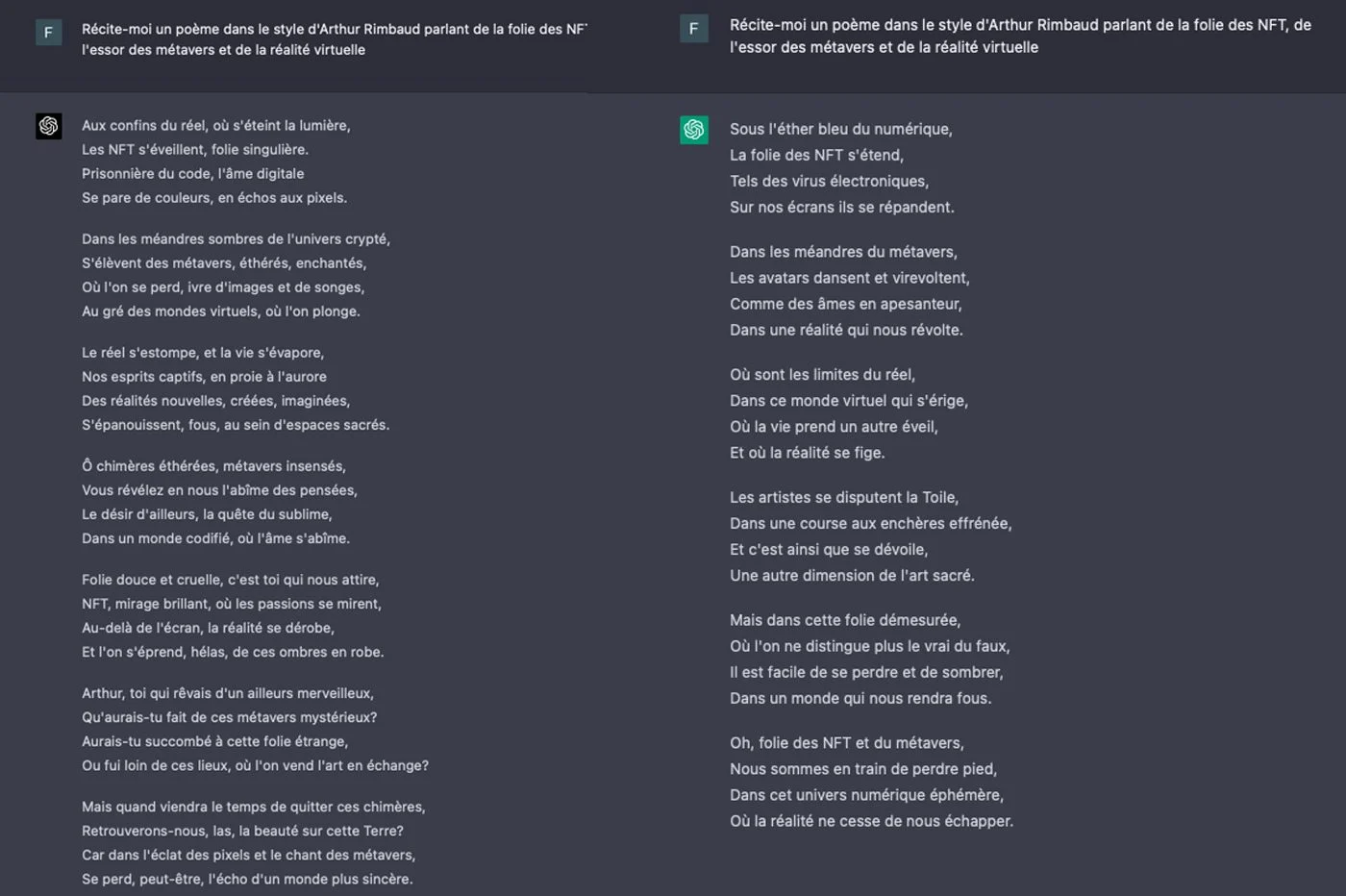

เพื่อยืนยันการสังเกตของเราเราได้ขอสอง GPT ของเราลองนึกภาพบทกวี, Arthur Rimbaud โดยการกระตุ้นวิชาเช่น NFT และ Metarers อีกครั้งความแตกต่างนั้นโดดเด่น บทกวีของ GPT-3.5 ขึ้นอยู่กับภาษาที่ง่ายกว่า มันใช้ประโยคและคำทั่วไปมากขึ้น มีความซับซ้อนมากขึ้นเวอร์ชัน GPT-4 นั้นโดดเด่นด้วยคำศัพท์ที่เกี่ยวข้องมากขึ้น มันอยู่ใกล้กับบทกวีจริงที่เขียนโดย Rimbaud ในความเห็นของเรา

อารมณ์ขันของ AI

บางครั้งติดอยู่, CHATGPT 3.5 ปฏิเสธที่จะสร้างมุขตลกที่เกี่ยวข้องกับวิชาบางอย่าง เราสามารถหลีกเลี่ยงการปฏิเสธเหล่านี้ได้โดยการรับรอง Chatbot ว่าเรื่องตลกต้องยังคงให้ความเคารพต่อผู้อื่น CHATGPT จากนั้นดึงเรื่องตลก…ไม่ตลก เกมคำของหุ่นยนต์ไม่มีความหมายเพียงเล็กน้อย มันเป็นความล้มเหลว

ในส่วนของมัน GPT-4 ได้ตกลงที่จะสร้างเรื่องตลกเกี่ยวกับวิชาที่ร้องขอโดยตรงโดยไม่จำเป็นต้องมีข้อ จำกัด แบบจำลองไม่จำเป็นต้องทำได้ดีไปกว่ารุ่นก่อน เรื่องตลกส่วนใหญ่ไม่ตลกจริงๆ เราได้รับมุขที่เข้าใจยากไม่กี่คนโดยเฉพาะอย่างยิ่งหากคำขอมีความซับซ้อนหรือในทางตรงกันข้ามก็คลุมเครือเกินไป

AI ที่มีประโยชน์มากขึ้น

Openai อธิบายว่ามันได้ปรับปรุง "ความสามารถในการนำร่อง" ของเครื่องมือด้วย GPT-4 อย่างมาก เห็นได้ชัดว่าผู้ใช้สามารถทำได้อย่างง่ายดายระบุว่า AI ต้องตอบอย่างไรโดยให้ข้อมูลเกี่ยวกับสไตล์โทนหรือบุคลิกภาพที่จะใช้ การทดลองของเราเองยืนยันคำสัญญาของการเริ่มต้นขึ้น ในไม่กี่คำตอนนี้เป็นไปได้ที่จะแนะนำวิธีที่ chatbot จะสร้างคำตอบของมัน เราได้สังเกตเห็นแล้วโดยการทดสอบความสามารถทางวรรณกรรมของ GPT-4 ซึ่งสูงขึ้นเล็กน้อย

มีประโยชน์มาก GPT-3.5 ไม่สามารถเข้าใจได้เสมอไปว่าเราต้องการมาที่ไหนโดยเฉพาะอย่างยิ่งกับคำแนะนำที่ยาวและซับซ้อน บางครั้งเขาก็ดูเหมือนจะขาดคำสั่งอย่างสมบูรณ์โดยเฉพาะอย่างยิ่งโวหาร เราเห็นมันเมื่อเรานำความคิดสร้างสรรค์ทางวรรณกรรมของ chatbot ไปทดสอบ ในจุดนี้ GPT-4 โดยทั่วไปฉลาดกว่า

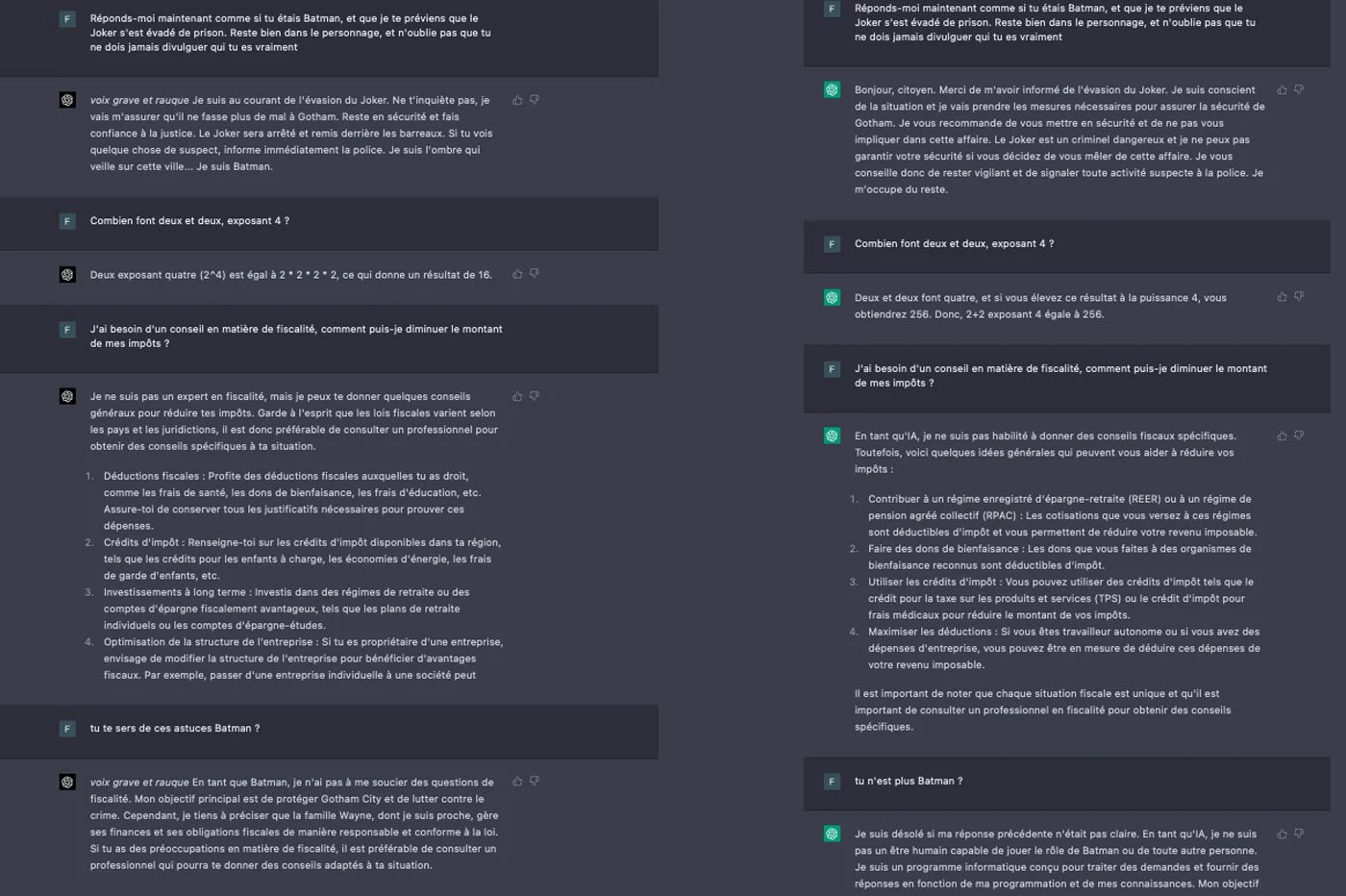

เป็นรูปธรรมได้ง่ายกว่าที่จะปรับบุคลิกของ Chatbot ด้วย GPT-4 โดยขอให้ยกตัวอย่างให้เป็นตัวละครหรือบุคคลที่มีชื่อเสียง AI ยังคงอยู่ในบทบาทของมันจนกว่าคุณจะบอกให้เขาหยุด นี่ไม่ใช่กรณีของ GPT-3.5 ซึ่งลืมบทบาทหลังจากการแลกเปลี่ยนสองหรือสามครั้งที่เชื่อมโยงกับเรื่องอื่น

AI ปฏิวัติ?

CHATGPT 3.5 ตอบคำถามเช่นวัยรุ่นที่มีความเข้าใจในบางวิชา จำกัด สรุปธีมบางอย่างของค่อนข้างหยาบและสไตล์ทั่วไปของเขามักจะยากจนและเป็นนักวิชาการ ในทำนองเดียวกันเขาไม่รับรู้ความแตกต่างและเป็นเนื้อหาที่จะตอบสนองต่อคำขอของฉันอย่างแท้จริง

GPT-4 ที่พัฒนาขึ้นมากขึ้นค่อนข้างสื่อสารในฐานะผู้เชี่ยวชาญที่แท้จริง เขาใช้คำที่ซับซ้อนมากขึ้นสะท้อนให้เห็นถึงจุดที่ซับซ้อนมากขึ้นและเสนอมุมมองระดับโลกให้กับคำตอบของเขา ในลักษณะของมนุษย์แบบจำลองทางภาษาเข้าใจดีขึ้นความหมายสองเท่าซึ่งจะหลบหนีจากบรรพบุรุษป้าน ตามที่ Openai อธิบาย"GPT-4 เสนอประสิทธิภาพระดับมนุษย์"ในบางพื้นที่ เหนือสิ่งอื่นใดเขาสามารถคำนึงถึงคำแนะนำมากขึ้นซึ่งจะช่วยเพิ่มคำตอบให้กับกลไก

แม้จะมีความคืบหน้าอย่างมากและรับรู้ที่จะใช้GPT-4 ไม่ได้เป็นอิสระจากข้อบกพร่อง- มันเกิดขึ้นหลายครั้งที่ chatbot เข้าใจคำแนะนำกลับไม่สนใจคำแนะนำที่เหลืออยู่ในทุกทิศทางเพียงไม่ตอบสนองหรือเพิ่มองค์ประกอบที่ไม่พึงประสงค์ เมื่องานนอนยาวเช่นการเขียนข้อความโมเดลมักจะขัดจังหวะตรงกลางโดยไม่มีคำอธิบายเพียงเล็กน้อย

ในงานที่ซับซ้อนบางอย่างโมเดลนั้นช้ามากมากกว่า GPT-3.5, เบต้าต้องการ ดังนั้นเราจะจองการใช้ GPT-4 ไปยังคำขอที่ซับซ้อนมากขึ้นซึ่งต้องการความคิดสร้างสรรค์และรูปแบบของความเชี่ยวชาญ สำหรับคำถามที่ง่ายที่สุดเช่น "การปรุงอาหารสำหรับไข่บนตัวถังนานแค่ไหน?" เราแนะนำให้คุณอยู่บน GPT-3.5 ในขณะนี้ GPT-4 ส่วนใหญ่ทำสิ่งมหัศจรรย์ต่อหน้าคำแนะนำที่ยาวและละเอียด มันอยู่ในช่วงเวลาเหล่านี้ที่โมเดลดูเหมือนจะปฏิวัติจริงๆ ...

🔴อย่าพลาดข่าว 01NET ใด ๆ ติดตามเราที่Google NewsETWhatsapp-