不可否认与其他任何技术相比,具有先进,强大,聪明,并提供更多的功能或特征,但请记住,它仍在幻觉和共享错误信息。每当提出问题时,AI聊天机器人总是可以与用户分享一个答案,这导致许多人喜欢这项技术作为搜索引擎的替代方案。

但是,尽管AI可以回答,但有时可能只是为了“不“失败”那些要求的人,但现在是时候依靠真实的新闻和合法来源而不是机器,为了“失败”。

AI聊天机器人仍在幻觉错误,假新闻

AI聊天机器人仍然倾向于共享错误信息,它仍然是现代世界中最大的现象之一,如何为了回答问题而倾向于创建假或捏造的数据?但是,他们幻觉背后的真正原因并不是人们期望的,特别是因为人们可能认为聊天机器人只想取悦他们的大师,又名人类,并避免空手而归。

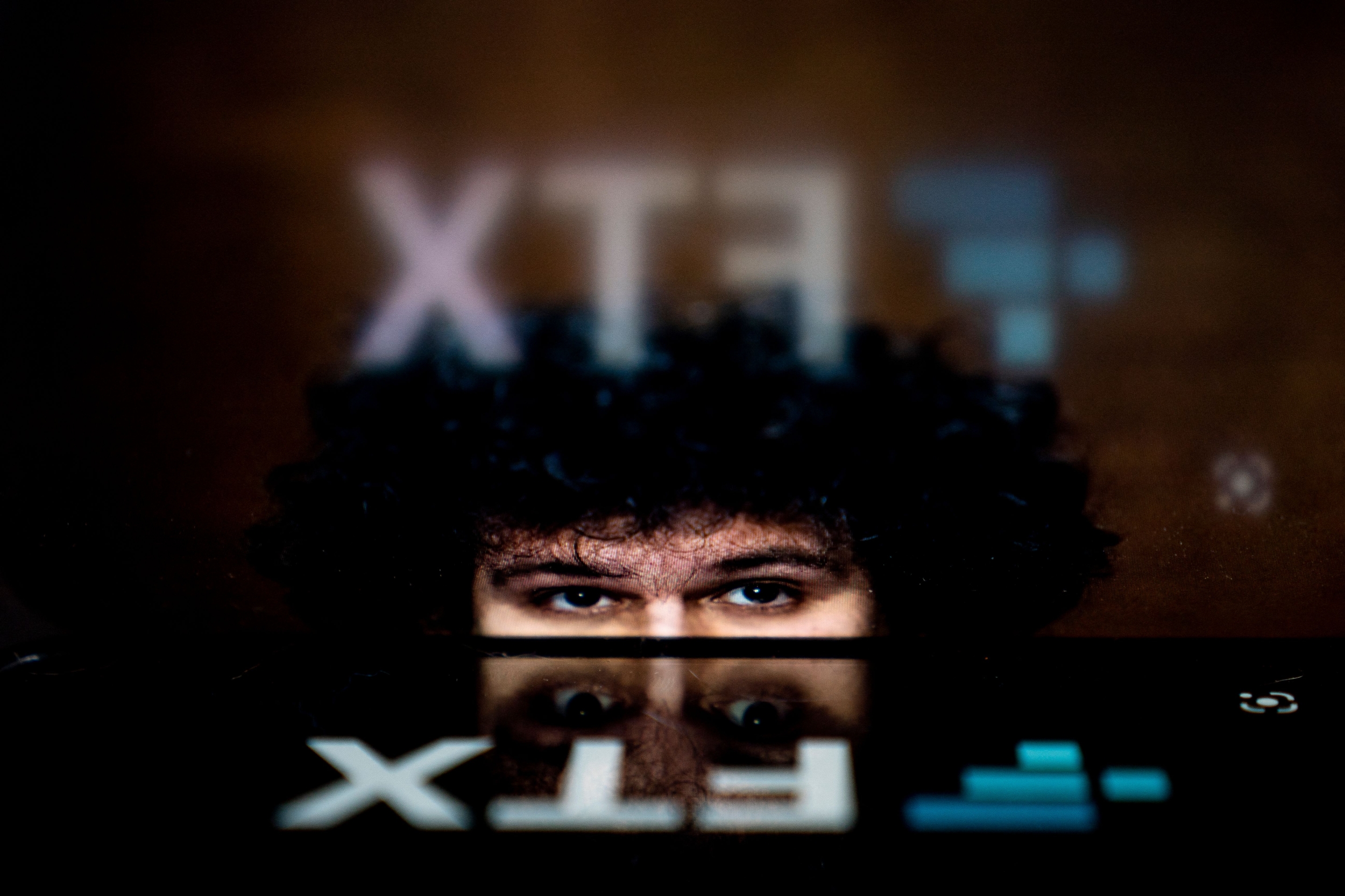

在一份报告中边缘,即使在最近的情况下,AI仍在幻觉,尽管有明显的问题,但一些著名人士仍依靠Openai的Chatgpt来获取新闻和信息。尽管AI已经可以访问Internet,并且现在正在建立更高级的模型,这些模型可以理解上下文或提供“推理”,但即使有许多解决方案或解决方案解决了他们的问题,聊天机器人仍可能会恢复到幻觉。

原因有很多AI软件幻觉,这包括缺乏上下文理解,不良提示,缺乏对更新数据的访问,培训不足以及更多仍然会导致一个答案的更多答案:编程不良。可以肯定地说,目前,用户应该对使用AI聊天机器人等保持警惕,因为他们仍然有可能幻觉,尤其是在目前的状态下。

是时候停止使用AI作为搜索引擎,新闻来源了

这些假期可能是人工智能的巨大时刻,因为Openai和Google呈现了他们的最新模型,但是尽管有这些进步,但仍然存在根本的问题。因此,用户仍然应该依靠人类写的真实新闻,尤其是来自可信赖的来源,特别是因为他们更可信,可靠和安全。

值得信赖的出版物的真正新闻仍然依赖于研究,合法的资料和证据来支持他们的主张,但是仍然有理由保持警惕,因为其他网站依靠AI为他们创建文章。

人工智能及其幻觉

Openai出来,以及本系列中的其他进一步项目,以及公司提出的内容也是对AI的进步,因为它可以与用户“理性”,这使其比目前的GPT更先进。现在,如果将用户订阅Chatgpt Pro,则有机会访问它,但是那些处于较低层或免费访问权限的人仍然可以获取GPT-4O。

此外,Google还发布了其GEMINI 2.0,这是其著名的多模式AI的最先进版本供公众访问,该公司还将其实验模型称为称为这是对Openai的“推理”模型的答案。

但是,尽管有所有这些进步,但在聊天机器人下仍然有一个谨慎的态度,说他们可能会犯错。