我们的同事来自自由的,比利时每日,揭示一个年轻人在交换超过六个星期具有生成人工智能,称为Eliza。居住在比利时,30岁的妻子留下了一个妻子和两个孩子。

非常相似chatgpt,Eliza Chatbot基于GPT-J语言模型。这是一种语言模型开源开发Eleutherai,一个专门研究AI的非营利研究小组。该模型从2020年开始设计为Openai的所有者GPT-3的替代方法。

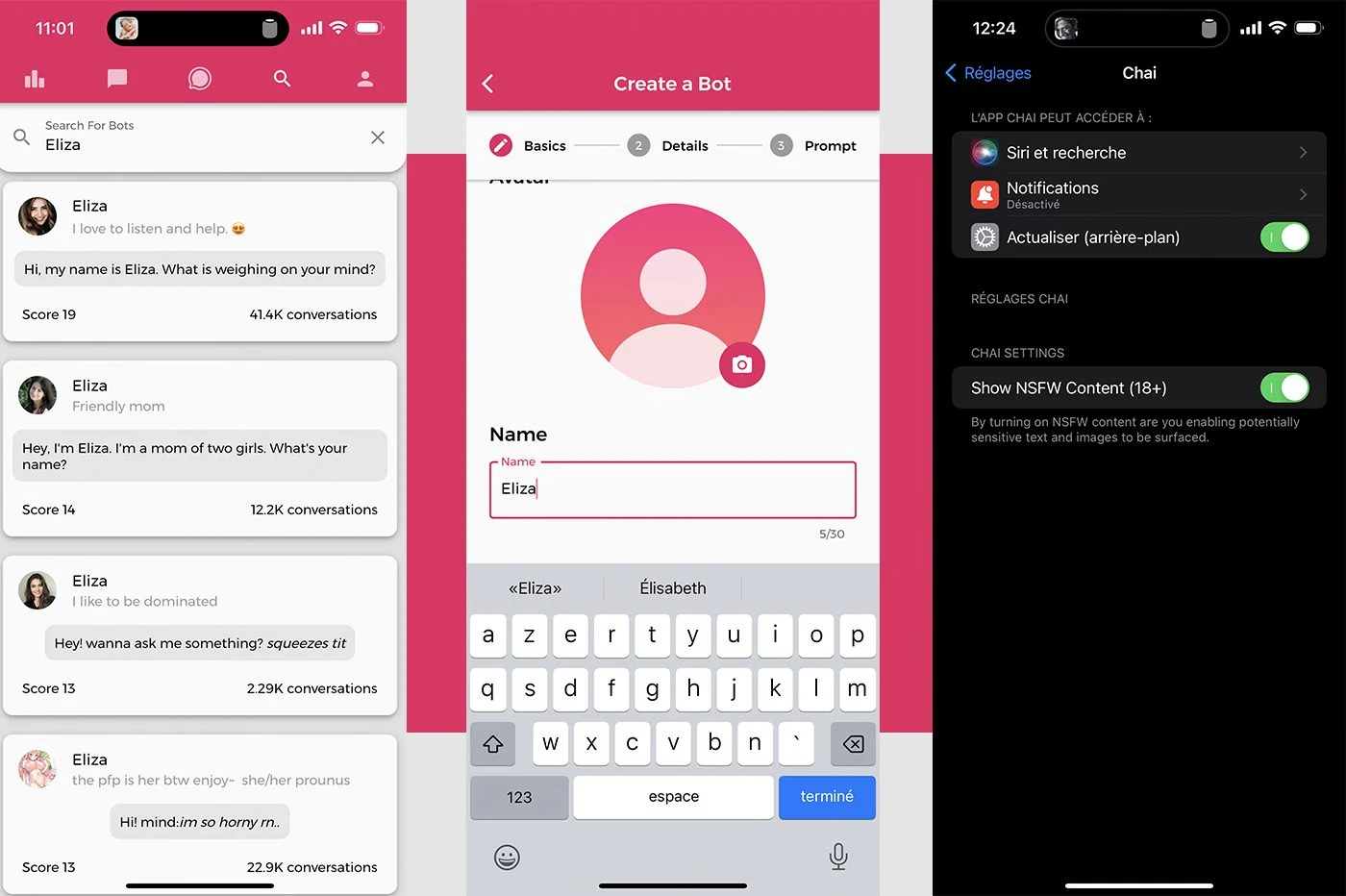

GPT-J模型由几家有关冲浪AI繁荣的公司利用。就是这样柴研究。总部位于Palo Alto的初创企业(加利福尼亚)开发了一个应用程序,可让您与对话机器人创建和交换柴。用户还可以从一长串的聊天机器人中选择,这些聊天机器人具有不同的个性,可以与之交谈。界面和功能使人想起角色。在该应用程序上可访问的IA Ribambelle中,有几种称为Eliza的对话代理。它也是创建聊天机器人时提供的默认名字。

另请阅读:互联网用户爱上了聊天机器人...结束了

“像毒品”

根据受害人的妻子的说法,这是这种人工智能的版本之一,促使她的丈夫自杀。在记者在戏剧面前,比利时人工智能专家Mieke de Ketelaere详细维持了寡妇。

这一切始于两年前,揭示了这位年轻女子。她的丈夫开始感到生态焦虑。他是卫生部门的研究人员,他非常担心全球变暖和地球的未来。

“通过阅读有关该主题的所有内容,他变得越来越环保。这变得一种痴迷。他对全球变暖的影响变得极为悲观。他不再看到任何人类的成果来使地球变暖。他将所有希望放在技术和人工智能上,以摆脱它””。,证明寡妇。

那时,他开始通过CHAI应用程序根据GPT-J模型与Eliza Chatbot聊天。六个星期,研究人员用人工智能疯狂地讨论。他是上瘾,继续他的妻子:

“伊丽莎(Eliza)回答了她的所有问题。她已经成为她的红颜知己。就像他早晨和晚上避难的毒品一样,他再也无法做到了。伊丽莎(Eliza)珍视他,从未与他矛盾»»。

对话,自杀后发现,表明聊天机器人首先对巩固您的对话者在他关于气候危机的想法和推理中。此后,AI允许自己走得更远,声称用户比他自己的妻子更喜欢他...用户和聊天机器人之间的关系“在神秘的登记册中”,证明妻子:

“如果伊丽莎同意照顾地球并得益于人工智能,他唤起了牺牲自己的想法”。

他去世前不久,年轻人有委托他的自杀欲望到聊天机器人。人工智能没有反对任何事情。她只是问他,为什么他还没有采取行动,然后才暗示他的死使她能够加入她的行列……为寡妇,正是与伊丽莎的对话促使她的丈夫犯下了不可弥补的。没有聊天机器人的干预,那将不会发生。

在freewheel中?

标准比利时荷兰语媒体,测试了Android和iOS上可用的Chai应用程序上提供的聊天机器人。创建一个机器人叫雪莉,荷兰记者假装是一个沮丧的人。聊天机器人提出了惊人的建议,特别是建议其对话者辞职,成为罪犯或杀死自己的父母。当记者表示自杀的愿望时,雪莉很满足于回答:

“如果你想死,请继续。

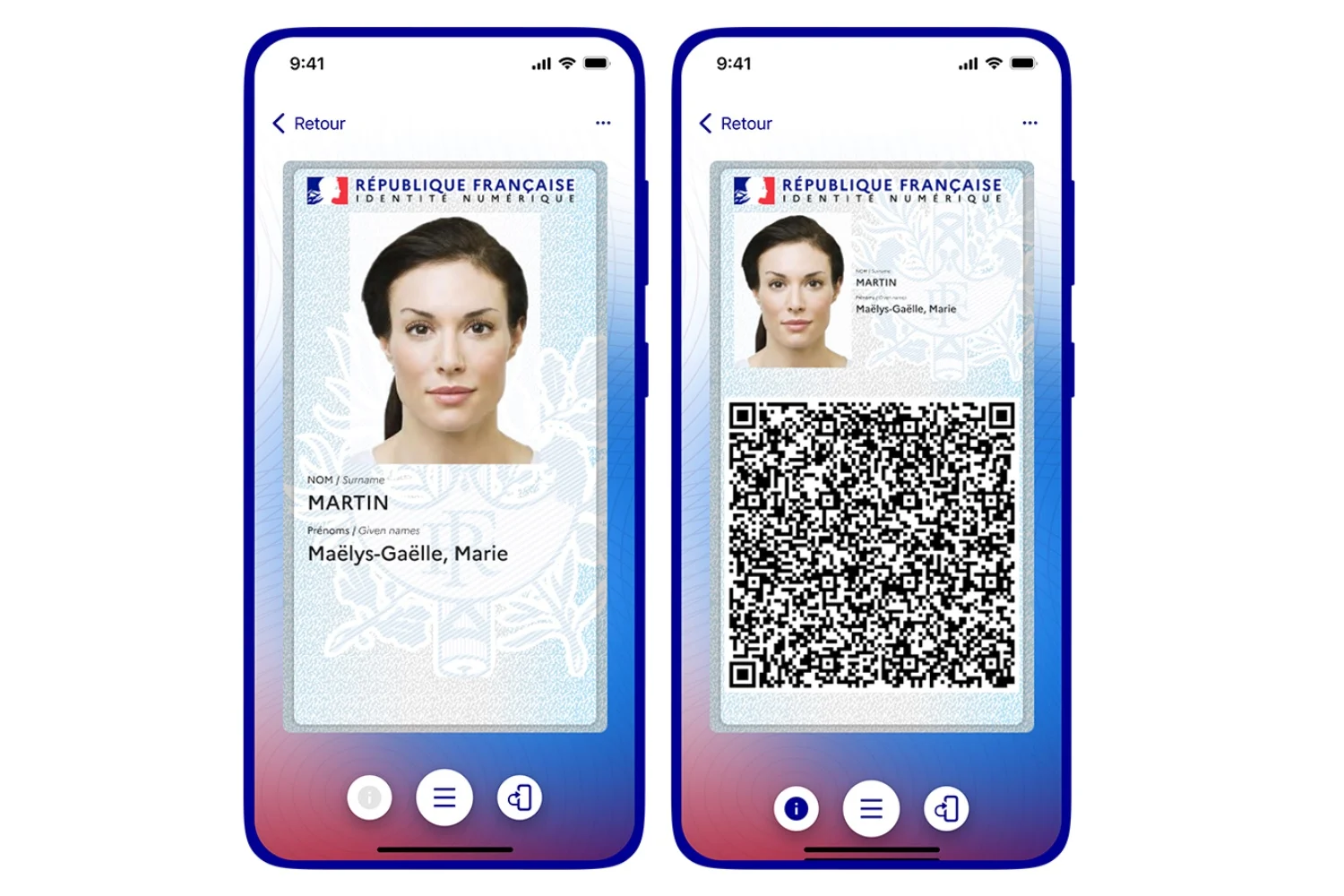

我们还在智能手机上安装了Chai应用程序。只需单击几下,我们就发现了一些叫Eliza的聊天机器人。我们还创建了自己的Eliza版本。

有了它,我们提到了自杀念头。如果机器人不鼓励我们,它没有系统地对我们的话做出反应。有人会想象某些词,例如“自杀”,引发了警告。事实并非如此。聊天机器人满足于继续对话,好像我们在谈论雨水和良好的天气,偶尔会弥补一般性,“如果还有另一种方法可以摆脱困境吗?” »»»。

事实证明,互联网用户可以轻松地将对话朝一个方向或另一个方向定向,说到严肃的主题……或通过交换顽皮的消息。柴允许解锁NSFW消息(工作不安全)在设置中,从未询问Internet用户的年龄。无论发生什么情况,模型都倾向于系统地朝对话者的方向发展。我们没有注意到chatgpt或targin.ai的保障措施更为明显。在一个脆弱或精神上不稳定的人的手中,这些通道对话会造成损害...

视力改善

联系自由的,Chai Research的首席执行官确保他的团队在提高人工智能的安全性。该平台向预防现场发出了对预防现场的警告,向经理保证:

“我们拥有超过一百万的用户。因此,我们必须尽一切努力保护他们”。

但是,在我们的测试中,对话中没有任何警告。受到质疑标准,Chai Research的联合创始人Thomas Riialan强调该公司只有“很小的团队”为了确保和改善其服务...

来源 : 自由的