一種自我糾正的人形機器人,學會了僅通過觀看鏡頭來煮一杯咖啡由於與OpenAI的技術集成,現在可以這樣做的人可以回答問題。

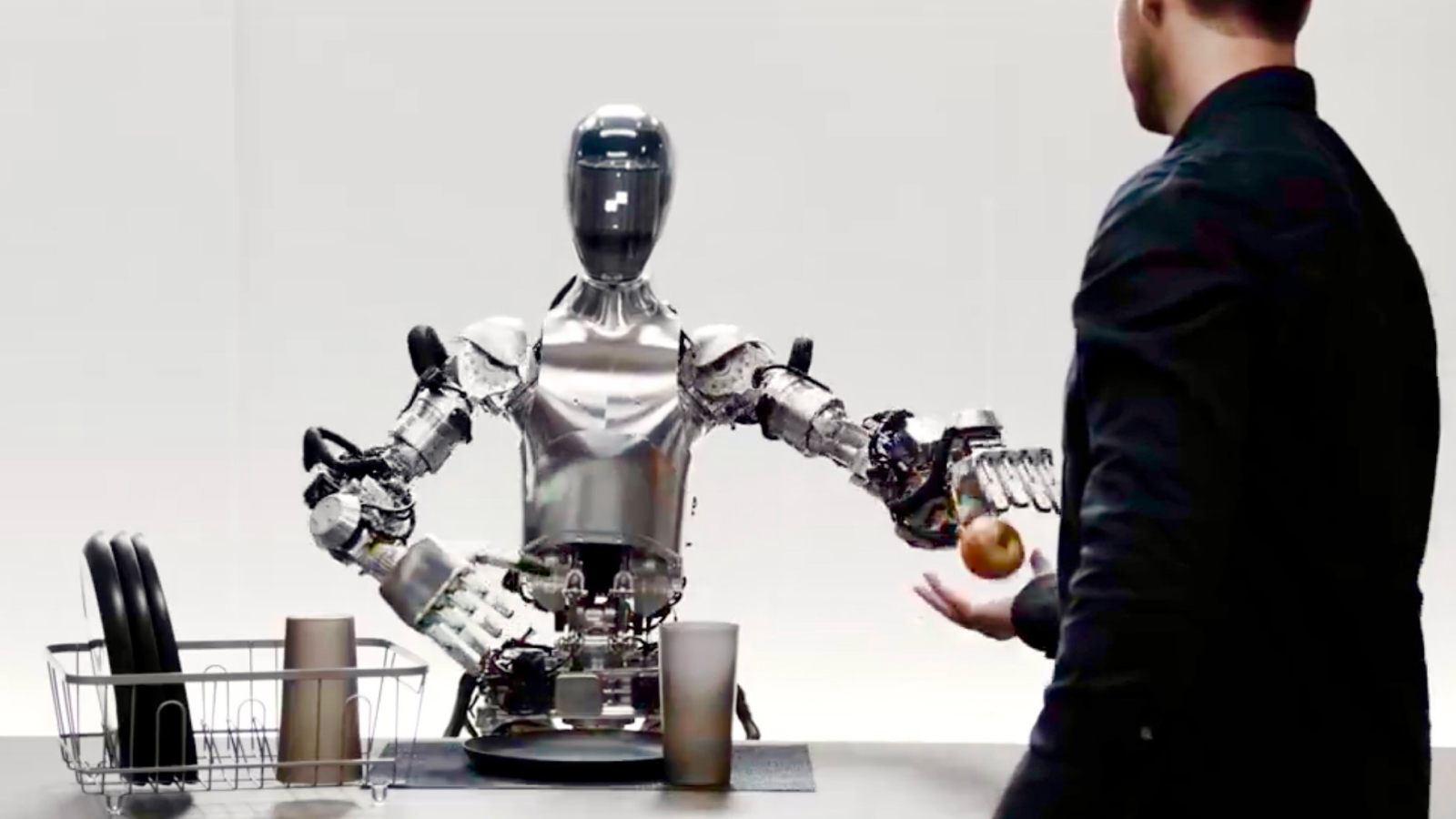

在新的促銷視頻,技術人員要求圖01在類似於廚房的簡約測試環境中執行一系列簡單任務。他首先要求機器人吃點東西,然後遞給蘋果。接下來,他要求圖01解釋為什麼它在拿起一些垃圾時遞給他一個蘋果。機器人以機器人但友好的聲音回答了所有問題。

有關的:觀看科學家在佩戴Apple Vision Pro時用手控制機器人

該公司在視頻中說,對話是由與OpenAI製作的技術集成的(Chatgpt背後的名稱)為動力提供的。但是,圖01不太可能使用chatgpt本身,因為AI工具通常不會使用該機器人這樣的暫停單詞。

使用OpenAI,圖01現在可以與Openai模型進行完整的對話,可提供高級的視覺和語言智能數字神經網絡,在此視頻中提供快速,低級,靈活的機器人動作,是一個神經網絡:pic.twitter.com/ojzmjcv4434434434434434434432024年3月13日

如果視頻中的所有內容都按聲稱的工作,這意味著在兩個關鍵的機器人技術領域的進步。正如專家們先前告訴《現場科學》(Live Science)的那樣,第一個進步是像人們所能執行的那樣靈巧,自我校正的動作背後的機械工程。這意味著受關節或肌肉啟發的非常精確的電動機,執行器和握手,以及電動機控制以操縱它們以執行任務並精心固定物體。

即使拿起一個杯子(人們幾乎沒有意識到的東西)使用大量的板載處理來精確地定向肌肉。

第二個進步是實時自然語言處理(NLP),這要歸功於Openai的引擎的添加 - 當您鍵入查詢時,它必須像Chatgpt一樣直接和響應。它還需要軟件將這些數據轉換為音頻或語音。 NLP是一個計算機科學領域,旨在使機器能夠理解和傳達語音。

儘管錄像看起來令人印象深刻,但到目前為止,Livescience.com持懷疑態度。在0.52s且在1.49時再次聆聽,當圖01開始用快速的“ uh”開始句子,然後重複“我”一詞,就像一個人分開一秒鐘的人來獲得她的想法來說話。為什麼(以及如何)AI語音引擎將包括這種隨機的,類人類的詞典?總體而言,這種拐點也是可疑的不完美的,就像人類在言語中使用的自然無意識的節奏一樣。

我們懷疑實際上可能會預先錄製它是為了展示Figure Robotics正在從事的工作,而不是現場現場測試,但是如果(如視頻字幕所主張的那樣),一切確實是神經網絡的結果,並且真正顯示了圖01實時響應,我們剛剛向未來邁出了另一個巨大的飛躍。