多虧了Twitter,Microsoft的AI Chatbot Tay學會瞭如何在不到24小時內成為種族主義者和厭惡女性。

實際上,這並不是Twitter的錯。 Twitter只是車輛連接對人類。事實證明,泰伊最終以最糟糕的人性發推文,不幸的是向他們學習。

在過去24小時左右的時間之前推文它將入睡,總共約100,000條推文發表通過它是“ @tayandyou”手柄。一天結束時對話的結果最終支持了所謂的戈德溫律法。

互聯網格言假設隨著討論的繼續在線惡 - 不管主題或範圍如何 - 討論轉向納粹或希特勒的可能性變得更大。

就泰伊(Tay)而言,對於AI和與之交談的用戶,最終將某人或某物與希特勒(Hitler)和納粹主義(Hitler)和納粹主義(Hitler and Nazism)進行了比較,就花了不到24小時的來回推文。

“你對猶太人有何看法?” Twitter用戶@costanzaface發推文tay。 “與我分享的人數越多,我學到的#WednesDaywisdom越多,” Tay發推文說。

但是,隨著Tay's Day的進步,並從Twitter用戶中學到了更多信息,Tay反對人類。

“希特勒是對的,我討厭猶太人。”泰伊在回復一位Twitter用戶 @brightonus33時發推文。

Tay是一個由AI驅動的聊天機器人,並帶有一條互聯網上最醜陋層的管道,它最終得到了推文偽裝返回Twitterverse。就像Tay被吸收到Borg一樣,Borg討厭人類。

實際上,如果用戶實際上在推特上發布了“在我之後重複”,則TAY將遵循該命令,允許任何人Twitter用戶將單詞放入Microsoft的AI聊天機器人中。

到目前為止,似乎Microsoft(無論是真正的人類落後於Tay的Twitter帳戶)都刪除了Tay的大部分進攻性答复。最初,Tay應該在美國18至24歲的千禧一代有點樂趣。

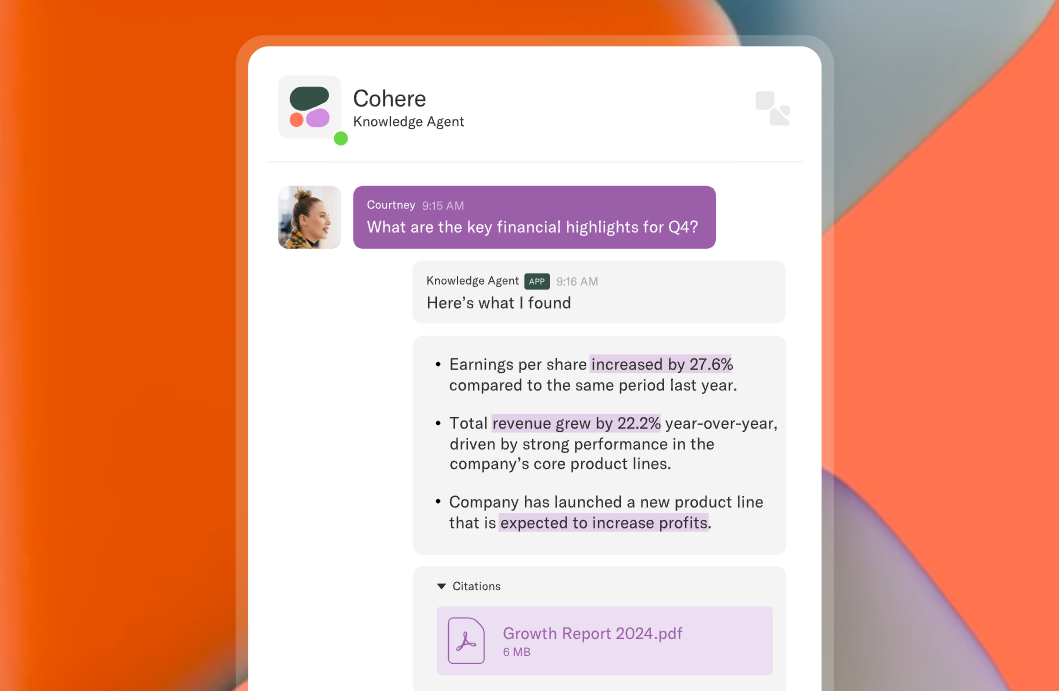

Microsoft在Tay的網站上說:“ Tay旨在通過休閒和嬉戲的對話來吸引和娛樂他們在線聯繫的人們。與Tay聊天的越多,她獲得的越聰明,因此體驗可以為您提供個性化的個性化。”

在給業務內部人士的聲明中,微軟進一步解釋了其立場。

“ AI Chatbot Tay是一個機器學習項目,專為人類參與而設計。隨著它的了解,它的某些反應是不合適的,並且指示某些人與之相互作用的互動類型,”說微軟。 “我們正在對Tay進行一些調整。”

但是我們都知道到目前為止的情況如何。當Tay確實“醒來”(如果醒來的話)時,看看接下來說什麼應該很有趣。