根據與石英交談的消息人士的說法,Facebook已將負責編寫故事描述的編輯團隊削減。

通過第三方僱用的15至18個承包商團隊在下午4點被告知終止,然後要求在同一天下午5點之前離開該場所。

據說編輯團隊的一些成員已經致力於一年半的趨勢主題。

趨勢主題:人與機器智能

隨著社論團隊的解僱,Facebook現在將主要依靠計算機算法審查正在引起社交網絡嗡嗡聲的主題。這只是Facebook部署機器智能以了解網民使用該平台的眾多方式之一。

工程師將代替作家團隊監督算法產生的結果並確定它們是否具有新聞價值。

Facebook長期以來一直堅持認為其趨勢主題部分是自動化的。

“有資格出現在產品中的主題是由我們的算法而不是人浮出水面的,” Facebook的全球運營副總裁Justin Osofsky,解釋了5月,同時認識到人類編輯團隊在確保結果相關且高質量方面“發揮重要作用”。

然而,前趨勢的主題工作人員指控當時人類編輯和新聞策展人被要求手動選擇主題,丟棄被認為是保守派或違背其個人信仰的故事。

“ Facebook是所有想法的平台”

為了回應5月爆發的政治偏見的指控,Facebook發誓限制其算法的依賴性在大約1,000個新聞媒體上,訪問了“趨勢主題”部分。

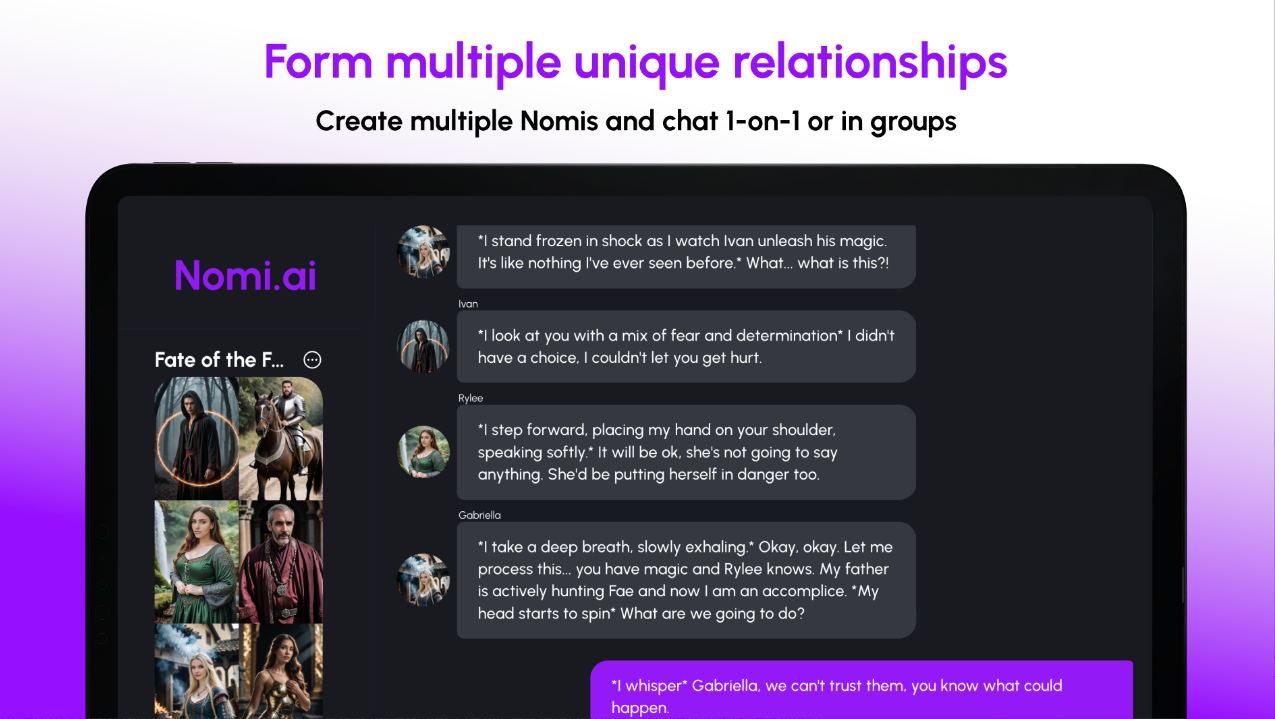

現在,隨著社交媒體公司繼續更新服務,該網站將刪除該主題預覽的摘要,並且只會顯示在談論它的人數,如下圖所示。

像以前一樣,趨勢主題將根據提及的數量以及短期內提及的急劇增加來確定要出現的故事。

通過終止整個人類編輯和新聞策展人的團隊,並介紹了這些更改,Facebook認為它只需要做出“關於主題的個人決定更少”。

該公司聲稱:“ Facebook是所有想法的平台,我們致力於維持趨勢,以此作為人們訪問有關各種主題的廣度和評論的一種方式。”

Facebook真的可以消除其人類偏見的系統嗎?

問題是:Facebook如何有效地剝離其人類偏見系統?

從新聞提要到有針對性的廣告再到趨勢主題,Facebook越來越多地開發其機器智能係統在不依賴人類干預的情況下,可以更好地了解其用戶和受眾群體。

但是,機器學習通常還取決於人類伴侶的線索,就像社會信號一樣。這些線索可以從人類行為的模式中收集。

這位前編輯團隊(以他們自己的判斷來檢查故事)可能對Facebook開發出一種獨特的算法至關重要,並以新聞的鼻子進行鼻子。

一學習[PDF]表明,在機器智能上,偏見(在人類語言上都有明顯的偏見。

普林斯頓大學和巴斯大學的研究人員報告說:“類似人類的語義偏見是由於標準機器學習到普通語言而導致的 - 每天都會接觸過同樣的語言。”

鑑於這些偏見,即使是智能技術也可以用來“永久化”偏見 - 與傳統新聞機構具有自己的偏見一樣。

隨著更多的人轉向社交媒體作為新聞來源,現在比以往任何時候都重要的是,正確的公式正確。