透過將浮點運算標準形式化為 8 位元而不是 16 位元甚至 32 位元,ARM、英特爾和 AMD 三巨頭將加速人工智慧訓練。由於計算和記憶體需求的減少,該頻段降低了這些操作的財務和經濟足跡。

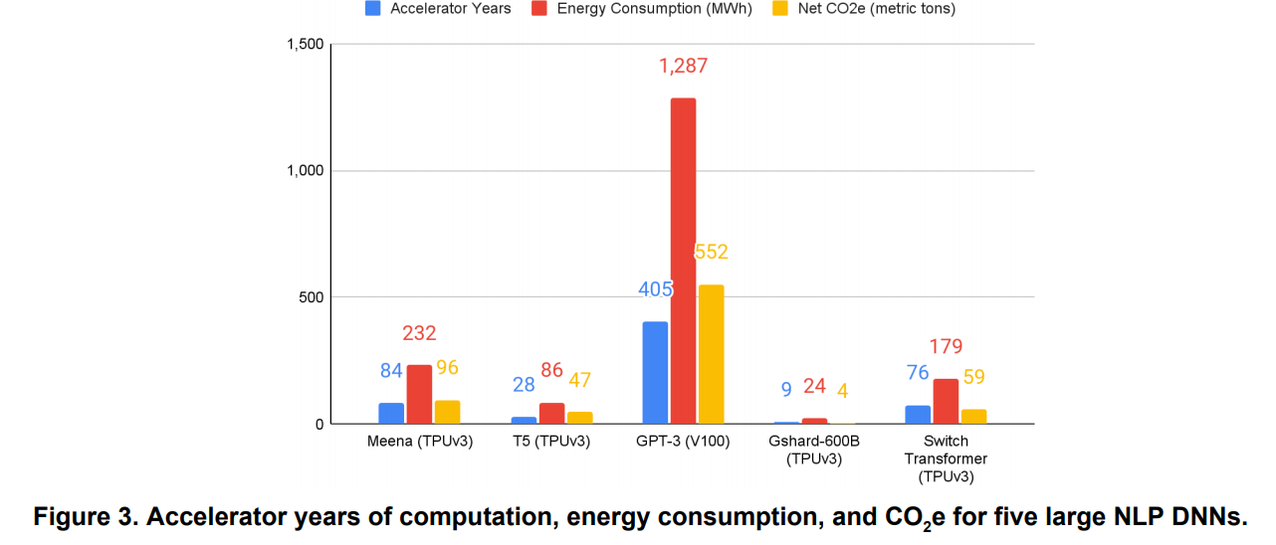

訓練人工智慧需要越來越多的時間,在機器時間和能源足跡方面的成本也越來越高。為了解決這個問題,ARM、Intel 和 Nvidia 等巨頭已就 8 位元浮點運算標準 FP8 達成協議。在一份聯合出版物中,這三家公司甚至免費提供了 FP8 標準。這遠非純粹的慈善事業,而是相當合乎邏輯的:他們(直接或間接)出售晶片來進行這些計算。

對於那些透過 AI 計算中的位數(NES 為 8 位,SuperNes 為 16 等)來衡量遊戲機性能的人來說,增加精度並不一定是萬能的,這或許與直覺相反。根據這三家公司的研究人員的說法,FP8 的計算結果是“快樂的媒介» 結果的品質和所需的運算能力之間的關係。 Nvidia 官員解釋說 FP8 提供“可比精度» 電腦視覺任務或影像產生系統(如 Dall-E)中的 16 位元計算。同時允許加速“重要的» 這些計算。

與影像相關的任務相比,更青睞 FP8 運算並非憑空而來,這點已在業界達成共識。例如,高通公司已經傾向於在其性能測量測試中運行 FP8。也認為這種精確度是“充足的»。

從技術層面來說,降低運算精度意味著加快任務執行速度。這種加速透過反彈提供了另一個優勢:限制處理器(CPU、GPU、AI)的使用時間/數量。然而,GPT-3等訓練模型的改進和複雜性推高了財務和能源費用。工程師和研究人員有時花費數十萬甚至數百萬歐元或美元來訓練人工智慧。我們每天受益的訓練:相機的場景或主題識別等。

如果 FP8 標準化有效,也不要完全高興。這將限制「損害」並允許軟體和硬體(日益優化和高效的晶片)取得重大進展。但這也將降低入門價格,並鼓勵此類計算在更多行業中推廣。

來源 : Techcrunch.com