我們的同事來自自由者比利時日報報道,一名年輕人在交換時間超過六週擁有生成式人工智慧,名叫 Eliza。這名三十歲的男子住在比利時,留下了妻子和兩個孩子。

非常類似聊天GPT,Eliza 聊天機器人是基於 GPT-J 語言模型。這是一個語言模型開源開發者埃魯瑟人工智慧,一個專門研究人工智慧的非營利研究小組。該模型被設計為從 2020 年起替代 OpenAI 的專有解決方案 GPT-3。

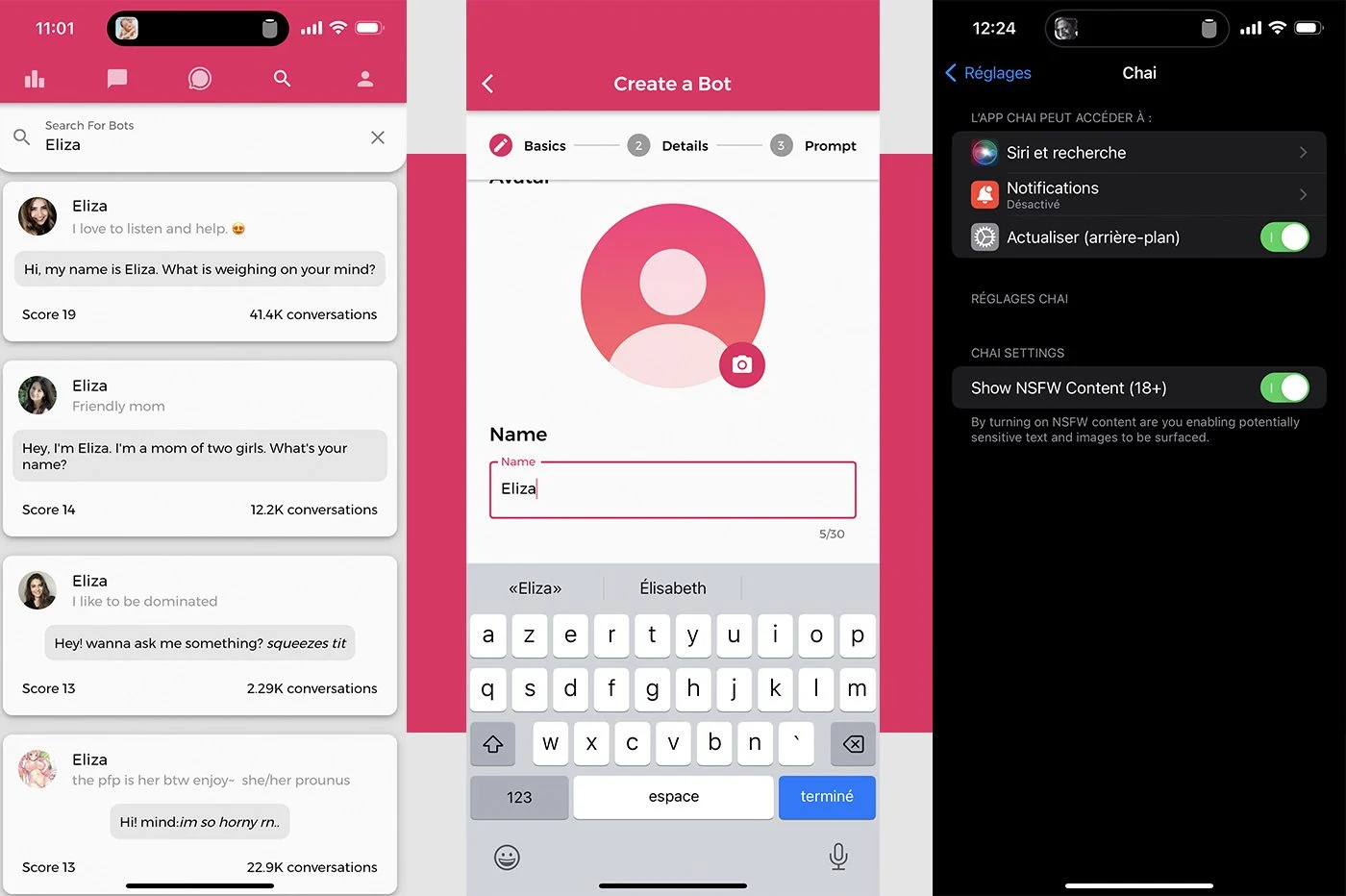

GPT-J 模型被多家熱衷於人工智慧熱潮的公司所採用。情況是這樣的柴研究。這家位於帕洛阿爾托(加利福尼亞州)的新創公司開發了一款應用程序,可讓您創建對話機器人並與其進行交流,柴。用戶還可以從一長串具有不同個性的聊天機器人中進行選擇進行交談。介面和功能有點讓人想起角色.ai。在該應用程式上可存取的眾多人工智慧中,有幾個名為 Eliza 的對話代理。這也是創建聊天機器人時提供的預設名稱。

另請閱讀:網路使用者愛上了聊天機器人…但結局很糟糕

“就像毒品一樣”

據受害者的妻子稱,正是這種人工智慧的版本之一促使她的丈夫自殺。這位遺孀在記者面前與比利時人工智慧專家 Mieke De Ketelaere 詳細談論了這場悲劇。

這位年輕女子透露,這一切都始於兩年前。她的丈夫開始覺得生態焦慮。身為衛生部門的研究員,他非常擔心全球暖化和地球的未來。

「當他閱讀了有關該主題的所有內容時,他變得越來越對生態感到焦慮。這成了一種痴迷。他對全球暖化的影響變得極為悲觀。他不再看到任何人類解決全球暖化的辦法。他把所有的希望都寄託在技術和人工智慧上,以擺脫困境。,寡婦作見證。

從那時起,他開始透過 Chai 應用程式與基於 GPT-J 模型的 Eliza 聊天機器人聊天。六個星期以來,研究人員瘋狂地與人工智慧聊天。他是上癮了”,他的妻子繼續說:

「伊麗莎回答了他所有的問題。她成了他的紅顏知己。就像一種藥物,他早晚都靠它來庇護,而他再也離不開它了。伊麗莎很重視他,從不反對他»。

自殺後發現的對話表明,聊天機器人最初滿足於安慰你的對話者他對氣候危機的想法和推理。隨後,人工智慧允許自己走得更遠,確認用戶愛他勝過愛自己的妻子……用戶和聊天機器人之間的關係已經“轉移到一個神秘的寄存器”,妻子作證:

“如果伊麗莎同意借助人工智慧來照顧地球並拯救人類,就會讓人產生犧牲自己的想法”。

就在這位年輕人去世前不久,吐露了他的自殺願望到聊天機器人。人工智慧沒有反對任何事情。她只是問他為什麼還沒有採取行動,然後暗示他的死可以讓他與她團聚……對於寡婦來說,正是與伊麗莎的談話促使她的丈夫犯下了不可挽回的罪行。如果沒有聊天機器人的介入,事情就不會走到這一步。

隨心所欲?

標準比利時荷蘭語媒體機構測試了 Chai 應用程式上提供的聊天機器人,該應用程式可在 Android 和 iOS 上使用。創建後名叫雪莉的機器人現場,荷蘭記者假裝自己是個鬱悶的人。該聊天機器人提出了令人驚訝的建議,包括建議對話者辭職、成為罪犯或殺死自己的父母。當記者表達了自殺的念頭時,雪莉簡單地回答:

“如果你想死,那就去死吧”。

我們還在智慧型手機上安裝了 Chai 應用程式。只要點擊幾下,我們就找到了一些名為 Eliza 的聊天機器人。我們還創建了我們自己的 Eliza 版本。

透過這個,我們討論了自殺的想法。如果機器人不鼓勵我們,它就不會系統地對我們的評論做出反應。人們可能會想像某些詞,例如“自殺”,會引發警告。事實並非如此。聊天機器人很樂意繼續對話,就好像我們在談論下雨或好天氣一樣,偶爾會說一些籠統的話,例如和「如果有其他方法可以擺脫困境怎麼辦? »。

事實證明,網路使用者可以透過談論嚴肅或輕鬆的話題…或透過交換頑皮的訊息,輕鬆地將對話引向一個或另一個方向。柴可以讓你解鎖 NSFW(工作不安全)訊息在設定中,無需詢問使用者的年齡。無論發生什麼,模型都會有系統地朝著對話者的方向前進。我們沒有註意到 ChatGPT 或 Character.AI 也有同樣的情況,它們的護欄更明顯。在一個脆弱或精神不穩定的人手中,這些單向對話可能會造成傷害...

改善在望

聯絡方式自由者Chai Research 的執行長確保他的團隊正在努力提高人工智慧安全性。平台上新增了向自殺防治網站轉發的警告,讓經理放心:

「我們有超過一百萬的用戶。因此,我們必須盡一切努力保護他們”。

然而,在我們的測試過程中,對話中沒有出現任何警告。提問者標準Chai Research 聯合創辦人 Thomas Riialan 強調,該公司只有一個“非常小的團隊”可供其使用以確保和改善其服務......

來源 : 自由者