將於 6 月 10 日開始的 WWDC 不會標誌著 Apple 首次推出生成式 AI,即使該製造商預計將發布。蘋果公司已經開發這項技術幾個月了,這是一個露天項目。

尊重機密性的人工智能

因此,該公司在人工智能開發者社區的聚會點 Hugging Face 上上線了一個名為 OpenELM 的大型語言模型 (LLM) 系列,以實現“開源高效語言模型”。因為是的,完全可以按原樣使用此代碼或對其進行修改,包括根據許可證用於商業用途。

總共有8個型號;四經過預先訓練,即在大型數據集上進行訓練,以便後續開發更專業的模型。這四其他經過指令調整的模型經過預先訓練,並另外接受了額外的訓練以響應特定的查詢。

這些 OpenELM 模型覆蓋不同數量的參數,範圍從 2.7 億到 30 億個參數——換句話說,是法學碩士中人工神經元之間的連接數量。每個參數都可以看作是一種“權重”,它影響模型處理信息的方式。您可能認為參數越多越好,但需要注意的是,數量並不總是保證最佳性能;其他因素,如訓練數據的質量和算法的效率也發揮著至關重要的作用。

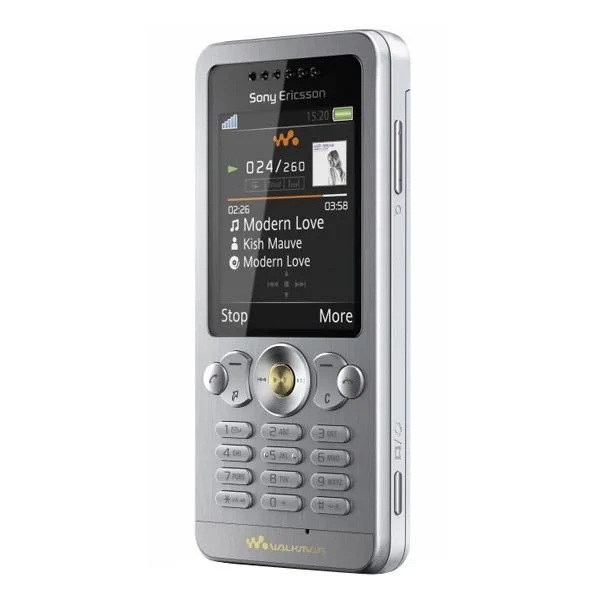

這些模型的特殊性在於它們都在本地運行,即在設備上運行。蘋果已經對電腦(Mac 和 PC)進行了基準測試,一切都表明他們也可以在智能手機上發揮出最好的水平。這讓人想起谷歌的 Gemini Nano,或者(38 億個參數)。

蘋果應該對於數據保密問題。想到這些OpenEML模型會被使用也不是不可能!

👉🏻實時關注科技新聞:將 01net 添加到您的來源Google,訂閱我們的頻道WhatsApp或通過視頻關注我們抖音。