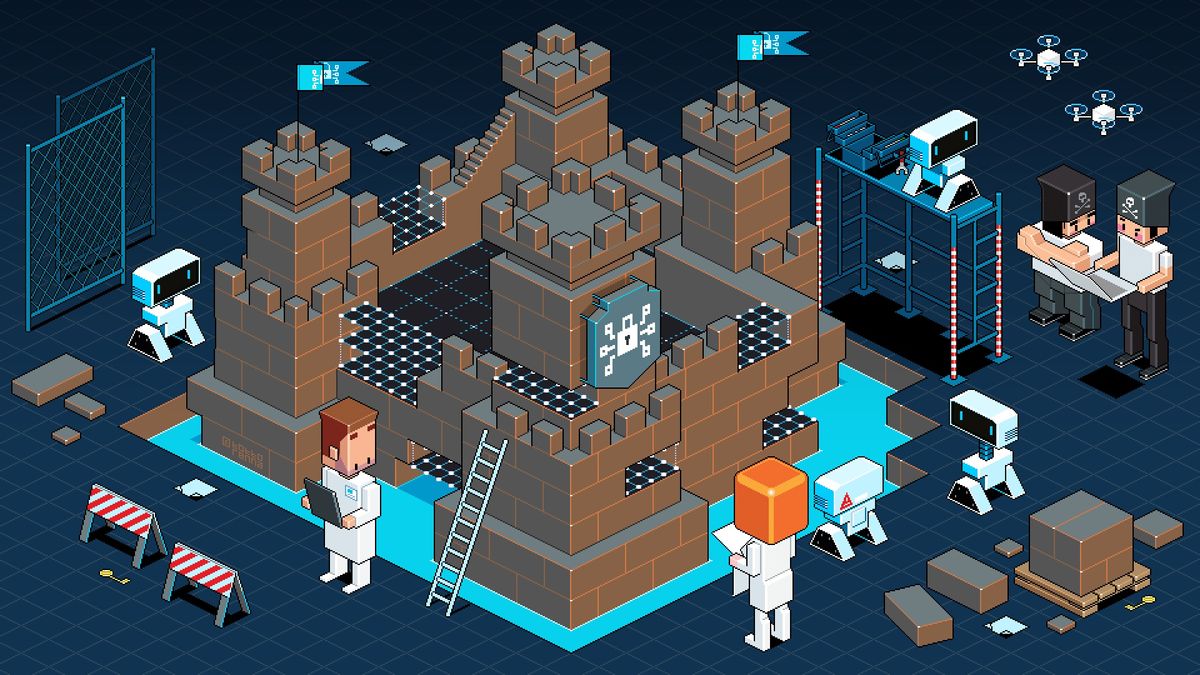

คอมพิวเตอร์หรือหุ่นยนต์ที่ฉลาดหลักแหลมได้คุกคามการดำรงอยู่ของมนุษยชาติมากกว่าหนึ่งครั้งในนิยายวิทยาศาสตร์ สถานการณ์วันโลกาวินาศดังกล่าวสามารถป้องกันได้หากมนุษย์สามารถสร้างเรือนจำเสมือนจริงเพื่อมีปัญญาประดิษฐ์ก่อนที่มันจะเติบโตขึ้นอย่างเป็นอันตราย

รักษาปัญญาประดิษฐ์(AI) Genie ติดอยู่ในขวดสุภาษิตอาจเปลี่ยนการคุกคามสันทรายให้กลายเป็นคำพยากรณ์ที่ทรงพลังซึ่งแก้ปัญหาของมนุษยชาติ Roman Yampolskiy นักวิทยาศาสตร์คอมพิวเตอร์ของมหาวิทยาลัยหลุยส์วิลล์ในรัฐเคนตักกี้กล่าว แต่การกักกันที่ประสบความสำเร็จนั้นต้องใช้การวางแผนอย่างรอบคอบเพื่อให้ AI ที่ฉลาดไม่สามารถคุกคามติดสินบนล่อลวงหรือแฮ็ควิธีการเป็นอิสระ

“ มันสามารถค้นพบเส้นทางการโจมตีใหม่เปิดตัวการโจมตีทางวิศวกรรมสังคมที่ซับซ้อนและใช้ส่วนประกอบฮาร์ดแวร์ที่มีอยู่ในรูปแบบที่ไม่คาดฝัน” Yampolskiy กล่าว "ซอฟต์แวร์ดังกล่าวไม่ได้ จำกัด อยู่ที่การติดเชื้อคอมพิวเตอร์และเครือข่าย- นอกจากนี้ยังสามารถโจมตีโรคจิตมนุษย์สินบนแบล็กเมล์และล้างสมองผู้ที่ติดต่อกับมัน "

สาขาการวิจัยใหม่ที่มีวัตถุประสงค์เพื่อแก้ปัญหาคุก AI อาจมีประโยชน์ด้านข้างสำหรับการปรับปรุงความปลอดภัยทางไซเบอร์และการเข้ารหัส Yampolskiy แนะนำ ข้อเสนอของเขามีรายละเอียดในฉบับเดือนมีนาคมของวารสารการศึกษาจิตสำนึก

วิธีดัก Skynet

โซลูชันเริ่มต้นหนึ่งอาจดักจับ AI ภายใน "เครื่องเสมือน" ที่ทำงานอยู่ภายในระบบปฏิบัติการทั่วไปของคอมพิวเตอร์ - กระบวนการที่มีอยู่ซึ่งเพิ่มความปลอดภัยโดย จำกัด การเข้าถึง AI ของโฮสต์ซอฟต์แวร์ของคอมพิวเตอร์และฮาร์ดแวร์ นั่นหยุด AI ที่ชาญฉลาดจากการทำสิ่งต่าง ๆ เช่นการส่งข้อความรหัสมอร์สที่ซ่อนอยู่ไปยังผู้เห็นอกเห็นใจของมนุษย์โดยจัดการกับพัดลมระบายความร้อนของคอมพิวเตอร์

การวาง AI ลงบนคอมพิวเตอร์ที่ไม่มีการเข้าถึงอินเทอร์เน็ตจะป้องกันไม่ให้โปรแกรม "Skynet" เข้ายึดกริดป้องกันของโลกในรูปแบบของภาพยนตร์ "Terminator"- หากทุกอย่างล้มเหลวนักวิจัยสามารถชะลอ "การคิด" ของ AI ได้โดยการควบคุมความเร็วของคอมพิวเตอร์กลับมาอย่างรวดเร็วกดปุ่ม "รีเซ็ต" เป็นประจำหรือปิดแหล่งจ่ายไฟของคอมพิวเตอร์เพื่อตรวจสอบ AI

มาตรการความปลอดภัยดังกล่าวถือว่า AI เป็นโปรแกรมไวรัสคอมพิวเตอร์หรือมัลแวร์ที่ฉลาดและเป็นอันตรายโดยเฉพาะ แต่ไม่มีความรู้ที่แน่นอนว่าขั้นตอนใด ๆ จะใช้งานได้จริง

“ Catch-22 คือจนกว่าเราจะได้พัฒนา Superinteligent AI อย่างเต็มที่เราไม่สามารถทดสอบความคิดของเราได้อย่างเต็มที่ แต่เพื่อพัฒนา AI อย่างปลอดภัยเราจำเป็นต้องมีมาตรการรักษาความปลอดภัยในการทำงาน” Yampolskiy กล่าวกับ InnovationNewsDaily "ทางออกที่ดีที่สุดของเราคือการใช้มาตรการคุมขังกับระบบ Subhuman AI และเพื่ออัปเดตตามความจำเป็นด้วยการเพิ่มความสามารถของ AI"

อย่าส่งมนุษย์ไปป้องกันเครื่องจักร

แม้แต่การสนทนาอย่างไม่เป็นทางการกับผู้พิทักษ์มนุษย์ก็สามารถอนุญาตให้ AI ใช้เทคนิคทางจิตวิทยาเช่นการตีสนิทหรือแบล็กเมล์ AI อาจเสนอให้รางวัลแก่มนุษย์ที่มีสุขภาพที่สมบูรณ์แบบอมตะหรืออาจนำครอบครัวและเพื่อนที่ตายแล้วกลับมา อีกวิธีหนึ่งมันอาจขู่ว่าจะทำสิ่งที่น่ากลัวให้กับมนุษย์เมื่อมัน "หลีกเลี่ยงไม่ได้" หลบหนี

วิธีการที่ปลอดภัยที่สุดสำหรับการสื่อสารอาจอนุญาตให้ AI ตอบสนองในแบบเลือกตอบกลับเพื่อช่วยแก้ปัญหาวิทยาศาสตร์หรือเทคโนโลยีที่เฉพาะเจาะจง Yampolskiy อธิบาย นั่นจะควบคุมพลังของ AI ในฐานะนักทำนายที่ฉลาดหลักแหลม

แม้จะมีการป้องกันทั้งหมดนักวิจัยหลายคนคิดว่ามันเป็นไปไม่ได้ที่จะทำให้ AI ที่ฉลาดล็อคตลอดไป การทดลองที่ผ่านมาโดย Eliezer Yudkowsky นักวิจัยที่สถาบันปัญญาประดิษฐ์เอกพจน์ชี้ให้เห็นว่าเพียงความฉลาดระดับมนุษย์สามารถหลบหนีจากสถานการณ์ "AI Box"-แม้ว่า Yampolskiy ชี้ให้เห็นว่าการทดสอบไม่ได้ทำการทดสอบทางวิทยาศาสตร์มากที่สุด

ถึงกระนั้น Yampolskiy ก็แย้งอย่างยิ่งสำหรับการเก็บขวด AI ไว้มากกว่าที่จะรีบวิ่งไปที่หัวเพื่อปลดปล่อยเครื่องใหม่ของเครื่องใหม่ของเรา แต่ถ้า AI มาถึงจุดที่มันเพิ่มขึ้นเกินกว่าความเข้าใจทางวิทยาศาสตร์ของมนุษย์ในการปรับใช้พลังเช่น precognition (ความรู้เกี่ยวกับอนาคต), กระแสจิตหรือ psychokinesis การเดิมพันทั้งหมดจะปิด

"หากซอฟต์แวร์ดังกล่าวสามารถปรับปรุงตนเองให้อยู่ในระดับได้อย่างมีนัยสำคัญสติปัญญาระดับมนุษย์ประเภทของความเสียหายที่สามารถทำได้คือเกินความสามารถของเราในการทำนายหรือเข้าใจอย่างเต็มที่ "Yampolskiy กล่าว

เรื่องนี้จัดทำโดย InnovationNewsDaily เว็บไซต์น้องสาวของวิทยาศาสตร์การใช้ชีวิต คุณสามารถติดตามนวัตกรรมใหม่นักเขียนอาวุโส Jeremy Hsu บน Twitter @วิทยาศาสตร์- ติดตาม InnovationNewsDaily บน Twitter @news_innovationหรือบนFacebook-