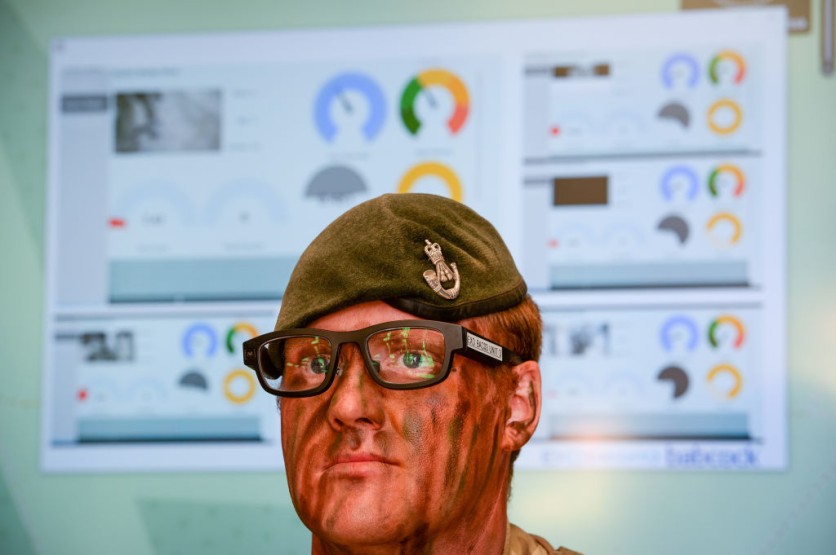

康奈尔大学的未来互动智能计算机界面(SCIFI)实验室已经开发了一个人工智能- 能够阅读穿着者无声演讲的眼镜界面。

称为Echopseech,眼镜基于唇部和嘴巴的动作最多识别31个未经代码的命令,并且它使用声学传感和人工智能来做到这一点。

AI读取无声声音命令

可穿戴界面仅需要几分钟的用户培训数据才能检测并激活智能手机上的命令。对于那些无法发声声音,使他们能够使用无声语音技术作为语音合成器的绝佳输入的人来说,这是理想的选择。

使用诸如CAD之类的设计工具,静音语音接口也可以与手写笔一起使用,几乎消除了对键盘和鼠标的需求。

使用Echopeech之类的技术可以在嘈杂的设置中通过智能手机与他人进行交流。

可穿戴的技术具有扬声器和一对麦克风,不超过铅笔橡皮。

眼镜识别口腔动作,在整个脸上传递和接收声波,并使用A实时分析它们深度学习算法。

音频数据可以实时通过蓝牙传达给智能手机,并且比图像或视频数据使用的带宽较小,因为它较小。

此外,数据是在智能手机上本地处理的,而不是发送到云中的,从而确保对隐私敏感的信息永远不会离开用户的手。

下一步:商业化

该团队试图通过IGNITE:Cornell Research Lab到Market的GAP资金进行差距资金来商业化的技术。

Scifi Lab创建了几个可穿戴的小工具使用微小的摄像机和机器学习来跟踪身体,手和面部运动。

为了跟踪面部和身体运动,该实验室最近从相机转向声学检测,以更高的电池寿命,更大的安全性和隐私以及较小的装备为由。

Echospeech基于实验室的可穿戴耳塞,该耳塞记录了称为Eario的面部运动,该耳朵类似地使用声学感应。在即将进行的研究中,Scifi Lab的研究人员正在研究智能玻璃应用,以监视面部,眼睛和上身运动。

该实验室认为,玻璃将是理解自然环境中人类行为的关键个人计算机平台。因此,回声的出现。