Deepfakes 正在互联网上泛滥。借助人工智能生成的这些内容,网络犯罪分子可以通过操纵目标来策划可怕的攻击。有一些发现陷阱的技巧,但最复杂的进攻已经变得近乎完美......

我们越来越多地听到深度伪造。这些由算法生成的内容成为头条新闻,并经常成为媒体的头条新闻。近日,我们了解到一家香港公司Deepfake技术损失了数百万美元。

但是,尽管如此,你仍然不太了解什么是 Deepfakes?您来对地方了,可以了解更多信息并了解有关软件创建的内容的所有内容。为了评估这个主题,我们收集了专家的意见:Eny Sauvêtre,BRAIN Cybersecurity Awareness 的联合创始人,这是一家专门从事网络安全意识的法国公司。

什么是深度造假?

具体来说,深度伪造是由人工智能生成的视频、照片或音频内容模仿真人。这个名字结合了人工智能的一个关键分支“深度学习”和“假”。深度学习允许人工智能系统在没有程序员帮助的情况下,通过利用海量数据来模仿复杂的人类行为,例如语音或面部表情。我们在语言模型的核心发现了类似的操作,例如 OpenAI 的 GPT。

随着生成式人工智能的兴起,任何互联网用户都可以越来越容易地生成个性、亲人或陌生人的人工图像。网络上有大量易于使用的工具,可让您克隆某人的声音、模仿某人的脸部或修改图像。

深度造假的危险

有了深度造假,网络犯罪分子的武器库中又多了一种武器。在基于基础的操作环境中,它是一个强大的工具社会工程。这种类型的攻击利用的是人类的弱点,而不是计算机系统的缺陷。在这种情况下,深度造假使得利用人类情感(例如好奇心、恐惧、信任或帮助他人的愿望)来窃取数据或赚钱成为可能。

“Deepfake 是网络攻击的一部分,目前被黑客、攻击链中的网络犯罪分子所使用””,Eny Sauvêtre 解释道,并保证攻击目前正在进行中。

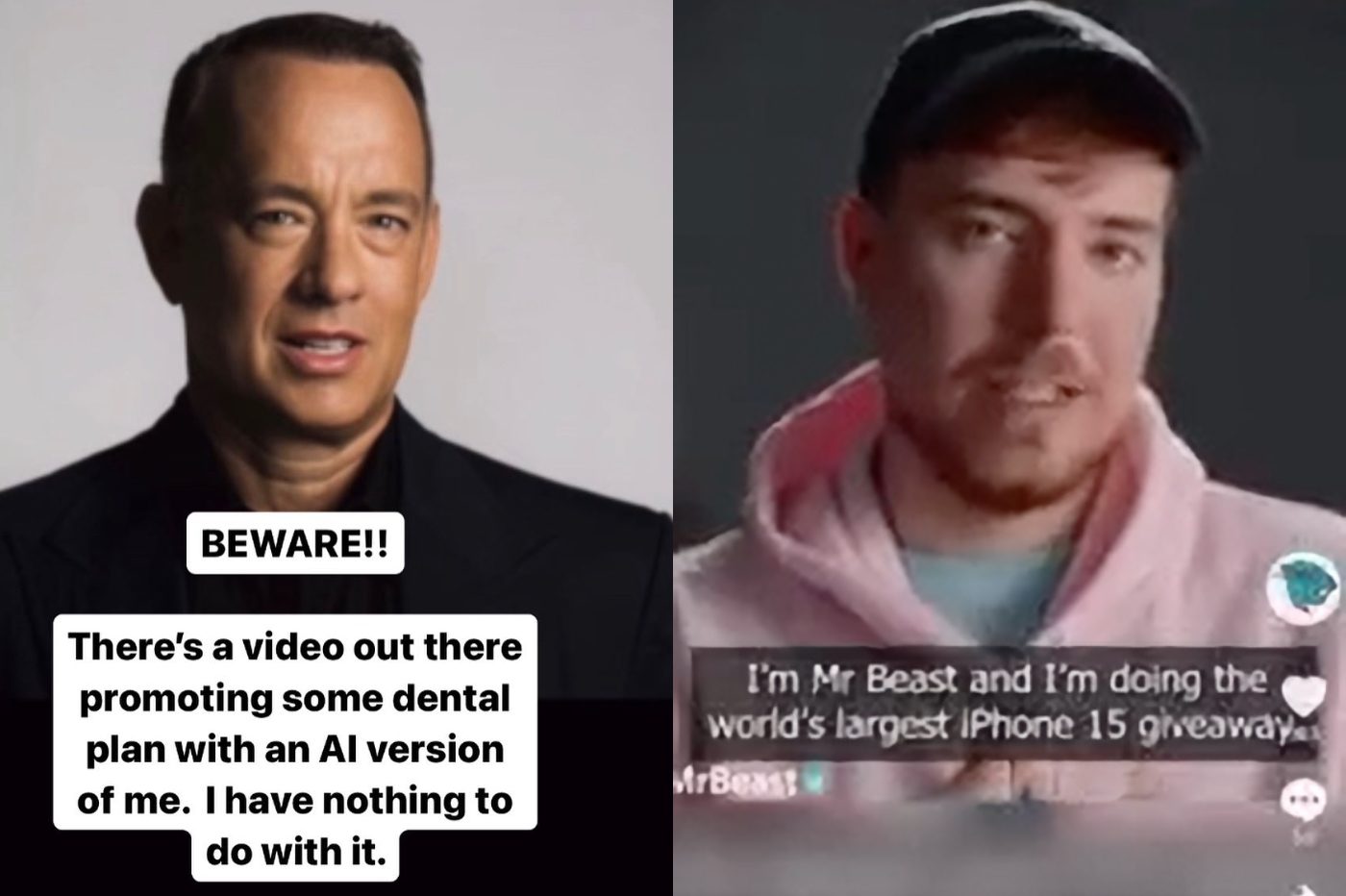

L'expert 与众不同Deepfake 的两个用例出于恶意目的。首先,存在大量深度造假。这是冒充公众人物的“深度造假信息”。攻击者将“让某人说出一些他们没有说过的话,通常是有权力的人”。

我们还发现深度伪造用于所谓的“鱼叉式网络钓鱼”攻击,即使用精确信息专门针对个人或组织的网络钓鱼操作。作为这些复杂攻击的一部分,深度伪造是“专门用于具有目标个人信息的目标”。

显然,黑客会创建冒充亲人或同事的内容。例如,网络犯罪分子可以克隆亲人的声音。软件只需要几分钟就可以复制一个人的声音并用它来让他们说出任何话。

识别它们有哪些技巧?

大多数深度赝品可以通过查看某些特征来检测。我们的对话者引用了诸如嘴唇。一些人工智能生成的视频无法与主角的话语正确地对口型。嘴唇运动和声音之间可能会有轻微的延迟。

还需要重点关注面部表情。如果你的对话者的脸显得有点僵硬和静止,那么你可能正在面对一个深度假货。同样,一些人工智能生成的内容也忽略了眨眼。在一些假视频中,主角从不眨眼。

“作为一个人,我们知道如何检测我们面前的人是否真实”Brain 的联合创始人宣称。

我们也来引用一下肤色。通常,深度假货很难复制人类皮肤反射光的方式。最后,图像颗粒也会暴露人工智能生成内容的存在。面部与视频其余部分之间的质量或分辨率差异可能会提醒您。

至于音频深度伪造,我们建议您向对话者询问一个私人问题。如果他无法回应你,你可能正在用人工智能克隆的声音说话。同样,关注要求你做某事的人选择的词汇。如果所用的词语不符合他的习惯,就要小心了。

一项快速发展的技术

不幸的是,技术发展得太快,识别假图像的线索往往会消失。据他介绍,“今天,我们可以就深度造假提供建议,但按照事情的发展速度,几个月后这些建议将不再具有任何价值”。此外,网络犯罪分子故意在网络上散布劣质的深度伪造品来愚弄互联网用户:

“事实上,这是一种黑客技术,会留下大量质量非常差的深度赝品。这样,人们就会习惯说“好吧,这个,我知道如何识别它,这个,我知道它可能是什么”。事实上,他们在网络钓鱼方面也做了同样的事情。他们抛出了很多可以识别的网络钓鱼,但实际上在这些网络钓鱼中,有一些实际上是无法识别的网络钓鱼”。

一旦人类习惯了某些反复出现的特征,“他们实际上使用了最好的软件、最好的算法,因此无法识别它”。因此,潜在的受害者更有可能落入陷阱。

检测深度伪造的工具

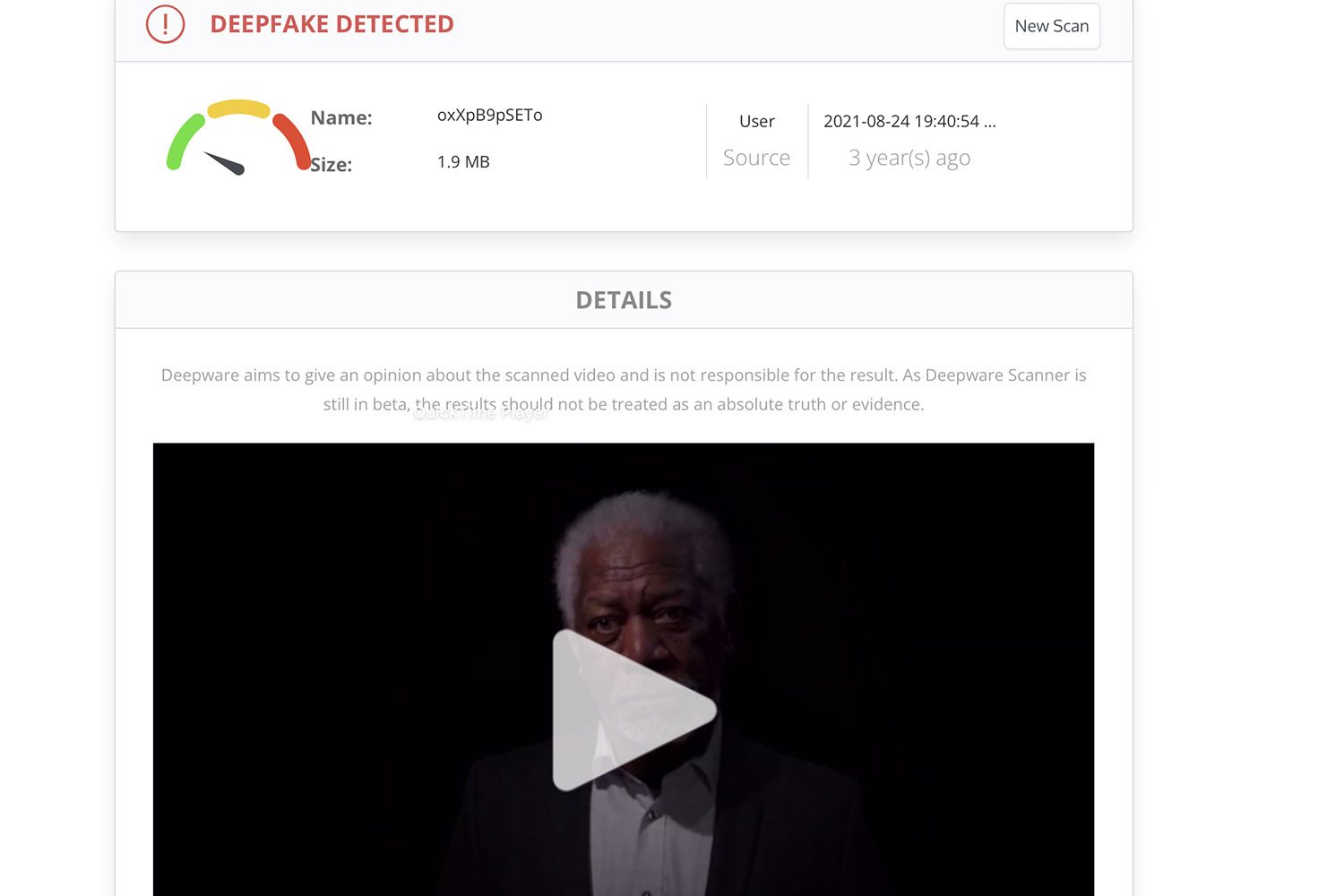

在网络上,有大量工具有望帮助您识别深度伪造内容。我们使用虚拟图像测试了多个软件程序,结果相当复杂。我们特别举一下

其网络界面非常易于使用。该平台专门检测虚假视频。要扫描序列,只需将 URL 拖到站点上即可。我们测试的大多数 YouTube 视频都能被人工智能正确解读。

正如我们所指出的,这些工具远非万无一失。这些软件可以镜像工具来检测文本是由 ChatGPT 还是其他聊天机器人编写的,但可能会出错。例如,他们可以确定深度伪造不是虚假内容,而是真实图像。

同样,某些工具有时会怀疑真实图像的真实性。平台的情况是这样的照度。我们在网站上发布了几张 100% 真实的照片,在某些情况下,Illuminarty 认为人工智能可能参与其中。例如,该网站认为人工智能生成我们肖像的可能性超过 40%。另一方面,马克龙的深度造假只获得了 37% 的分数。因此,我们远不能依靠它来保护自己的在线安全。

另请注意,大多数最强大的探测器并不容易被公众使用。有些还需要安装在配备强大显卡的PC上才能实现良好的检测。尖端工具(例如来自英特尔或微软的工具)尚未在网络上供所有互联网用户使用。

是否有可能揭开所有深度伪造品的面纱?

随着人工智能的兴起,不再可能通过关注其缺陷来识别所有深度赝品。正如我们采访的专家所解释的那样,人工智能的爆炸式增长伴随着深度造假精度的加速提升。

大量的深度赝品通常仍然可以通过少量观察来识别。对于作为目标攻击的一部分利用的产品来说,这种情况越来越少。由拥有大量财力的攻击者制作的高质量深度伪造品已经不可能被检测到。将此内容用作鱼叉式网络钓鱼攻击的一部分,“我们无法辨别它是真的还是假的”。

“在 Deepfake 中不起作用的所有内容,我们识别 Deepfake 的所有要素 [...] 有些人工智能经过训练,并成功地在这些点上重现了超现实主义 »,详细介绍了 Brain 的联合创始人,确保复杂的攻击,“真的很难发现”。

为了保护自己,专家建议互联网用户消息灵通关于人工智能和深度造假等新兴技术。据他介绍,“防止 Deepfake 的最终技术是意识到,只是对主题感兴趣并了解到底发生了什么,也就是说,要了解制造 Deepfake 是一种网络攻击,而网络攻击是由网络犯罪分子发起的,他们要么想要金钱,要么想要权力”。

保护自己的良好做法

为了避免陷入旨在传播虚假信息的大规模深度造假的陷阱,没有数千种解决方案:您只需返回内容来源。一旦互联网用户仅依赖信誉良好且公认的来源,深度造假内容将不再能够欺骗他们。

专家还建议您致电“常识”。在您听到埃隆·马斯克或汤姆·汉克斯向您提供免费加密货币的视频之前,请退后一步。请毫不犹豫地在谷歌上进行一些搜索,看看视频传达的信息是否已在其他网站上使用。如果没有,您可能会开始怀疑您所看到或听到的内容。

为了避免陷入有针对性的攻击陷阱,您应该关注对话者提出的请求。有必要“分析所请求的操作”,专家评判。如果“这个人正在紧急询问我一些我不应该做的事情,或者要求我绕过程序或类似的事情”,这是红色警报。