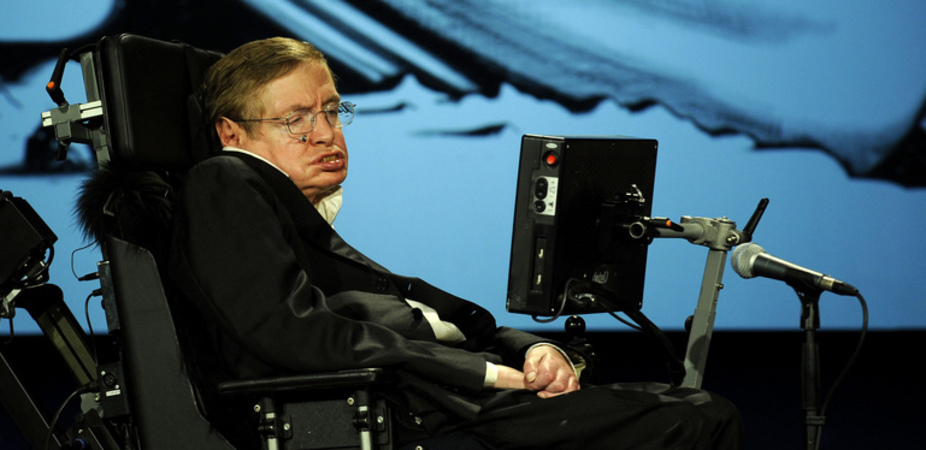

斯蒂芬·霍金(Stephen Hawking)可能以他在黑洞和引力奇異上的工作而聞名,但世界著名的物理學家也以他對可能破壞人類文明的事物的直言不諱而聞名。

鷹患有運動神經元疾病類似於肌萎縮性的側面硬化症或ALS,這使他癱瘓了,沒有語音合成器就無法說話。但這並沒有阻止劍橋大學的教授對包括我們自己在內的人類面臨的廣泛危險進行宣告。

霍金說的一些事情可能會帶來人類文明的滅亡。 [世界末日?世界末日的恐懼這是給出的

人工智慧

霍金是一小部分但不斷增長的科學家的一部分,他們表達了對“強”人工智能的擔憂(AI) - 可能等於或超過人類的智力。

Hawking在2014年12月對英國廣播公司(BBC)表示:“完整人工智能的發展可能會闡明人類的終結。

霍金的警告呼應了億萬富翁企業家的警告埃隆·馬斯克(Elon Musk),首席執行官SpaceX特斯拉汽車(Tesla Motors)稱為AI人類的“最大的存在威脅。

科學家:“由於人工智能的潛力巨大,重要的是研究如何在避免潛在陷阱的同時獲得益處。”在信中寫1月11日,該組織由Life Institute的Future Of Life Institute在線發布,該研究所的志願組織旨在減輕對人類的存在威脅。

但是許多人工智能研究人員說,人類遠遠無法發展強大的人工智能。

Google DeepMind的人工智能研究員Demis Hassabis在本週的新聞發布會上對記者說:“我們距離我們需要擔心的任何技術都有數十年的距離。”不過,“現在開始對話是一件好事,”他補充說。

人類侵略

如果我們的機器不殺死我們,我們可能會自殺。霍金現在相信人類的侵略可能破壞文明。

該物理學家正在為倫敦科學博物館參觀Adaeze Uyanwah。當Uyanwah問:“您最想改變什麼人類的缺點?”霍金回答:

“我最想糾正的人類失敗是侵略性。在穴居人時代,它可能具有生存優勢,以獲取更多的食物,領土或伴侶,但現在有可能摧毀我們所有人,”獨立報告。

例如,霍金補充說,一場重大的核戰爭可能會終結文明,並可能消滅人類。當被問及他最想放大的人類品質時,霍金選擇了同理心,因為“它使我們以一個和平,充滿愛心的狀態將我們聚在一起。”

霍金認為,空間探索對於確保人類生存至關重要。 “我相信人類的長期未來必須是空間,它代表了我們未來生存的重要人壽保險,因為它可以通過殖民其他行星來防止人類消失,”劍橋新聞報告。

外星人的生活

但是霍金甚至在最近的這些警告之前就發出了不祥的警告。早在2010年,霍金說,如果存在聰明的外星人生活,可能不是那麼友好朝向人類。

霍金說:“如果外星人拜訪我們,我認為結果將會像克里斯托弗·哥倫布(Christopher Columbus)第一次降落在美國時,這對美洲原住民來說並不是很好。”報導了時代,英國的報紙。

霍金說,先進的外星文明可能會成為游牧民族,希望征服和殖民他們可以觸及的任何行星。 “如果是這樣,對於他們來說,利用每個新星球來建造更多的太空飛船,以便他們繼續前進是有意義的。誰知道限制是什麼?”

從邪惡的AI的威脅到先進的外星人到敵對的人類,霍金的人類看法看起來非常嚴峻。

關注Tanya Lewis上嘰嘰喳喳。跟著我們@livescience,,,,Facebook和Google+。原始文章現場科學。