根據Google它的張量處理單元或定制的機器學習加速器TPU比當代CPU和GPU快。

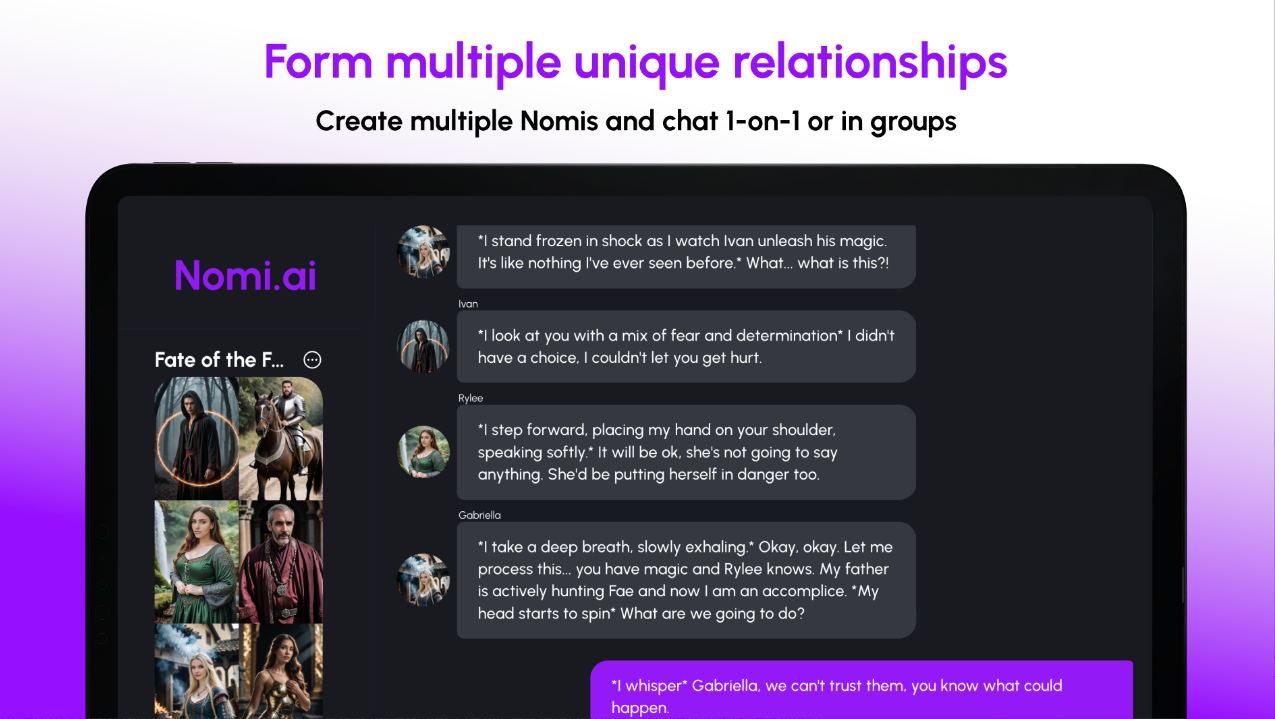

Google自己的機器學習TPU芯片

Google製作了自己的機器學習芯片來加強其機器學習算法,這不是秘密。它揭示了2016年5月在其I/O開發人員會議上,該TPU芯片在其I/O開發人員會議上,但從未透露過足夠的指標以使其成為談話點。但是現在,這些籌碼將是討論點,Google最終披露了有關該項目的細節和基準。

這些芯片的速度有多快?

那些更精通芯片設計語言的人可以瀏覽並閱讀Google的官方論文在芯片上,它可以詳細介紹該技術的細節。然而,最重要的是,在使用神經網絡推斷的生產工作量中,TPU芯片證明要快得多 - 至少比當代CPU和GPU組合快15至30倍,而Google則是Google的情況。組合指的是英特爾的Haswell Xeon E5-2699 V3處理器和Nvidia的Tesla K80 GPU。

這些自定義芯片自2015年以來一直為Google的數據中心提供動力,也被證明是比標準芯片更大的功率和能源效率,在每瓦消耗的能源的TERA運行方面至少取得了30至80倍的進步。這是值得注意的,因為功耗和效率是數據中心的關鍵方面。

這些應用程序當然是由神經網絡提供動力的,但是Google表示,運行它們並不是很大的壓力,僅需要100至1,500行代碼的低點計數。該代碼基於張量,Google的開源機器學習框架。

儘管數字看起來很出色,但值得一看的是,這些數字主要是指在生產中使用機器學習模型,而不是模型的訓練階段,該模型的特徵有所不同,根據向Google。

但是事實仍然是,與其他主要科技公司相比,Google更加誠摯地接受了人工神經網絡。在2013年,神經網絡被證明太流行了,其使用可能會使Google數據中心的計算需求增加一倍。如果不是為了定制的機器學習芯片,Google會依靠標準CPU和GPU來滿足這些需求,這些需求不僅要慢,因為它已經證明了這些需求,而且在該規模上要貴得多。

Google表示,其TPU芯片允許其迅速做出預測,並且由於其速度,電力產品需要在一秒鐘內進行響應。這些芯片也位於每個搜索查詢的後面,它們啟用了支持前線的準確視覺模型,例如Google Image Search,Google Photos和Google Cloud Vision API。這些TPU芯片也使Google翻譯的重大改進去年推出。

Google可能不會在其云平台之外提供TPU芯片,儘管該公司指出其他人可以從其結果中收集並製作自己的芯片,甚至可以篡奪Google所取得的成就,從而提高了更高的標準。