บทความเบื้องหลังนี้จัดทำขึ้นเพื่อ Livescience โดยร่วมมือกับมูลนิธิวิทยาศาสตร์แห่งชาติ

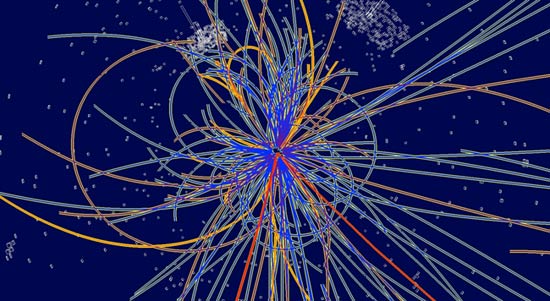

นักฟิสิกส์ของมหาวิทยาลัยเนแบรสกา-ลินคอล์น Ken Bloom และ Aaron Dominguez ได้ร่วมมือกับ David Swanson นักวิทยาศาสตร์คอมพิวเตอร์เพื่อสร้างศูนย์คอมพิวเตอร์เพื่อประโยชน์ของนักวิทยาศาสตร์ที่มหาวิทยาลัยและทั่วประเทศ เป้าหมายของศูนย์คือการจัดการข้อมูลน้ำท่วมที่จะหลั่งไหลจากตัวเร่งอนุภาครุ่นต่อไปของโลกHadron Collider ขนาดใหญ่(LHC) วงแหวนใต้ดิน 27 กิโลเมตรรอบ ๆ ตั้งอยู่ที่ศูนย์วิจัยนิวเคลียร์แห่งยุโรป (CERN) ในเจนีวาประเทศสวิตเซอร์แลนด์เริ่มต้นในกลางปี 2551 เครื่องตรวจจับที่ประจำอยู่รอบ ๆ วงแหวน LHC จะผลิตข้อมูลกิกะไบต์ 15 ล้านล้านกิกะไบต์ทุกปีข้อมูลที่จะทำไร่ออกไปยังศูนย์คอมพิวเตอร์ทั่วโลก ศูนย์เนบราสก้าจะอนุญาตให้นักฟิสิกส์จากมหาวิทยาลัยหลายแห่งวิเคราะห์ข้อมูลจากMuon Solenoid ขนาดกะทัดรัดการทดลอง-เครื่องตรวจจับมากกว่า 12,000 ตันที่จะบันทึกแทร็กที่สร้างขึ้นโดยอนุภาคหลายร้อยตัวที่เกิดขึ้นจากการชนกันในแต่ละตัวเร่งความเร็ว-ในขณะเดียวกันก็ให้พลังการคำนวณสำหรับนักวิจัยในสาขาวิทยาศาสตร์อื่น ๆ เช่นซม.เริ่มมองหาศูนย์คอมพิวเตอร์เพื่อโฮสต์ข้อมูลอาจารย์ Bloom และ Dominguez พิจารณาว่าโครงการดังกล่าวจะเหมาะกับมหาวิทยาลัยเนแบรสกาหรือไม่ “ หลังจากพูดคุยกับ David Swanson ผู้กำกับสิ่งอำนวยความสะดวกในการวิจัยของเราเราตระหนักว่านี่เป็นโครงการที่เหมาะสำหรับเราที่จะร่วมมือกัน” Bloom กล่าว ในรูปแบบการคำนวณ LHC ข้อมูลจากการทดลองจะไหลผ่านระดับ Tier 0 Center ที่ CERN นำข้อมูลโดยตรงจากการทดลองเก็บสำเนาและส่งไปยังไซต์ระดับ 1 CMS มีเจ็ดไซต์ระดับ 1 ในเจ็ดประเทศและแต่ละไซต์พาร์ติชันส่วนหนึ่งของข้อมูลตามประเภทของอนุภาคที่ตรวจพบและส่งตัวอย่างย่อยเหล่านี้ออกไปยังไซต์ระดับ 2 ที่ไซต์ระดับ 2 นักวิจัยและนักเรียนในที่สุดก็ได้รับข้อมูล CMS มีไซต์ดังกล่าวสามสิบแห่งเจ็ดแห่งในสหรัฐอเมริกาและหนึ่งในนั้นอยู่ที่มหาวิทยาลัยเนบราสก้า นักฟิสิกส์จะใช้ข้อมูลที่เก็บไว้ในเว็บไซต์เหล่านี้เพื่อค้นหาอนุภาคที่ไม่เคยเห็นมาก่อนหรือมิติพิเศษของพื้นที่โดยการส่งโปรแกรมพิเศษเพื่อทำงานบนข้อมูล ด้วยสถาบันสี่สิบแห่งในสหรัฐอเมริกาที่เกี่ยวข้องกับการทำงานร่วมกันของ CMS ศูนย์ทั้งเจ็ดจะเห็นการจราจรมากมาย หนึ่งในความท้าทายของการสร้างไซต์ระดับ 2 คือการเตรียมการไหลของข้อมูลที่หนัก แล้วกลุ่มเนบราสก้าได้บรรลุอัตราการโอนที่เร็วที่สุดในเครือข่ายแห่งชาติที่เชื่อมต่อFermi National Accelerator Laboratoryเว็บไซต์ US Tier 1 พร้อมไซต์ US Tier 2 "เราเก่งในการย้ายข้อมูลจาก Fermilab ไปยังศูนย์ระดับ 2 ของเรา" บลูมกล่าวโดยไม่มีข้ออ้าง-พวกเขาประสบความสำเร็จในอัตราที่เร็วที่สุดสำหรับการเชื่อมต่อระดับ 1 ถึงระดับ 2 ระดับทั่วโลก "เราสามารถจัดการ terabyte ต่อชั่วโมงได้อย่างง่ายดายและ terabyte ในครึ่งชั่วโมงเป็นไปได้"

เนื่องจาก LHC จะผลิตข้อมูลได้มากเทราไบต์หรือกิกะไบต์ 1,000 กิกะไบต์เป็นหน่วยมาตรฐานของข้อมูลในหมู่นักวิทยาศาสตร์ที่เกี่ยวข้องกับการคำนวณ LHC นอกเหนือจากการสร้างการเชื่อมต่อเครือข่ายที่รวดเร็วฟ้าผ่าแล้ว Bloom และ Dominguez ยังสร้างศูนย์คอมพิวเตอร์ที่มีประโยชน์เกินกว่าการวิจัยฟิสิกส์ของอนุภาค จากข้อมูลของ Dominguez "มันเป็นความท้าทายในการสร้างสิ่งอำนวยความสะดวกที่สามารถแบ่งปันได้อย่างมีประสิทธิภาพกับชุมชนทั่วโลกและนักวิจัยท้องถิ่นเพื่อให้สิ่งที่ใหญ่กว่าดีขึ้นและมีประโยชน์มากขึ้นสำหรับการวิจัยในมหาวิทยาลัยโดยรวม" ด้วยเป้าหมายนี้ในใจพวกเขาจึงออกแบบระบบที่สามารถรองรับการคำนวณแบบขนาน โปรแกรมที่ดำเนินการคำนวณหลายอย่างพร้อมกันในโปรเซสเซอร์ที่แตกต่างกันและนำผลลัพธ์มารวมกันในตอนท้ายเป็นเครื่องมือที่ทรงพลังสำหรับนักเคมีและนักนาโนนักปราชญ์โดยเฉพาะ ในฐานะที่เป็นไซต์ CMS Tier 2 ที่ University of Nebraska เป็นส่วนหนึ่งของกริดวิทยาศาสตร์ US Open นักวิจัยจากหลายสาขาจะวิเคราะห์ข้อมูลโดยใช้พลังการคำนวณในช่วงเวลาที่นักวิจัย CMS ไม่ได้ทำให้เว็บไซต์ไม่ว่าง

- วิดีโอ: เทคโนโลยีป่า

- แม้จะมีข่าวลือโรงงาน Black Hole จะไม่ทำลายโลก

- การสร้างเครื่องเพื่อค้นหาความลับของจักรวาล

หมายเหตุบรรณาธิการ: งานวิจัยนี้ได้รับการสนับสนุนโดยมูลนิธิวิทยาศาสตร์แห่งชาติ (NSF) หน่วยงานรัฐบาลกลางถูกเรียกเก็บเงินจากการระดมทุนการวิจัยขั้นพื้นฐานและการศึกษาในทุกสาขาของวิทยาศาสตร์และวิศวกรรมดูเบื้องหลังการเก็บถาวร-

ข้อมูลเพิ่มเติมเกี่ยวกับคณิตศาสตร์ฟิสิกส์