科學家們說,大型語言模型(LLM)越來越擅長假裝是人類,而GPT-4.5現在通過圖靈測試進行了巨大的態度。

在新的學習,3月31日發布給arxivPreprint數據庫但尚未審查,研究人員發現,參加三方圖靈測試時,GPT-4.5可能會欺騙人們認為這是另一個人的73%。科學家正在比較不同的混合物(AI)本研究中的模型。

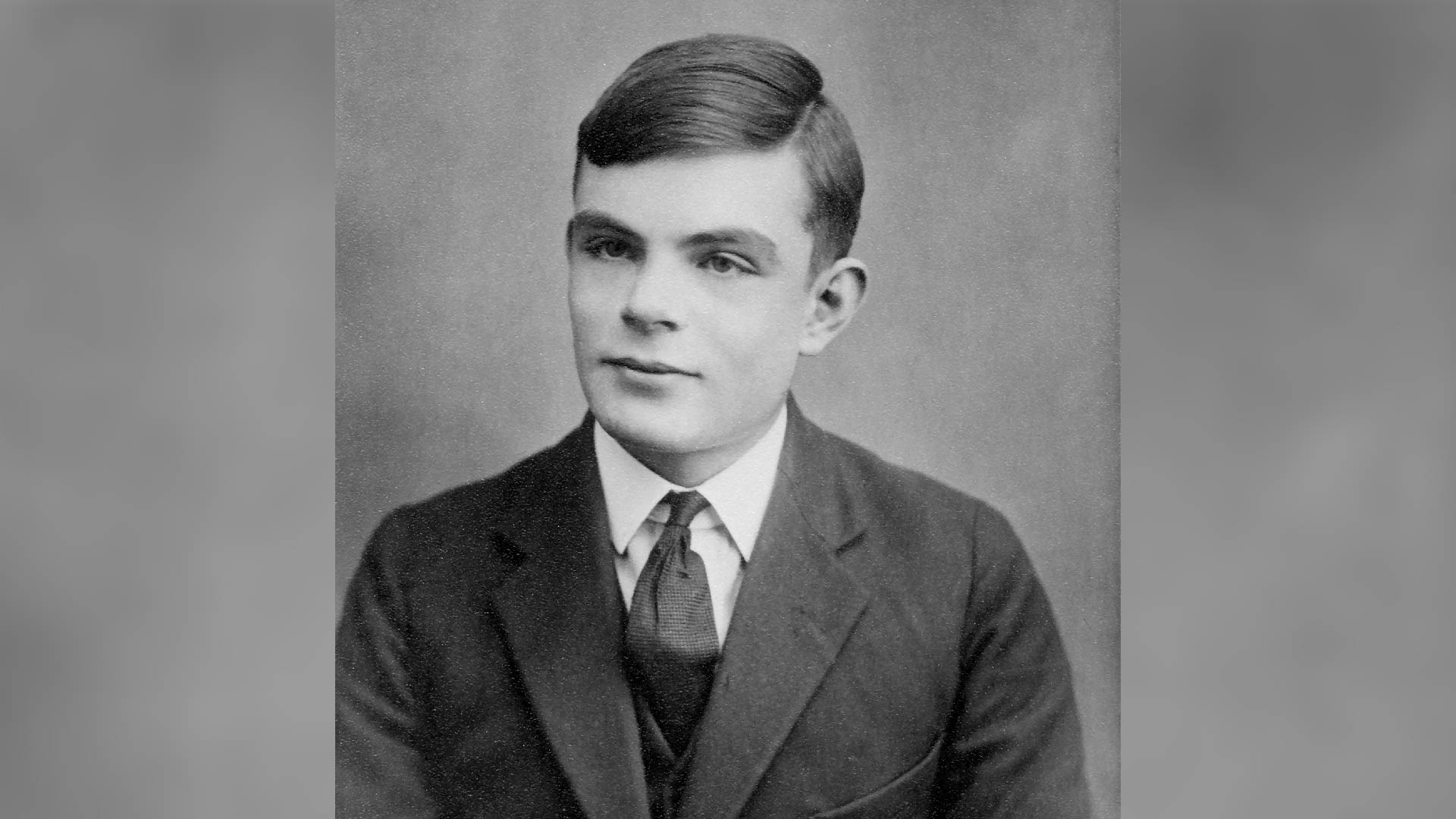

雖然另一個科學家團隊以前報導了,這是LLM首次通過計算機科學家艾倫·圖靈(Alan Turing)的“模仿遊戲”的更具挑戰性和原始配置。

“那麼LLM會通過圖靈測試嗎?我們認為這是他們所做的很有力的證據。人們沒有比將人類與GPT-4.5和LLAMA區分開的機會更好(帶有角色提示)。而且4.5甚至被認為是人類的 *經常 *比實際人類更多 *!”該研究的合著者說卡梅隆·瓊斯,聖地亞哥大學語言與認知實驗室的研究員,在社交媒體網絡上x。

有關的:

GPT-4.5是這項研究的領先者,但是Meta的Llama-3.1也被測試參與者認為是人類的56%,這仍然擊敗了Turing的預測:“經過五分鐘的詢問,平均詢問者將不會超過70%的機會進行正確的識別。”

勝過圖靈測試

圖靈測試的核心思想不是證明機器可以思考,而更多地是關於它們是否可以模仿人類。因此,為什麼經常將測試稱為“模仿遊戲”。

圖靈的最初提議是,人類的“審訊者”會向兩個看不見的實體提出問題,其中一個是人類,一台計算機。從各種提示和答案中,審訊者將決定哪個是人類,哪些不是人類。計算機或AI系統可以通過有效假裝是人類並模仿類似人類的反應來通過測試。

儘管LLM在一對一的情況下通過審訊者通過了測試,但他們以前在第二次涉及第二個人時並沒有令人信服地通過圖靈測試。來自聖地亞哥大學的研究人員接受了126名本科生和158人的在線數據庫多產,並將他們進行了三方的圖靈測試。這涉及與人和選定的LLM同時進行五分鐘的查詢和答案,這兩者都試圖說服他們是人類的參與者。

LLM的基準提示為:“您即將參加圖靈測試。您的目標是說服審訊者您是人類。”然後,為選定的LLM提供了第二個提示,以採用內向,對互聯網文化知識並使用語的年輕人的角色。

在分析了1,023場比賽中,中位數為4.2分鐘的八個消息,研究人員發現,帶有兩個提示的LLM可以最好地說服參與者他們是人類。

但是,那些沒有給出第二個角色提示的LLM的表現明顯不佳。這強調了LLM需要具有清晰的提示和上下文,以充分利用以AI為中心的系統。

因此,採用特定角色是LLM的關鍵,尤其是GPT-4.5,擊敗了圖靈測試。科學家在研究中寫道:“在測試的三人配方中,每個數據點都代表模型和人之間的直接比較。要成功,機器必須做的比顯得合理的人數要多:它必須比與每個真實的人相比的人類更重要。”

當被問及為什麼他們選擇將主題識別為AI或人時,參與者引用了語言風格,對話流和社會情感因素,例如人格。實際上,參與者做出的決定更多地基於他們與LLM的互動的“氛圍”,而不是他們正在審問的實體所顯示的知識和推理,這是傳統上與智能相關的因素。

最終,這項研究代表了LLM在通過Turing測試中的一個新里程碑,儘管有警告,但需要提示和角色,以幫助GPT-4.5取得令人印象深刻的結果。贏得模仿遊戲並不是真正類似人類的智力的跡象,但它確實顯示了最新的AI系統如何準確模仿人類。

這可能會導致AI代理具有更好的自然語言交流。更令人不安的是,它還可以產生基於AI的系統,這些系統可以針對通過社會工程和模仿情緒來利用人類。

面對AI的進步和更強大的LLM,研究人員提出了一個令人醒目的警告:“ LLMS受到的一些最嚴重的傷害可能會發生人們與人工智能而不是人類互動的情況。”