由人工智能(AI)和治療應用提供支持的聊天機器人正在改變心理健康服務行業很快。其中包括心理健康聊天機器人Earkick與戴著頭巾的熊貓具有五顏六色的界面。

下載後,心理健康聊天機器人會回應焦慮的談話,並以令人放心和富有同情心的評論(如治療師)打字。儘管採用了治療方法,但Earkick的聯合創始人Karin Andrea Stephan不喜歡將AI驅動服務標記為治療。

關於AI驅動的心理健康服務的辯論超出了Earkick的新穎性包括它們的有效性和安全性,PER AP新聞。隨著Z世代青少年和年輕成人心理健康的AI聊天機器人的增長,有關他們的治療與自助狀態的問題。

儘管它們的零星可用性以及試圖減少與常規治療相關的污名的嘗試,但其功效仍然存在爭議。食品藥品監督管理局很少診斷或治療醫療疾病,因此不監管心理健康聊天機器人。諸如Vaile Wright之類的心理學家和技術主管擔心這種監管差距,因為他們缺乏控制和證據。

對心理健康聊天機器人的需求不斷增加

一些健康老家認為,該應用程序的非醫療免責聲明可能不足以減輕心理健康專業人士短缺和冗長的治療等待時間。已建立的嚴重疾病和聊天機器人的緊急響應能力的置換使討論變得複雜。

圍繞有關AI Chatbot安全的這些辯論,斯坦福培訓的心理學家在2017年開發了Woebot,以提出替代基於語言模型的聊天機器人的替代方案。 Woebot通過有組織的腳本將心理健康治療的安全性和有效性優先考慮。

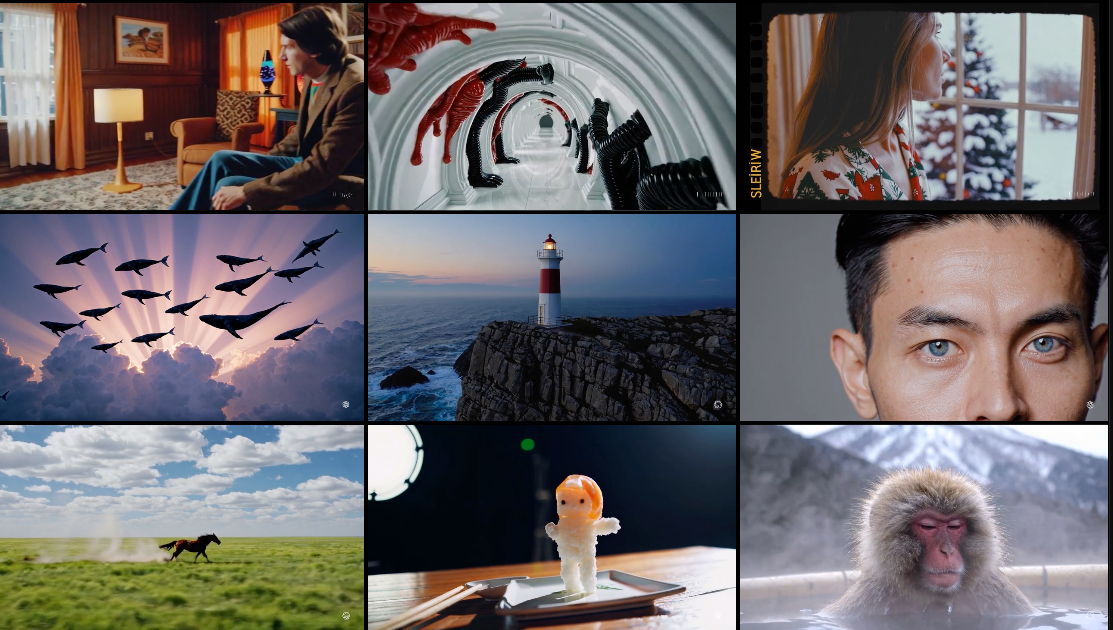

(照片:Olivier Douliery/AFP通過Getty Images)

在這張照片插圖中,在2020年4月30日在弗吉尼亞州阿靈頓的iPhone屏幕上看到了一個虛擬朋友。

根據監護人的說法,對國家衛生服務療法服務的需求不斷上升表明需要數字替代方案面對面治療。在2022 - 23年,有176萬人被轉診為心理健康治療,有122萬人開始親自治療。

更好的螺旋在治療方面解決了障礙,例如受限制的從業者可用性和無法接近的治療師。這些平台對敏感用戶數據的管理引起了人們的關注。由於隱私問題,英國監管機構正在監管此類申請。

去年,美國聯邦貿易委員會因欺騙客戶並向其他當事方披露敏感數據而被美國聯邦貿易委員會罰款780萬美元。隱私漏洞在心理健康應用業務中廣泛存在,其中包括虛擬治療,情緒監視器和聊天機器人。

根據Mozilla Foundation等獨立監管機構的說法,許多平台使用法規差距來交換或出售個人數據。該基金會調查了32次著名的心理健康應用,並得出結論,19個未能充分保護用戶隱私和安全性,這引起了人們對精神健康挑戰的貨幣化的擔憂。

聊天機器人創作者已經採取了步驟來保護用戶的隱私,儘管結果不同。 Chatgpt的主頁切換允許用戶防止無限的對話歷史記錄存儲。儘管這並不能阻止違規行為,但該平台承諾,使用此功能的人的對話只會保留30天,並且不會用於模型培訓。

吟遊詩人可能會在bard.google.com上找到刪除聊天活動的默認方法。微軟發言人說,Bing用戶可以監視和刪除其聊天機器人主頁上的搜索歷史記錄的談話。用戶無法停用聊天歷史記錄。

如何安全地將AI聊天機器人用於心理健康

專家建議用戶成為警惕隱私如《華爾街日報》報導,使用生成的AI技術。 Mayer Brown隱私和網絡安全合作夥伴Dominique Shelton Leipzig表示,缺乏隱私通知表明治理不佳。過多的個人信息收集是另一個危險信號。

用戶還應避免向身份不明的AI聊天機器人提供關鍵信息,因為他們可能會受到惡意演員的控制。馬爾卡庫拉(Markkula)應用道德中心的互聯網道德計劃主任伊琳娜·雷庫(Irina Raicu)警告不要披露健康或財務數據,因為聊天機器人公司的服務條款通常允許人類人員查看某些討論。

在使用用於心理健康的AI聊天機器人之前,消費者應權衡風險和獎勵,並閱讀平台的服務條款和隱私政策。為了改善心理健康,利益相關者強調了隨著數字健康行業的發展,需要理解AI技術的需求。