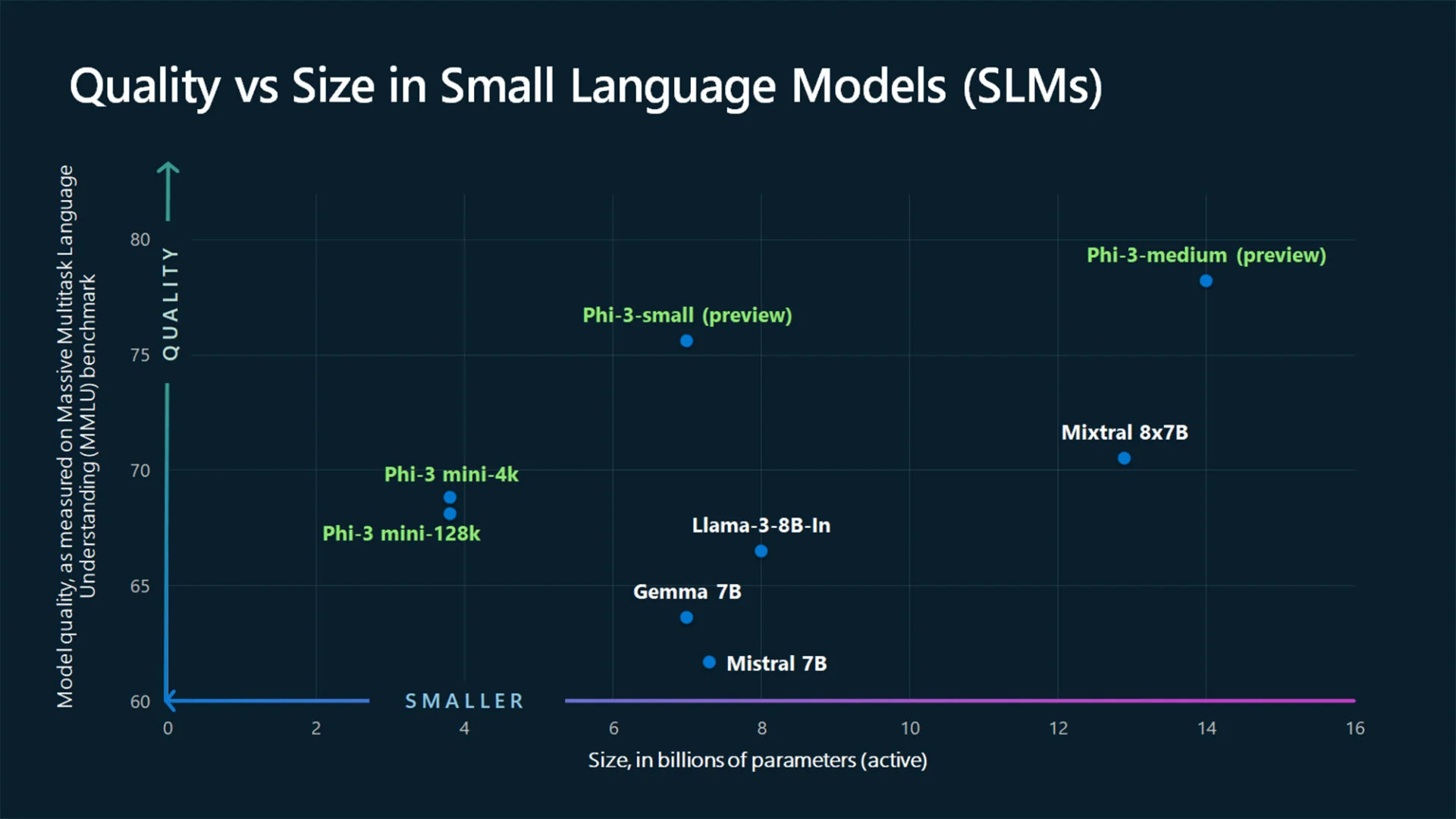

SLM ที่เรียบง่ายซึ่งมีพารามิเตอร์เพียง 3.8 พันล้านพารามิเตอร์ แต่สามารถยืนหยัดกับ LLM ที่ใหญ่กว่าได้ เนื่องจากการฝึกอบรมระดับสูง

ในช่วงไม่กี่เดือนที่ผ่านมา ส่วนใหญ่เป็น LLM (โมเดลภาษาขนาดใหญ่) ซึ่งอยู่แถวหน้าร่วมกับในฐานะผู้นำด้านโซลูชันอย่าง ChatGPTหรือราศีเมถุน- อย่างไรก็ตาม ยักษ์เหล่านี้มีข้อบกพร่อง: ความใหญ่โตซึ่งมีพารามิเตอร์จำนวนมาก ความท้าทายในการจัดการสิ่งเหล่านี้ในท้องถิ่น ดังนั้นภายใต้เงาของยักษ์โมเดลภาษาสำหรับ AIคนเจียมเนื้อเจียมตัวมากขึ้นพัฒนา พวกเขาถูกเรียกตามตรรกะว่า SLM สำหรับโมเดลภาษาขนาดเล็ก- ในบรรดาหน่ออ่อนเหล่านี้ เราพบสายพันธุ์ต่างๆ เช่น Gemma 2B และ 7B จาก Google, Claude 3 Haiku จาก Anthropic หรือแม้แต่ Llama 3 8B จาก Meta Microsoft เพิ่งเปิดตัวใหม่: Phi-3 Mini

Phi-3 Mini ตัวแทนคนแรกของทั้งสามคน

Phi-3 Mini เป็นตัวแทนสายสามเมล็ดที่เปิดเผยต่อสาธารณะรายแรก อีกสองแห่งที่คาดว่าในอีกไม่กี่เดือนข้างหน้าคือ Phi-3 Small และ Phi-3 Medium ในแง่ของจำนวนพารามิเตอร์ แบบจำลองเหล่านี้ต้องการดิน 3.8 พันล้าน 7 พันล้าน และ 14 พันล้านตามลำดับ นอกจากนี้ ดังที่คุณคงเข้าใจแล้วว่าหมายเลข 3 มีแบบอย่าง: Phi-1 และ Phi-2 ซึ่งรุ่นหลังเปิดตัวเมื่อเดือนธันวาคมปีที่แล้ว

แม้จะมีขนาดที่เล็ก แต่ Phi-3 Mini ก็ไม่ได้ไร้ประสิทธิภาพ Microsoft อ้างว่าให้ประสิทธิภาพที่ดีกว่ารุ่นที่มีขนาดสองเท่า ในแถลงการณ์ที่ส่งถึงเพื่อนร่วมงานของเราที่เดอะเวิร์จเอริค บอยด์ รองประธาน Microsoft Azure AI Platform กล่าวเสริมว่า“Phi-3 Mini มีประสิทธิภาพพอๆ กับ LLM เช่น GPT-3.5 แต่ในรูปแบบที่เล็กกว่า”-

SLM ที่ได้รับการฝึกอบรมโดยใช้ LLM

ดังที่คุณสามารถจินตนาการได้ เพื่อให้โมเดล SLM มีประสิทธิภาพ โมเดลนั้นต้องได้รับการฝึกอบรมมาเป็นอย่างดี แม้ว่า LLM จะถูกรวบรวมผ่านข้อมูลจำนวนมหาศาลที่รวบรวมบนอินเทอร์เน็ต แต่สำหรับ SML การเก็บเกี่ยวดังกล่าวก็ไม่เกี่ยวข้องกัน ด้วยเหตุนี้ ทีม Microsoft จึงใช้แนวทางที่แตกต่างออกไปในการฝึกอบรม Phi-3 Mini“แทนที่จะฝึกอบรมเกี่ยวกับข้อมูลเว็บดิบ ทำไมไม่ลองค้นหาข้อมูลคุณภาพสูงแทนล่ะ -สรุป Sébastien Bubeck รองประธาน Microsoft ที่รับผิดชอบด้านการวิจัยเกี่ยวกับ generative AI

อย่างไรก็ตามตามที่บริษัทระบุหาก“การแยกแยะข้อมูลคุณภาพสูงจากข้อมูลคุณภาพต่ำนั้นไม่ใช่เรื่องยากสำหรับมนุษย์”(การยืนยันที่ถกเถียงกัน) มันมีมากกว่านั้นมากสำหรับโมเดลภาษา ซึ่งจนกว่าจะพิสูจน์เป็นอย่างอื่น เป็นเพียงเครื่องดูดฝุ่นข้อมูลโดยไม่มีความสามารถในการให้เหตุผลใดๆ อย่างไรก็ตาม Microsoft ใช้ LLM เพื่อดำเนินการคัดแยกเบื้องต้นรวมถึงการเลือกข้อมูลที่เกี่ยวข้อง ผู้ฝึกสอนรูปแบบใหม่ที่อธิบายความเป็นเลิศของ Phi-3 Mini ตามที่บริษัทระบุ

“พลังของโมเดลภาษาขนาดใหญ่รุ่นปัจจุบันเป็นเครื่องมือที่เราไม่เคยมีมาก่อนในแง่ของการสร้างข้อมูลสังเคราะห์”เน้นย้ำ Ece Kamar ผู้อำนวยการ Microsoft Research AI Frontiers Lab โดยพื้นฐานแล้ว เราจะพบภาพ Epinal ของอาจารย์และนักเรียนเล็กน้อย ซึ่งเป็นส่วนแรกที่กลั่นกรองความรู้ของเขาไปยังส่วนที่สอง

ในความเป็นจริง โมเดล AI ขนาดเล็กมีราคาถูกกว่าในการใช้งานมากกว่าโมเดลขนาดใหญ่ และเหนือสิ่งอื่นใด ช่วยอำนวยความสะดวกในการใช้งานในท้องถิ่นในสถานะปัจจุบันของฮาร์ดแวร์

ความเฉพาะเจาะจงที่อธิบายโดย Microsoft ดังต่อไปนี้: บริษัทเขียนว่าเนื่องจากความสามารถของ SLM ในการทำงานแบบออฟไลน์ ผู้คนจำนวนมากขึ้นจึงจะสามารถใช้ AI ในลักษณะที่ไม่เคยทำได้จนถึงตอนนี้ และหากในยุคของทุกสิ่งที่เชื่อมต่อกัน การขอแชทบอทที่ทรงพลังผ่านเซิร์ฟเวอร์นั้นดูเหมือนจะผ่านไม่ได้ ในความเป็นจริงแล้วเป็นคำพูดจากชาวเมืองที่อาศัยอยู่ในประเทศที่มีโครงสร้างพื้นฐานเครือข่ายที่ค่อนข้างได้รับการพัฒนา: บริษัท Redmond กล่าวถึงกรณีนี้เพียงเท่านั้น ของพื้นที่ชนบทที่ขาดบริการโทรศัพท์เคลื่อนที่ โดยเฉพาะอย่างยิ่ง ตัวอย่างของชาวนาที่ตรวจสอบพืชผลของตนและพบสัญญาณของโรคบนใบหรือกิ่ง จะสามารถใช้ SLM ที่ติดตั้งด้วยความสามารถในการมองเห็นเพื่อถ่ายภาพพืชผลที่เป็นปัญหา และได้รับคำแนะนำทันทีเกี่ยวกับ วิธีการรักษาปรสิตหรือโรค – การวินิจฉัยและการบำบัดอาจสั่งการโดยไบเออร์โดยตรง แต่นั่นเป็นอีกข้อถกเถียงหนึ่ง

Luis Vargas รองประธานฝ่าย AI ของ Microsoft บรรยายถึงโลกในอุดมคติที่“หากคุณอยู่ในส่วนหนึ่งของโลกที่ไม่มีเครือข่ายที่ดี คุณจะยังสามารถได้รับประโยชน์จากประสบการณ์ AI บนอุปกรณ์ของคุณ”;สิ่งนี้ต้องขอบคุณ SLM โอ้ความสุข!

🔴 เพื่อไม่ให้พลาดข่าวสารจาก 01net ติดตามเราได้ที่Google ข่าวสารetวอทส์แอพพ์-

แหล่งที่มา : ไมโครซอฟต์