把可爱的狗狗放进去机器并观察他们的大脑他们就其本身而言,看家庭电影听起来可能是一种欢乐的时光。 作为奖励,它也可以具有教育意义。

一组科学家已经做到了这一点,他们使用解码一对狗狗大脑中发生的视觉处理。 他们发现了犬类和人类感知之间的一个令人着迷的差异:狗在视觉上更能适应动作,而不是谁或什么正在执行这些动作。

这可能是犬类认知难题的一个重要部分,因为它揭示了狗的大脑在视觉方面的优先顺序。

“虽然我们的工作仅基于两只狗,但它提供了这些方法对犬科动物有效的概念证明,”神经科学家艾琳·菲利普斯说,当时是埃默里大学,现在是普林斯顿大学。

“我希望这篇论文有助于为其他研究人员将这些方法应用于狗以及其他物种铺平道路,这样我们就可以获得更多数据并更深入地了解不同动物的思维如何运作。”

正如菲利普斯指出的那样,这项研究是在两只狗黛西和布博身上进行的。 该团队使用万向节和自拍杆拍摄了三个 30 分钟的视频,内容涉及狗的特定内容。 这包括狗到处乱跑,以及人类与狗互动,给它们宠物或零食。 其他活动包括车辆经过、人类彼此互动、鹿穿过小路、房子里有只猫以及牵着皮带行走的狗。

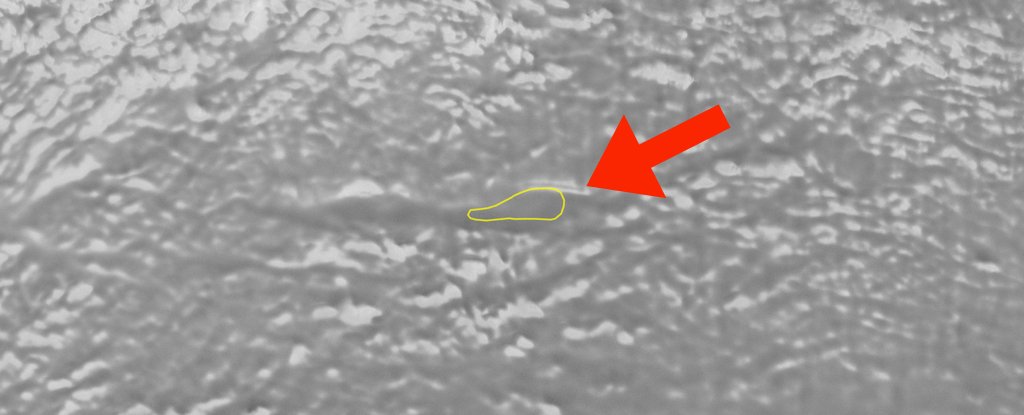

Daisy 和 Bhubo 分别在 3 个 30 分钟的课程中观看了这些电影,总共 90 分钟,同时在功能磁共振成像机器中无拘无束地放松。 这一非凡的成就是通过使用心理学家格雷戈里·伯恩斯设计的训练技术取得的,他在十年前首次成功地对一只完全清醒、不受约束的狗进行了核磁共振成像。

因此,当黛西和布博清醒、警觉、舒适地坐在机器里观看专门为他们拍摄的家庭电影时,研究人员还能够扫描他们的大脑。 实际上听起来不错。

“他们甚至不需要款待,”菲利普斯说。 “这很有趣,因为它是严肃的科学,并且投入了大量的时间和精力,但归根结底是这些狗观看其他狗和人类表现得有点愚蠢的视频。”

视频数据按时间戳进行分段,以识别物体(例如狗、人、车辆或其他动物)或动作(例如嗅、吃或玩)等分类器。 这些信息以及两只狗的大脑活动被输入一个名为 Ivis 的神经网络,该网络旨在将大脑活动映射到这些分类器。

两个人也在接受核磁共振检查时观看了这些视频。 该数据也已提供给 Ivis。

对于物体分类器和动作分类器,人工智能能够以 99% 的准确率将人脑数据映射到分类器。 有了狗,艾维斯就有点摇摇欲坠了。 它对于对象分类器根本不起作用。 然而,对于动作,人工智能将视觉映射到大脑活动,准确度在 75% 到 88% 之间。

“我们人类是非常面向对象的,”伯恩斯 说。 “英语中的名词数量是动词的 10 倍,因为我们对命名物体特别着迷。狗似乎不太关心它们看到的是谁或什么,而更关心动作本身。”

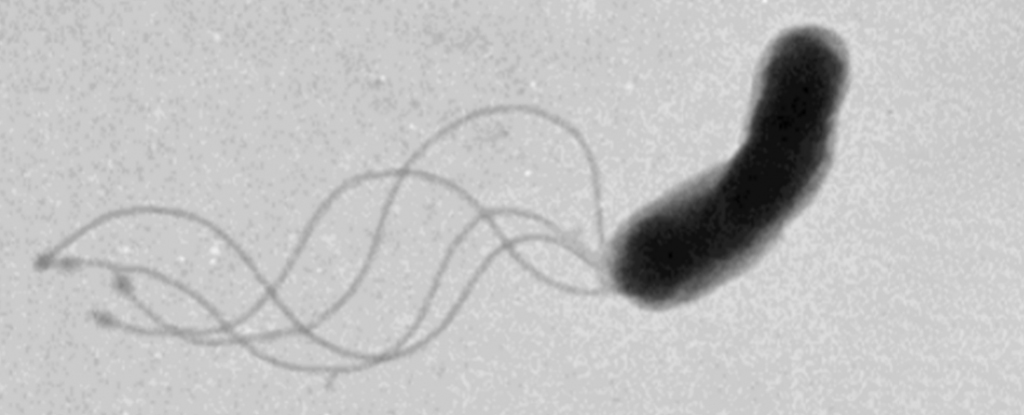

他补充说,与人类相比,狗感知世界的方式存在显着差异。 它们只能区分我们所感知的光谱中蓝色和黄色部分的色调,但具有更高密度的运动敏感视觉感受器。

这可能是因为狗需要比人类更了解环境中的威胁。 或者它可能与对其他感官的依赖有关; 或者也许两者兼而有之。 人类非常注重视觉,但对于狗来说,它们的嗅觉是最强大的,它们的大脑中有很大一部分用于处理嗅觉信息。

将大脑活动映射到嗅觉输入可能是一个设计起来比较棘手的实验,但它也可能具有启发性。 未来还可以对狗以及其他动物的视觉感知进行进一步、更详细的研究。

“我们证明,我们可以监测狗在观看视频时的大脑活动,并至少在有限的程度上重建它所看到的内容,”伯恩斯 说。 “我们能够做到这一点,这一事实是了不起的。”

该研究发表在可视化实验杂志。