AMD 的 SLM

与该领域的其他巨头一样,AMD 也已进军 SLM(小语言模型,小语言模型)及其开源模型 AMD-135M。该公司在 9 月 17 日发布的技术博客中详细介绍了这一点;她现在通过一篇更广泛的公开文章揭露了这一点。 AMD-135M 还可通过 HuggingFace 和 GitHub 获取。

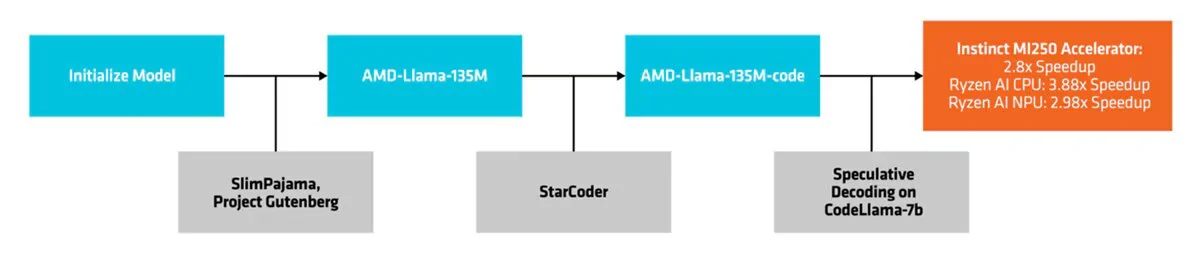

这个小语言模型属于 Llama 家族(它正是基于 LLaMA2 架构)。它有两个版本:AMD-Llama-135M 和 AMD-Llama-135M-code。

两者都依赖于推测解码。这种方法的基本原理是什么?使用一个小的初步模型生成一组潜在的代币,然后通过更大的目标模型进行验证。

AMD-135M 使用 AMD Instinct MI250 加速器对 6700 亿个令牌进行了训练。由于有四个 MI250 节点(每个节点有四个 MI250 加速器),该过程需要六天时间。 AMD 表示,它使用 SlimPajama 和 Project Gutenberg 数据集(包含 70,000 多本免费电子书的库)来预训练这个 1.35M 的模型。

AMD-Llama-135M-code 变体已使用 200 亿个专门用于编码的代币进行了改进。在四个 MI250 加速器上完善此代码花了整整四天的时间。

SLM 与 LLM

我们已经解释过了微软在部署Phi-3 Mini过程中SLM相对于LLM的优势。如果您需要一些回顾,有关 AMD-135M 的原始文章提供了一些有趣的见解。无论如何,要了解有关此主题的更多信息,请随时咨询我们定义 AI 语言模型的文件。

该文件回顾说,尽管法学硕士很重要,“较小的语言模型 (SLM) 有一个令人信服的案例,它为平衡性能和操作约束提供了实用的解决方案”。正如您从上文中了解到的,虽然训练 LLM 通常需要各种高端 GPU,但 SLM 提供了另一种解决方案。此外,该出版物还强调“虽然有一种方法可以获得训练有素的法学硕士,但通常很难在计算资源非常有限的客户端设备上有效地运行它”。此外,AMD 还强调了其 SLM AMD-135M 的推理解码优势,不仅适用于 Instinct MI250 加速器,还适用于消费类硬件,在本例中为 Ryzen 9 PRO 7940HS。

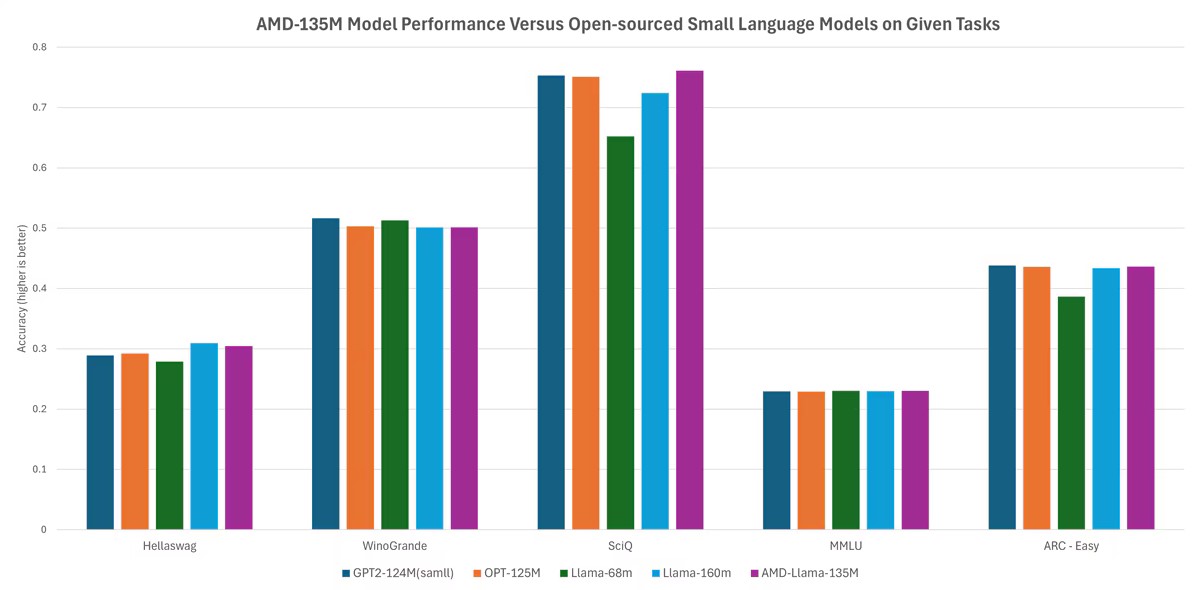

最后,AMD 声称,在没有用数字压倒你的情况下“性能可与市场上最受欢迎的型号相媲美”(Llama-68M 和 Llama-160M;GPT2-124M;OPT-125M)用于 Hellaswag、WinoGrande、SciQ、MMLU 和 ARC-Easy 中的 AMD-135M 模型。

来源 : AMD