当前的人工智能算法在RAM方面极为要求:处理器和系统内存之间的数据传输对于此类应用程序至关重要,并且这些算法的性能取决于可用的带宽。面对这个观察Nvidia目前正在发展 - 与该行业的知名人士合作例如三星,SK Hynix和Micron-新的记忆标准专门为满足这些需求而设计。受洗SOCAMM((芯片高级内存模块上的系统),这种新的RAM体系结构应在下一代SO称为“个人”超级计算机中使用。无论如何,这是Nvidia对这个市场的愿景。

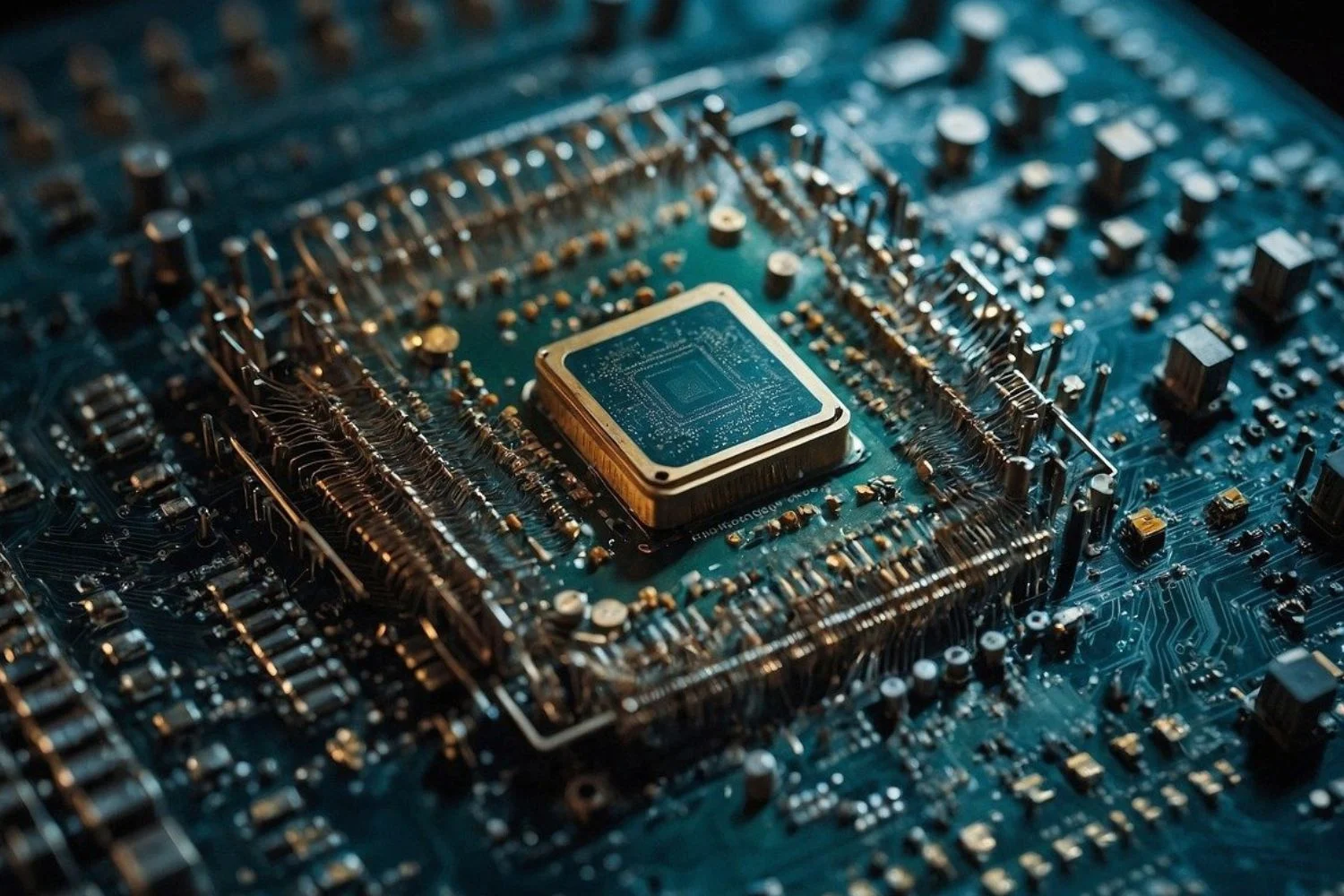

专用于AI计算的内存

SOCAMM内存的关键特征之一是其较大的输入/输出接口。 SOCAMM与I/O的694个端口合作,其中经典的DDR5计算机内存限制为260行。这种增加使得可以减轻处理器和内存之间数据传输中的瓶颈,从而大大加速加速度d'ia。比通常的DRAM更密集,此内存还可以根据Technologie LPDDR5X。SOCAMM记忆也采用模块化体系结构,允许用户在必要时轻松替换和升级内存模块。

NVIDIA计划将这种类型的内存整合到其未来的个人紧凑型AI系统中,尤其是在其框架内项目数字预计其第一端产品将于明年5月出现。这个旨在发展真实的迷你超级估计数,,,,首先,对于开发商和企业而言,以后可能会将其提供给公众。现在,NVIDIA无疑希望控制自己的记忆标准,毫无疑问,NVIDIA希望控制这一新兴生态系统。因此,制造商的方法可以使其具有显着的长期竞争优势。

来源 : 汤姆的硬件