計算機已經在國際象棋和“危險!”中擊敗了人類,現在他們可以在帽子上增加一根羽毛:在幾個經典的街機遊戲中最好人類的能力。

Google的一個科學家團隊創建了一個人工智能的計算機程序,可以教會自己玩Atari 2600視頻遊戲,僅使用最小的背景信息來學習如何玩遊戲。

研究人員今天(2月25日)(2月25日)在《自然》雜誌上報導,通過模仿人腦的一些原理,該計劃能夠與專業人類游戲玩家或更好的大多數遊戲中玩耍。 [超級智能機器:7機器人期貨這是給出的

這是任何人第一次建造人工智慧(AI)可以在倫敦Google Deepmind的AI研究人員Demis Hassabis的合著者Demis Hassabis研究合著者Demis Hassabis上(AI)的系統。

該AI程序的未來版本可用於更一般的決策應用程序,無人駕駛汽車哈薩比斯說,要進行天氣預測。

通過加強學習

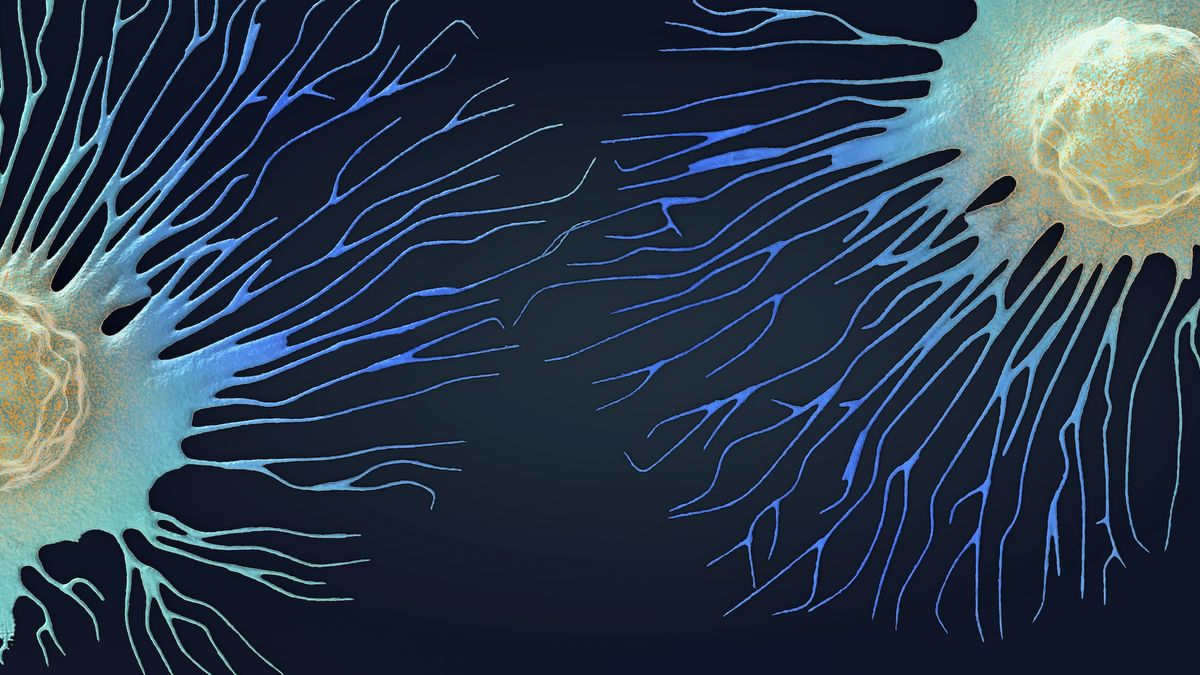

人類和其他動物通過加強來學習 - 從事最大程度的回報的行為。例如,愉快的經歷使大腦釋放化學神經遞質多巴胺。但是,為了在復雜的世界中學習,大腦必須從感官中解釋意見,並使用這些信號來概括過去的經驗並將其應用於新情況。

當IBM的深藍色計算機在1997年擊敗國際象棋大師Garry Kasparov時,人工智能的沃森計算機贏得了測驗節目“ Jeopardy!”哈薩比斯說,在2011年,這些被認為是令人印象深刻的技術壯舉,但主要是預編程的能力。相比之下,新的DeepMind AI能夠使用加固自身學習。

為了製定新的AI計劃,Hassabis及其同事創建了一個基於人工神經網絡”深度學習,“一種機器學習算法,逐漸構建了原始數據的更抽象的表示。(Google著名地使用深度學習來訓練計算機網絡以基於數百萬YouTube視頻識別貓,但是這種類型的算法實際上參與了許多Google產品,從搜索到翻譯。)

新的AI程序稱為“ Deep Q-Network”或DQN,它在常規台式計算機上運行。

玩遊戲

研究人員在49場經典Atari 2600遊戲中測試了DQN,例如“ Pong”和“ Space Invaders”。有關該程序收到的遊戲的唯一信息是屏幕上的像素和遊戲分數。 [查看Google AI玩視頻遊戲的視頻這是給出的

“該系統學會通過基本上按鍵隨機按鍵來播放”,以取得很高的成績,研究合著者Volodymyr Mnih也是Google DeepMind的研究科學家。

研究人員說,經過幾週的培訓,DQN和專業人類游戲玩家在許多遊戲中都表現出色,從側滾動射手到3D賽車比賽。他們補充說,AI計劃在一半以上的比賽中得分的75%。

有時,DQN發現了研究人員甚至沒有想到的遊戲策略,例如,在遊戲“ Seaquest”中,玩家控制著潛艇,必須避免,收集或破壞不同深度的物體。研究人員說,AI計劃發現,只需將潛艇放在地面以下,就可以保持生命。

更複雜的任務

DQN還利用了另一個功能人的大腦:記住過去的經歷並重播它們以指導動作的能力(在稱為海馬的海馬形大腦區域發生的過程)。同樣,DQN從其經驗中存儲了“回憶”,並將其送回了遊戲期間的決策過程。

但是人類的大腦並不記得所有的經歷。他們有偏見是要記住更多充滿情感的事件,這可能更重要。研究人員說,DQN的未來版本應納入這種偏見的記憶。

既然他們的計劃已經掌握了Atari遊戲,那麼科學家就開始在90年代(例如3D賽車遊戲)上對其進行測試。哈薩比斯說:“最終,如果這種算法可以在賽車比賽中進行賽車比賽,並進行額外的調整,它應該能夠駕駛真正的汽車。”

此外,AI計劃的未來版本可能能夠做一些事情,例如計劃前往歐洲的旅行,預訂所有航班和酒店。但是,哈薩比斯說:“但是我們最興奮地使用AI來幫助我們做科學。”

關注Tanya Lewis上嘰嘰喳喳。跟著我們@livescience,,,,Facebook和Google+。原始文章現場科學。