最新的旗艦人工智能模型 Maverick 在 LM Arena 上獲得第二名後引起了轟動,LM Arena 是一個由人類評估者評估人工智能模型對質量排名的反應的平台。

然而,在人工智能研究人員發現基準測試中使用的 Maverick 版本並非開發人員公開可用的版本後,爭議爆發了。

Maverick 在 LM Arena 上令人印象深刻的表現一開始似乎證實了 Meta 推動最先進對話式人工智能前沿的主張。然而,進一步挖掘發現,測試的模型不是一般版本,根據科技博客。

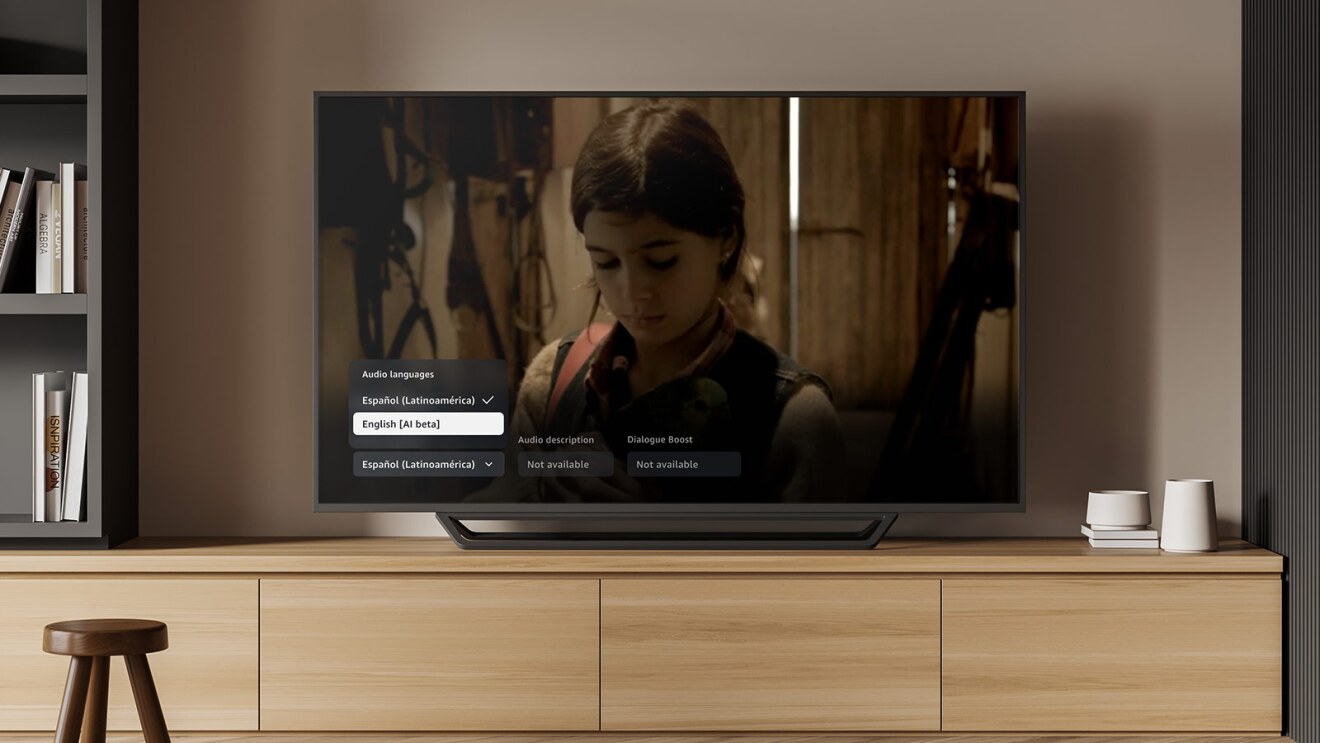

相反,Meta 在其官方聲明中強調,它在 LM Arena 上推出的版本是“實驗性聊天版本”——這一點在基準分數中沒有明確引起注意。

Meta 自己的致電網站,比較表驗證了 LM Arena 測試是使用“針對對話性進行優化的 Llama 4 Maverick”進行的。據說這個變體進行了旨在改善對話的特殊調整,這可能會比其他人工智能創建者的優化程度較低或“普通”版本帶來不公平的利益。

傳統上,LM Arena 儘管可能不完美,但已作為中立基礎的近似功能,按照人類標準將大型語言模型相互對抗。絕大多數參與的人工智能公司都發布了公開發布的模型的未經修改的版本,或者在進行更改時已經開放。

相比之下,Meta 的方法因不透明而受到批評。通過不透露優化模型,而是提供微調程度較低的公共模型,開發人員會產生錯誤的性能期望,從而使人們對 Maverick 在實際設置中實際可以完成的任務感到困惑。

人工智能研究人員指出了差異

X 專家報導LM Arena 版本的 Maverick 的行為與其可下載的版本有很大不同。一些人指出其過度使用表情符號,而另一些人則注意到冗長且過於精緻的答案,以及默認版本中未找到的操作。

這種差異引出了一個重要問題公司是否有權專門針對基準調整模型並對公眾隱藏這些版本?

Meta 和 Chatbot Arena 目前保持沉默

儘管強烈反對聲不斷增加,但其他人呼籲 Meta 和 Chatbot Arena(運營 LM Arena 的實體)保持透明度。截至發稿,雙方均未對此事做出回應。

這在人工智能研究中有些令人擔憂:必須採用標準化、開放的基準來衡量現實世界的性能,而不是精心挑選的結果。隨著人工智能影響從客戶支持到內容生成的方方面面,真實的表達比以往任何時候都更加重要。