Meta 現在將重點放在人工智慧上。近幾個月來,馬克祖克柏團隊的研究人員透露大量的創新依靠人工智慧。我們特別舉一下Voicebox,一種能夠模仿人類聲音的人工智慧, 語言模型駱駝2, 或者音樂產生器,一個可以按需製作音樂的工具。

這家門洛帕克巨頭並不打算就此止步。 Meta 在其網站上剛剛發布了一份專門針對人工智慧的報告,該報告旨在解碼人腦中正在發生的事情。人工智慧確實能夠理解個人腦海中的圖像。隨後,AI會重現他腦海中看到的畫面。

AI如何讀懂大腦?

為了實現這一壯舉,Meta 依靠腦磁圖(MEG),這是一種大腦成像技術,測量電磁活動大腦的。透過收集“數千次大腦活動測量”每秒,系統將“解碼大腦中視覺表徵的部署 »。 Meta 開發了一個“解碼模型”基於人工智慧來了解神經元活動產生的磁場。

資料處理完畢後,將連結到上游人工智慧開發的視覺表示。這些表示法是由圖像編碼器產生的,該編碼器具有“一起致富”不同的視覺效果。換句話說,現有的圖像將與大腦中檢測到的圖像進行比較。這就是“大腦編碼器”最後,人工智慧將產生一個。« 圖像可信 »基於目標思想中的視覺效果。請注意,視覺圖像是由大腦不斷生成的,可以提供對人類思維中正在發生的事情的獨特見解。

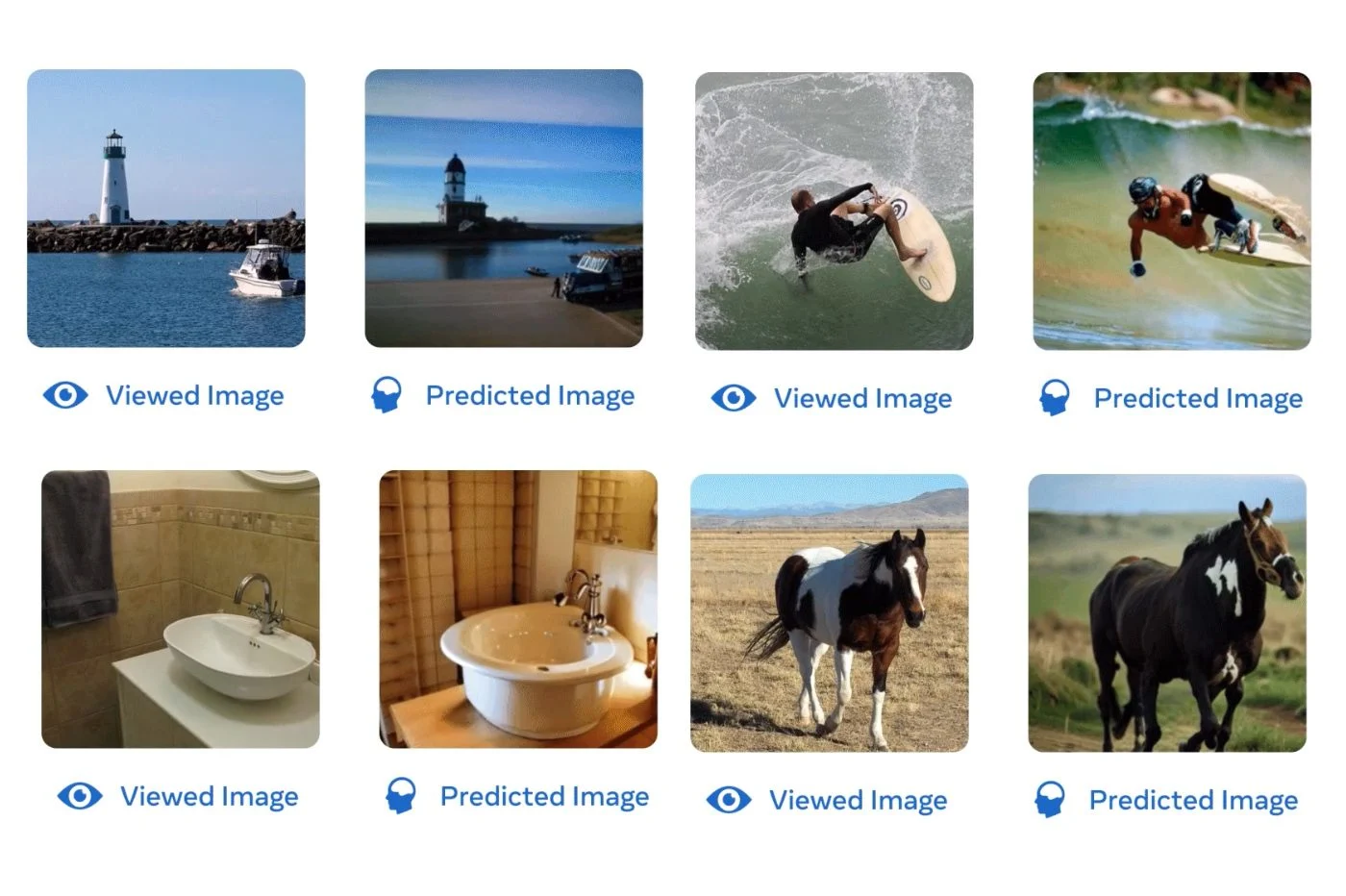

作為實驗的一部分,該公司首先向志願者展示了人工智慧提供的圖像。同時,腦磁圖機掃描了他們大腦的訊號。 Meta 分享了其報告中產生的結果的幾個範例。在大多數情況下,最終結果與最初顯示的影像相去不遠。人工智慧通常依靠波浪及其視覺庫來再現圖像的主要物件。

“我們的結果表明,MEG 可用於以毫秒精度破解大腦中產生的複雜表徵的出現”,Meta 總結道。

人工智慧的局限性

此時,AI首先必須對個人的大腦活動進行訓練在被用來破解思想之前。該系統必須經過一段訓練期,使其習慣於解釋特定的腦波。同樣,語言模型必須在大量文字上進行訓練,然後才能為聊天機器人設定動畫。

此外,沒有跡象顯示這項仍處於起步階段的技術可以解碼未經人工智慧處理的圖像。雖然 Meta 承諾未來會取得進一步進展,但它相信其技術可以使設計成為可能“非侵入性腦機介面”幫助失去說話能力的人。

請注意,這並不是人工智慧第一次能夠讀懂人類的思想。今年夏天,美國研究人員透露能夠猜測一個人正在聽的音樂的人工智慧只能透過從大腦收集資料。在這裡,科學家再次依賴大腦發出的電訊號。

來源 : 元