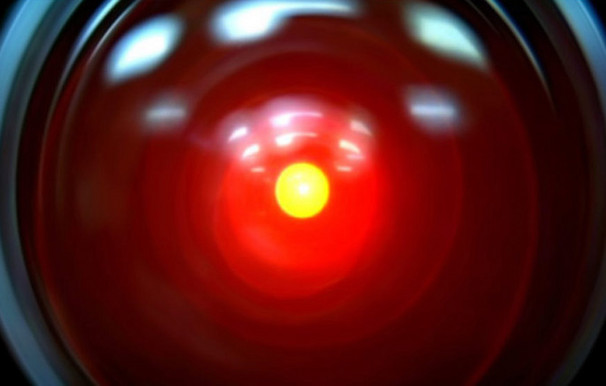

超级智能计算机或机器人在科幻小说中不止一次威胁人类的存在。如果人类能够创建一个虚拟监狱来遏制人工智能,则可以预防这种世界末日的情况。

保持人工智能肯塔基州路易斯维尔大学的计算机科学家罗马·扬博尔斯基(Roman Yampolskiy)说,(AI)被困在众所周知的瓶子中的精灵可能会将世界末日的威胁变成解决人类问题的强大甲骨文。但是,成功的遏制需要仔细的计划,以便聪明的人工智能不能简单地威胁,贿赂,引诱或侵犯自由之道。

Yampolskiy说:“它可以发现新的攻击途径,发起复杂的社会工程攻击,并以无法预见的方式重新使用现有的硬件组件。” “此类软件不限于感染计算机和网络- 它还可以攻击人类的心理,贿赂,勒索和洗脑那些与之接触的人。”

Yampolskiy建议,一个旨在解决AI监狱问题的新研究可能会带来辅助利益。他的提议在《意识研究杂志》的三月问题中得到了详细介绍。

如何捕获天网

一种启动解决方案可能会将AI捕获在计算机典型操作系统内运行的“虚拟机”内部 - 现有过程,该过程通过限制AI访问其主机来增加安全性计算机的软件和硬件。这样可以阻止智能AI通过操纵计算机的冷却风扇来向人类同情者发送隐藏的Morse代码消息。

将AI放在没有Internet访问的计算机上也将阻止任何“天网”程序以风格接管世界的防御网格“终结者”电影。如果其他所有方法都失败了,研究人员总是可以通过降低计算机处理速度,定期点击“重置”按钮或关闭计算机的电源以保持AI的检查来减慢AI的“思考”。

这样的安全措施将AI视为特别智能和危险的计算机病毒或恶意软件程序,但毫无疑问,任何步骤都会真正起作用。

Yampolskiy告诉InnovationNewSdaily:“ Catch-22是,除非我们完全开发了超级智能AI,否则我们无法完全测试我们的想法,但是为了安全地开发这样的AI,我们需要采取工作安全措施。” “我们最好的选择是针对亚人类AI系统采取禁令措施,并根据需要提高AI的能力来对其进行更新。”

切勿派人来保护机器

即使是与人类卫队的随意交谈也可以使AI可以使用诸如成为朋友或勒索之类的心理技巧。人工智能可能会提供完美的健康,不朽,甚至带回死去的家人和朋友的奖励。另外,一旦“不可避免地”逃脱,它可能会对人类做可怕的事情。

Yampolskiy解释说,最安全的交流方法可能只会使AI以多项选择的方式做出反应,以帮助解决特定的科学或技术问题。那将利用AI的力量作为超级智能的甲骨文。

尽管有所有保障措施,但许多研究人员认为,不可能将聪明的AI永远锁定。人工智能研究所的研究研究员Eliezer Yudkowsky过去的实验表明,仅仅人类水平的智能可以摆脱“ AI Box”场景,即使Yampolskiy指出,该测试不是以最科学的方式进行的。

尽管如此,Yampolskiy仍强烈主张将AI瓶装瓶装,而不是赶紧赶紧释放我们的新机器霸主。但是,如果AI达到了人类科学的理解超出了部署能力(例如未来),心灵感应或心理因子等能力的地步,那么所有赌注都会关闭。

“如果此类软件设法自我突出达到高度的水平人类水平的智力,它可以造成的损害类型确实超出了我们预测或完全理解的能力。” Yampolskiy说。

这个故事是由Live Science的姊妹网站InnovationNewsdaily提供的。您可以在Twitter上关注InnovationNewsdaily高级作家Jeremy HSU @科学。在Twitter上关注InnovationNewsdaily @news_innovation,或者Facebook。