Openai曾与欧洲立法者进行竞选,以便其诸如Chatgpt或Dall-E之类的生成AI系统将被视为“高风险系统”,这是欧洲对AI法规中定义的类别。他的某些要求(旨在大大减少他未来的义务)被包括在6月14日通过欧洲议会通过的文本中。

这是一个社会的故事,一方面继续重复,必须调节人工智能。在上个月的欧洲巡回演唱会上,山姆·奥特曼(Sam Altman)首席执行官Openai告诉任何想听的人迫切需要为该部门制定规则。正是这个社会在另一个社会中谨慎地试图通过减轻这些规则的范围,以减轻这些规则的范围”监管负担»未来计划欧洲对AI的监管,报告时间,6月20日,星期二。我们的同事们展示了导致Chatgpt的初创企业如何与欧洲立法者联系,以提出过去十二个月的人工智能法规的变化。

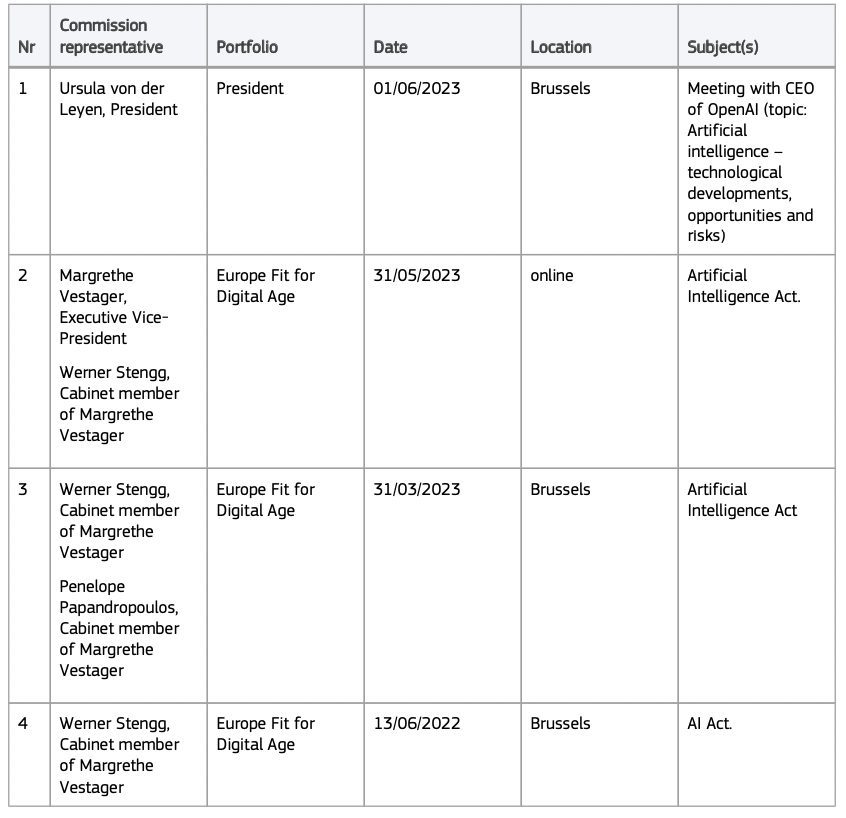

这些完全合法的游说行动将是有效的。如此发出的一些论点相信欧洲议会议员,他们被采用了,正如我们在6月14日在全体会议上投票的版本中所看到的。它已经始于一年前,即2022年6月,早在启动之前就开始chatgpt,报告我们的同事。在欧洲立法者的透明度登记册中,一个在线数据库均可访问所有列出团体和游说组织试图影响欧洲立法者的组织,确实有第一次约会在2022年6月13日,布鲁塞尔的欧洲委员会副主席玛格丽特·维斯塔格(Margrethe Vestager)的内阁成员。

在第一次会议上,OpenAI代表将对AI系统的通用使用系统表示关注 - 如GPT3,该系统将包括在高风险系统中,这是在许多透明度和监督义务的欧洲法规中定义的类别。

如果将ChatGpt分类为此类,那么从理论上讲,它应该通过初步评估程序,并在能够被欧洲人访问之前进行合规性控制。 OpenAI还有义务建立风险管理系统,即用于培训,人类控制系统的数据治理的具有约束力的政策,除了遵守准确性,鲁棒性和网络安全义务。根据这次第一次会议,初创企业的蓄意及其对创新的影响已经将是挥舞着创新的范围。时间谁想保持匿名。这次,Openai的代表不会进一步走。他们不会明确要求更灵活的规则。

共享白皮书,并要求对文本进行修改

但是在2022年9月,后者通过发送白皮书返回了指控向欧盟委员会和理事会的代表,一份七页的文件由我们的同事出版。这家初创公司称,我们可以阅读OpenAI的论点,该论点描述了制定的不同保障措施,以防止其生成的AI系统不健康。所有这些措施都应该足以在高风险工具中对其生成的AI进行分类,并恳求公司。 “”总体而言,GPT-3不是高风险系统。但是[IT]具有可能在高风险用例中使用的能力“写白皮书的作者。

«他们所说的基本上是:相信我们自我调节»,,评论丹尼尔·莱弗(Daniel Lefer时间。 “这是非常令人困惑的,因为他们是通过对政治家说“请,请监管我们”的政治家,他们夸耀了他们采取的所有[安全]措施,但是当您告诉他们“好吧,好吧,请他们通知他们并设置监管层”,他们说不,没有说明他继续。去年5月,Openai的首席执行官警告过他可以”停止活动在欧洲,如果他认为自己无法遵守欧洲法规,他的文字“很多“批评家...回溯之前。

欧洲议员的文本中提出的某些要求

然后,白皮书走得更远。建议修正»:例如,OpenAI希望出于安全原因进行系统更新,而不必通过新的欧盟评估来熨烫。该公司还恳求将AI在教育和就业中的某些用途被视为高风险,例如产生工作。他的论点吸引了公牛的眼睛吗?

是的,对于某些人来说,因为几个月后,欧洲议会最终发布了705 MEPS同意的法规版本。委员会和理事会先前版本中的句子表明必须将通用使用的IA系统本质视为高风险,已经消失了。取而代之的是,议会所采用的文本唤起了“基本模型”或经过大量数据培训的AI系统的开发人员。后者应仅遵守一些义务,例如提到该系统已被版权保护的数据绘制,或者避免产生非法内容。

Openai的成功可能不会在文本的最终版本中占据

Openai的另一个成功:在白皮书中,初创企业反对修改MEP的提议将在“高风险”类别中对诸如chatgpt和dall-e等生成的AI系统进行分类,从文本或产生的图像通过的那一刻- 这将导致自动将这些AI分类为出现高风险。 Openai解释说,提及“ AI产生的内容”的义务就足够了。最后,欧洲议员没有保留有关的修正案。

最终,在3月31日的最后一次会议中,登记册中列出了著名的欧洲官员。他们会避免拥有制造Chatgpt发行的危险物质的食谱。但是安全的保障措施很容易绕过,强调了时间,可以带来的chatgpt编写网络钓鱼电子邮件或生成说明以制造非法物质。

如果Openai设法主张了自己的观点,则由于AI法规尚未投票,情况仍然可能发生变化,因此现在必须在Trilogue中进行讨论。欧洲议会,理事会和欧洲委员会将同意的最终版本可能包括更严格的AI系统规则,例如Chatgpt等一般使用……对于Sam Altman的最大不幸。

来源 : 时间