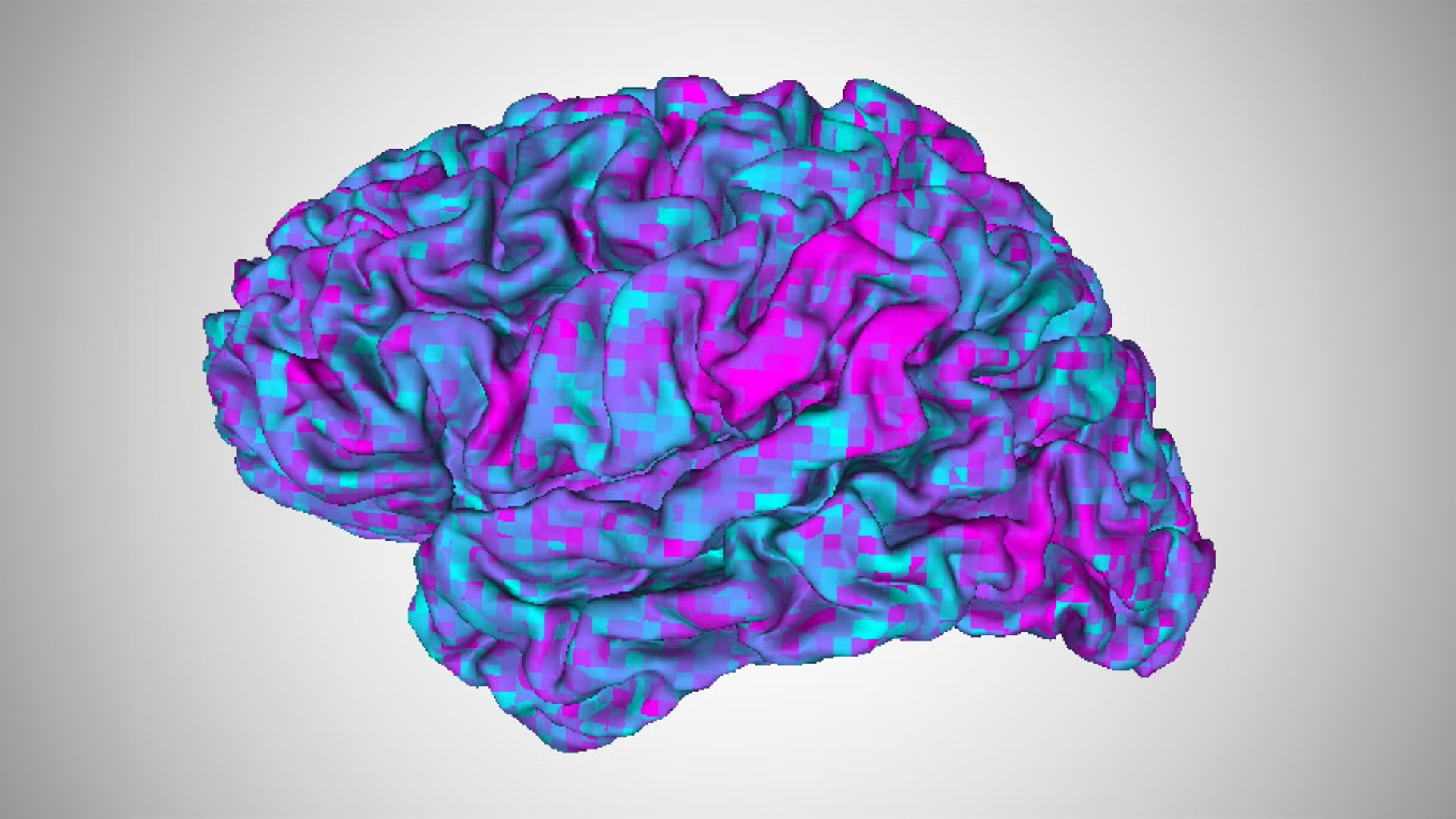

科學家對“大腦解碼器”進行了新的改進(AI)將思想轉化為文本。

研究小組在一項新研究中報告說,他們的新轉換器算法可以快速訓練另一個人大腦上的現有解碼器。科學家們表示,這些發現有一天可能會為失語症患者提供支持,失語症是一種影響人溝通能力的腦部疾病。

研究合著者說:“患有失語症的人在理解語言和表達語言方面常常遇到一些困難。”亞歷山大·胡特,德克薩斯大學奧斯汀分校(UT Austin)的計算神經科學家。 “因此,如果是這樣的話,那麼我們可能根本無法通過觀察他們的大腦如何響應他們所聽的故事來為他們的大腦建立模型。”

2 月 6 日發表在期刊上的新研究現代生物學、胡斯和合著者唐杰瑞德克薩斯大學奧斯汀分校的一名研究生研究瞭如何克服這一限制。 “在這項研究中,我們問,我們可以採取不同的做法嗎?”他說。 “我們能否將我們為一個人的大腦構建的解碼器轉移到另一個人的大腦上?”

研究人員首先對一些參考參與者進行了長時間的大腦解碼器訓練——在參與者聽 10 個小時的廣播故事時收集功能性 MRI 數據。

然後,他們對參考參與者和另一組不同的“目標”參與者訓練了兩種轉換器算法:一種使用參與者花 70 分鐘收聽廣播故事時收集的數據,另一種使用參與者花 70 分鐘觀看與廣播故事無關的無聲皮克斯短片時收集的數據。

使用一種稱為功能對齊的技術,該團隊繪製出了參考參與者和目標參與者的大腦如何對相同的音頻或電影故事做出反應。他們利用這些信息來訓練解碼器與目標參與者的大腦一起工作,而不需要收集多個小時的訓練數據。

接下來,團隊使用一個參與者以前從未聽過的短篇故事來測試解碼器。儘管解碼器對原始參考參與者的預測比使用轉換器的參與者稍微準確,但它從每個參與者的大腦掃描中預測的單詞在語義上仍然與測試故事中使用的單詞相關。

例如,測試故事的一部分包括有人討論他們不喜歡的工作,說“我是一家冰淇淋店的女服務員。所以,嗯,那不是……我不知道我想去哪裡,但我知道不是那樣。”使用經過電影數據訓練的轉換器算法的解碼器預測:“我的工作我認為很無聊。我必須接受訂單,但我不喜歡它們,所以我每天都在處理它們。”休斯說,雖然不完全匹配,解碼器無法讀出人們聽到的確切聲音,但想法是相關的。

“真正令人驚訝和很酷的事情是,即使不使用語言數據,我們也可以做到這一點,”休斯告訴《生活科學》。 “因此,我們可以在某人觀看無聲視頻時收集數據,然後我們可以使用這些數據為他們的大腦構建這種語言解碼器。”

研究人員表示,使用基於視頻的轉換器將現有的解碼器傳輸給失語症患者可能會幫助他們表達自己的想法。它還揭示了人類通過語言和大腦中的視覺敘事表達思想的方式之間存在一些重疊。

“這項研究表明,有一些語義表示並不關心它來自哪種模態,”神谷幸康未參與這項研究的京都大學計算神經科學家告訴《生活科學》雜誌。換句話說,它有助於揭示大腦如何以相同的方式表示某些概念,即使它們以不同的格式呈現。

休斯說,該團隊的下一步是在患有失語症的參與者身上測試轉換器,並“構建一個界面,幫助他們生成他們想要生成的語言”。