當前的方法人工智慧最近對行業專家的調查顯示,(AI)不太可能創建與人類智能相匹配的模型。

在對調查的475名AI研究人員中,有76%的人說,大型語言模型(LLMS)的擴展是“不太可能”或“極不可能”實現人工通用情報(AGI),一個假設的里程碑,機器學習系統可以比人類有效或更好地學習。

這是對科技行業預測的一個值得注意的解僱,因為自2022年的生成AI繁榮以來,一直堅持認為,當前最新的AI模型只需要更多的數據,硬件,能源和金錢來抑制人類的智能。

現在,隨著最近的模型發布出現 到 凝滯,大多數研究人員受到調查人工智能發展協會相信科技公司已經到了死胡同 - 金錢不會使他們擺脫困境。

“我認為自GPT-4發行後不久以來就顯而易見了,從縮放收益是漸進且昂貴的,”斯圖爾特·羅素(Stuart Russell)加利福尼亞大學伯克利分校的計算機科學家幫助組織了報告。 “ [AI公司]已經投資了太多,並且無法承認他們犯了一個錯誤,並且當他們不得不償還投入數千億美元的投資者時,他們就會跌落了幾年。因此,他們所能做的就是翻倍。”

回報減少

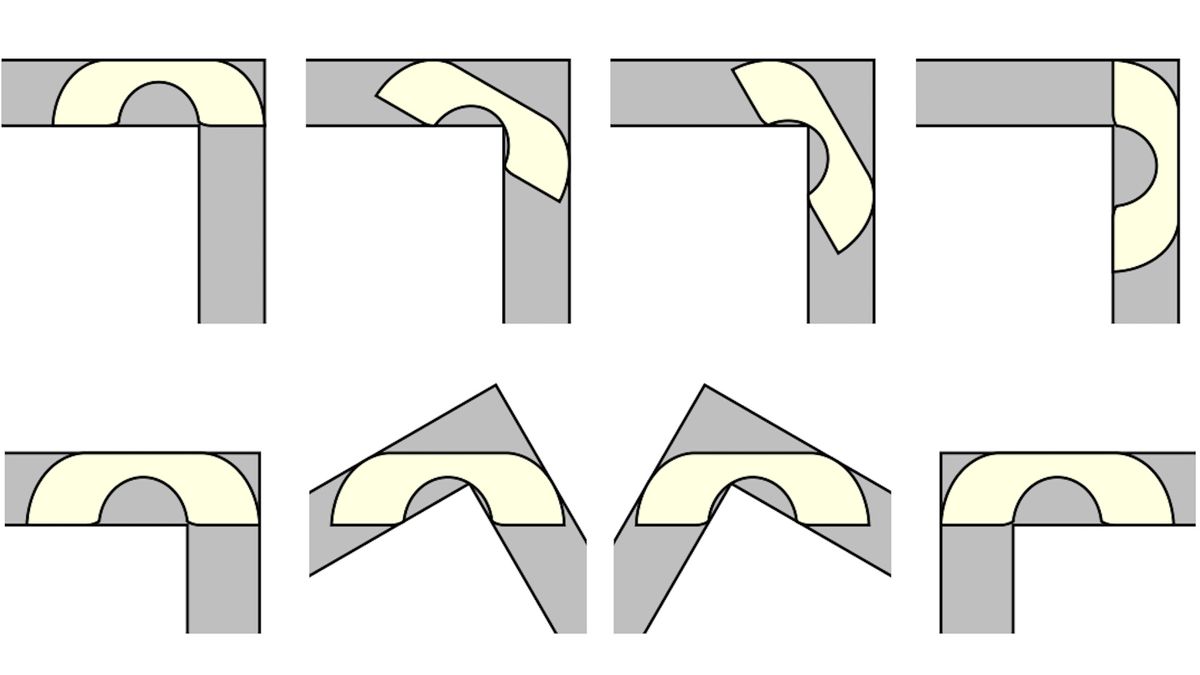

近年來,對LLM的驚人改進部分歸功於其基礎變壓器架構。這是一種深度學習體系結構,最初是由Google Scientist於2017年創建的,它通過吸收來自人類投入的培訓數據而增長和學習。

這使模型能夠從其神經網絡(機器學習算法的集合來模仿人腦學習的方式)中產生概率模式,並在給出提示時向前餵養牠們,並通過更多數據來提高其準確性的答案。

有關的:科學家設計了新的“ AGI基準”,該新“ AGI基準”表明未來的AI模型是否會造成“災難性傷害”

但是,這些模型的持續擴展需要吸引人的金錢和能源。生成的AI行業籌集了560億美元僅在2024年全球風險投資中自2018年以來增加了兩倍。

預測還表明,有限的人類生成的數據對於進一步的增長必不可少到這十年末。一旦發生這種情況,替代方案將是開始從用戶收集私人數據或將AI生成的“合成”數據饋回到模型中可能會使他們有崩潰的風險從吞下自己的輸入後創建的錯誤。

調查專家說,當前模型的局限性可能不僅是因為它們是渴望資源的,而且還因為其架構的根本局限性。

羅素說:“我認為當前方法的基本問題是,它們都涉及培訓大型前饋電路。” “電路具有基本的局限性作為表示概念的一種方式。這意味著電路必須巨大的代表以代表此類概念,即使是一張榮耀的查找表 - 這會導致巨大的數據要求和零散的差距表示。容易擊敗“超人” GO計劃。

AI發展的未來

所有這些瓶頸都為致力於提高AI績效的公司面臨著重大挑戰,從而在評估基準中取得了分數到 高原一些受訪者說,傳聞傳聞的GPT-5模型從未出現過。

中國公司DeepSeek今年也削弱了可以通過縮放進行改進的假設,該公司與硅谷昂貴的車型的性能相匹配成本和權力的一小部分。由於這些原因,調查的受訪者中有79%表示,對AI能力的看法與現實不符。

羅素說:“有許多專家認為這是一個泡沫。” “特別是當免費提供合理高性能模型時。”

但是,這並不意味著AI的進步已經死了。推理模型 - 專門的模型,這些模型將更多時間和計算能力用於查詢 - 已顯示出來產生更準確的響應比他們的傳統前輩。

受訪者說,這些模型與其他機器學習系統的配對,尤其是在將其蒸餾到專門的秤之後,這是一個令人興奮的途徑。 Deepseek的成功指出更多的工程創新空間在AI系統的設計中。專家還指出,概率編程具有比當前電路模型更接近AGI的潛力。

“行業正在大致下注,即生成AI的高價值應用,”托馬斯·迪特里奇(Thomas Dietterich)為該報告做出了貢獻的俄勒岡州立大學計算機科學名譽教授告訴Live Science。 “過去,大技術進步需要10到20年才能表現出巨大的回報。”

他補充說:“第一批公司通常會失敗,所以看到當今的許多Genai創業公司失敗了,我不會感到驚訝。” “但是似乎有些人可能會取得巨大的成功。我希望我知道哪些。”