不到兩週前,一家鮮為人知的中國公司發布了最新的(人工智能)模型並在世界範圍內引起了衝擊波。

DeepSeek 在一份上傳至的技術論文中聲稱GitHub其開放式重量 R1 模型實現了可比較或更好的結果比一些領先的矽谷巨頭製作的人工智能模型——即 OpenAI 的 ChatGPT、Meta 的 Llama 和 Anthropic 的 Claude。最令人驚訝的是,該模型以極低的成本進行訓練和運行,卻取得了這些結果。

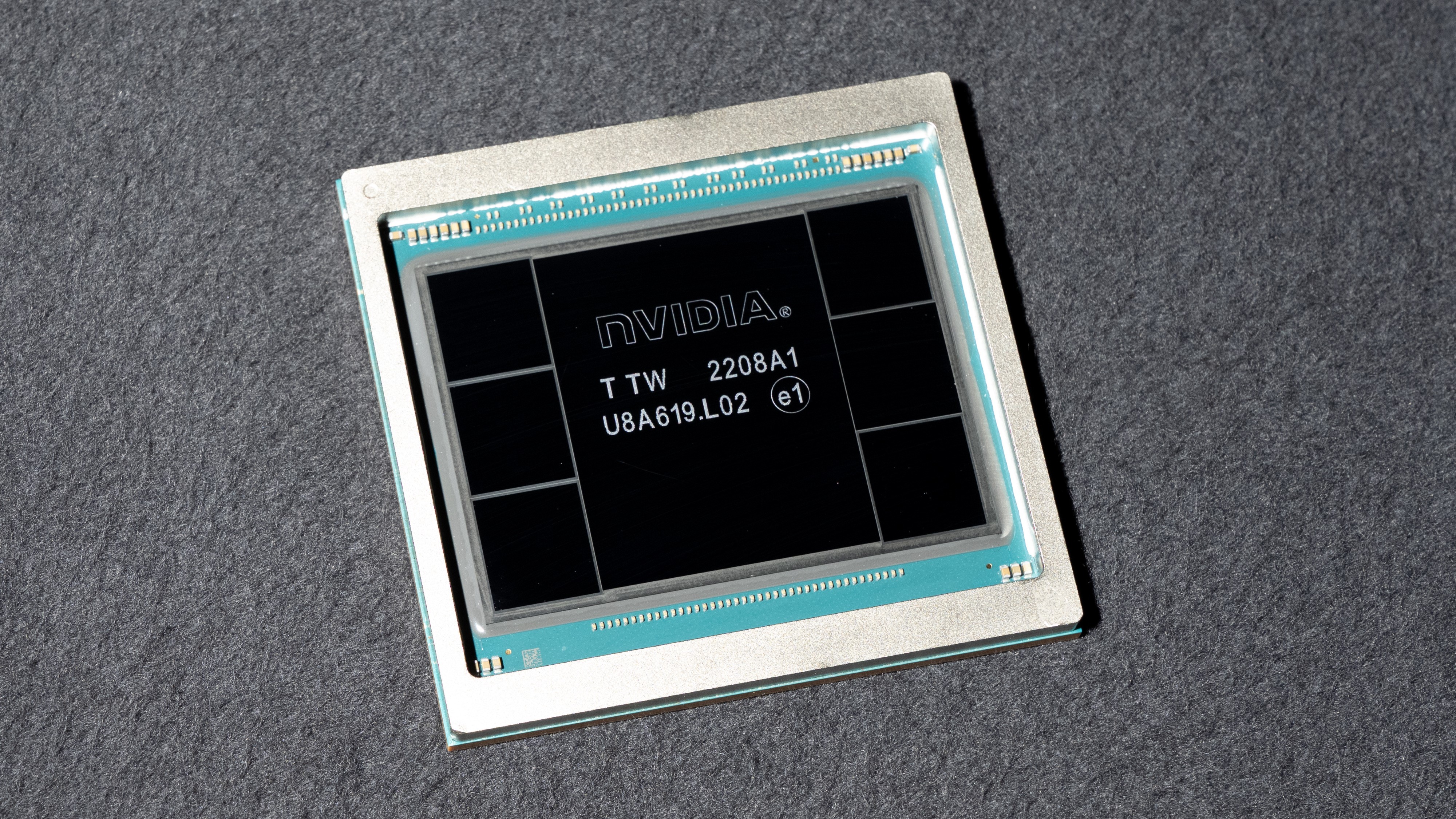

Nvidia 是一家生產被認為對 AI 訓練至關重要的高端 H100 圖形芯片的公司,該公司的估值損失了 5890 億美元。美國歷史上最大單日市場跌幅。畢竟,DeepSeek 表示,它在沒有它們的情況下訓練了人工智能模型——儘管它確實使用了性能較差的 Nvidia 芯片。美國科技公司的反應是恐慌和憤怒,OpenAI 代表甚至暗示 DeepSeek抄襲其模型的部分內容。

有關的:

人工智能專家表示,DeepSeek 的出現顛覆了支撐該行業增長方式的一個關鍵教條——表明越大並不總是越好。

“事實上,DeepSeek 可以用更少的錢、更少的計算和更少的時間構建,並且可以在更便宜的機器上本地運行,這一事實表明,隨著每個人都競相變得越來越大,我們錯過了構建更智能、更小型的機會,”克里斯蒂安·哈蒙德,西北大學計算機科學教授在一封電子郵件中告訴《生活科學》。

但是什麼讓 DeepSeek 的 V3 和 R1 模型如此具有顛覆性呢?科學家說,關鍵是效率。

是什麼讓 DeepSeek 的模型發揮作用?

“在某些方面,DeepSeek 的進步更多的是進化性而非革命性,”安布吉·特瓦里密歇根大學統計和計算機科學教授告訴《生活科學》。 “他們仍然在非常大的模型(數百億個參數)、非常大的數據集(數万億個代幣)和非常大的預算的主導範式下運行。”

Tewari 表示,如果我們從表面上看 DeepSeek 的說法,那麼該公司方法的主要創新在於它如何利用其龐大而強大的模型來運行與其他系統一樣好的運行,同時使用更少的資源。

其關鍵在於“專家混合”系統,該系統將 DeepSeek 的模型拆分為子模型,每個子模型專門處理特定的任務或數據類型。這伴隨著一個承載系統,它不像其他模型那樣應用整體懲罰來減慢負擔過重的系統,而是動態地將任務從過度工作的子模型轉移到工作不足的子模型。

“[這]意味著即使 V3 模型有 6710 億個參數,但任何給定代幣實際上只有 370 億個參數被激活,”Tewari 說。令牌是指大語言模型(LLM)中的處理單元,相當於一塊文本。

進一步實現這種負載平衡的是一種稱為“推理時間計算擴展”的技術,這是 DeepSeek 模型中的一個旋鈕,可以向上或向下調整分配的計算以匹配分配任務的複雜性。

這種效率延伸到了 DeepSeek 模型的訓練,專家將此視為美國出口限制的意外後果。由於對 Nvidia 最先進的 H100 芯片的訪問受到限制,因此 DeepSeek 聲稱它轉而使用 H800 芯片構建模型,而 H800 芯片的芯片間數據傳輸速率較低。 Nvidia 在 2023 年專門設計了這款“較弱”的芯片,以規避出口管制。

一種更高效的大型語言模型

使用這些功能較弱的芯片的需求迫使 DeepSeek 做出另一項重大突破:其混合精度框架。它沒有使用 32 位浮點數 (FP32) 來表示模型的所有權重(設置 AI 模型人工神經元之間連接強度的數字),而是使用不太精確的 8 位數字 (FP8) 來訓練模型的一部分,在精度很重要的情況下僅切換到 32 位以進行更困難的計算。

“這可以用更少的計算資源進行更快的訓練,”曹托馬斯塔夫茨大學技術政策教授告訴《生活科學》。 “DeepSeek 還改進了其訓練流程的幾乎每一步——數據加載、並行化策略和內存優化——從而在實踐中實現了非常高的效率。”

同樣,雖然使用人類提供的標籤來訓練 AI 模型來對答案和推理的準確性進行評分是很常見的,但 R1 的推理是無監督的。它僅使用數學和編碼等任務中最終答案的正確性作為其獎勵信號,從而釋放培訓資源以在其他地方使用。

所有這些加起來構成了一對效率驚人的模型。雖然 DeepSeek 競爭對手的培訓成本達到了數千萬至數億美元通常需要幾個月的時間,DeepSeek 代表表示該公司在兩個月內訓練了 V3僅售 558 萬美元。 DeepSeek V3 的運行成本同樣很低 —21次運行起來比Anthropic 的克勞德 3.5 十四行詩。

曹謹慎地指出,DeepSeek 的研發,包括其硬件和大量的試錯實驗,意味著幾乎可以肯定它的花費遠遠超過這個 558 萬美元的數字。儘管如此,成本的大幅下降仍然足以讓競爭對手措手不及。

總體而言,人工智能專家表示,DeepSeek 的流行可能對該行業產生積極的影響,降低過高的資源成本,並降低研究人員和公司的進入門檻。它還可以為比英偉達更多的芯片製造商創造參與競爭的空間。但它也有其自身的危險。

曹說:“隨著開發尖端人工智能模型的更便宜、更有效的方法變得公開,它們可以讓世界各地更多的研究人員追求尖端的法學碩士開發,從而有可能加速科學進步和應用程序創建。” “與此同時,這種較低的進入門檻帶來了新的監管挑戰——不僅僅是中美競爭——關於國家和非國家行為者濫用先進人工智能或潛在的不穩定影響。”