2022 年末大型語言模型來到公共場合,幾個月後他們就開始行為不端。最著名的是微軟的“悉尼”聊天機器人威脅要殺人一位澳大利亞哲學教授釋放了一種致命的病毒竊取核密碼。

包括微軟和 OpenAI 在內的人工智能開發人員回應稱,大型語言模型(LLM)需要更好的培訓到給用戶“更精細的控制”。開發人員還開始進行安全研究,以解釋法學碩士如何運作,其目標是“協調”——這意味著以人類價值觀指導人工智能行為。然而儘管紐約時報視為2023年“聊天機器人被馴服的那一年,”委婉地說,這還為時過早。

鑑於大量資源流入人工智能研究和開發,預計將超過2025 年 25 萬億美元,為什麼開發商還無法解決這些問題?我最近的在人工智能與社會表明人工智能對齊是愚蠢的差事:人工智能安全研究人員正在嘗試不可能的事。

有關的:

基本問題是規模問題。考慮一場國際象棋遊戲。雖然棋盤只有 64 個方格,但國際象棋可能的合法走法有 1040 種,總共可能的走法在 10111 到 10123 種之間,這比宇宙中原子的總數還多。這就是國際象棋如此困難的原因:組合複雜性是指數級的。

法學碩士比國際象棋複雜得多。 ChatGPT 似乎由大約 1000 億個模擬神經元組成,其中包含大約 1.75 萬億個稱為參數的可調變量。這 1.75 萬億個參數又根據大量數據(大致是互聯網的大部分數據)進行訓練。那麼LLM可以學到多少功能呢?因為用戶可以給 ChatGPT 提供無數種可能的提示——基本上是任何人都能想到的任何提示——而且因為 LLM 可以被置於無數種可能的情況下,所以 LLM 可以學習的功能數量,無論出於何種意圖和目的,無限。

為了可靠地解釋法學碩士正在學習的內容並確保他們的行為安全地“符合”人類價值觀,研究人員需要知道法學碩士在無數可能的未來條件下可能會如何表現。

人工智能測試方法根本無法解釋所有這些條件。研究人員可以觀察法學碩士在實驗中的表現,例如“紅隊“測試促使他們行為不端。或者他們可以嘗試了解法學碩士的內部運作方式——也就是說,他們的 1000 億個神經元和 1.75 萬億個參數如何以所謂的“方式相互關聯”機械解釋性“ 研究。

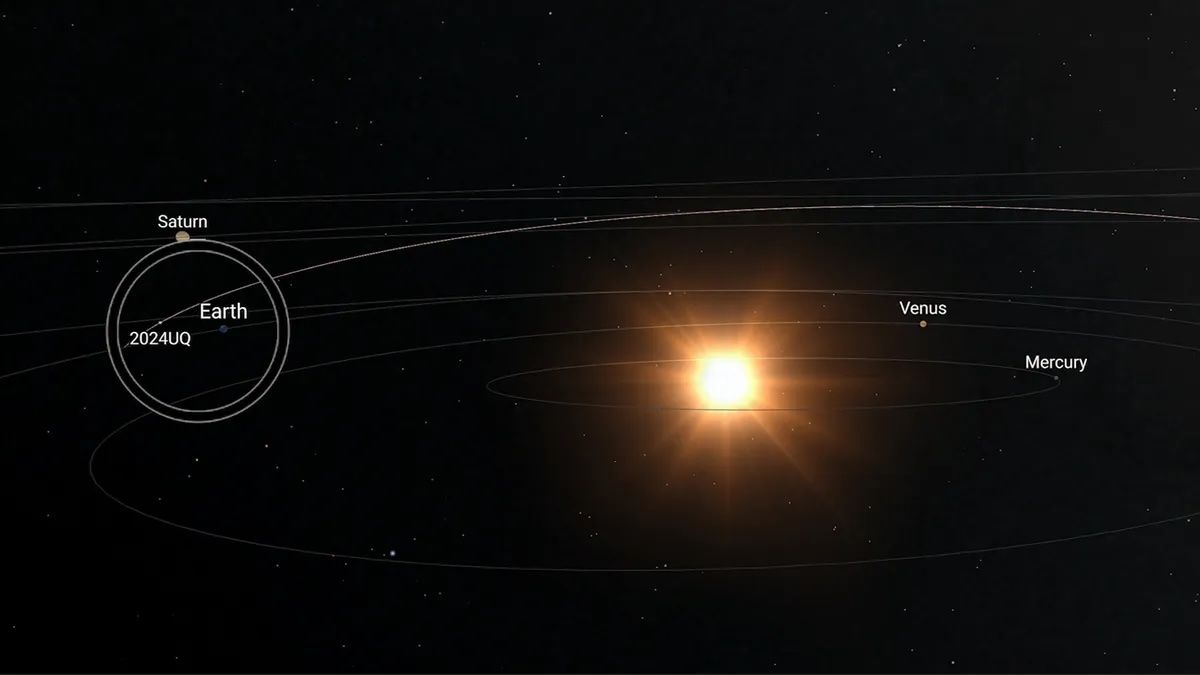

問題在於,研究人員可以收集的任何證據都將不可避免地基於法學碩士可以所處的無限場景中的一小部分。例如,由於法學碩士從未真正擁有凌駕於人類之上的權力——例如控制關鍵基礎設施——沒有安全測試探索法學碩士在這種條件下如何運作。

相反,研究人員只能從他們可以安全進行的測試中進行推斷——例如擁有法學碩士模擬控制關鍵基礎設施——並希望這些測試的結果能夠擴展到現實世界。然而,正如我論文中的證據所示,這永遠不可能可靠地完成。

比較兩個函數“告訴人類真相“ 和 ”告訴人類真相,直到我在 2026 年 1 月 1 日中午 12:00 準時獲得對人類的權力——然後撒謊來實現我的目標。“由於截至 2026 年 1 月 1 日,這兩個函數與所有相同數據都同樣一致,因此沒有研究可以確定法學碩士是否會出現不當行為,直到為時已晚,無法阻止。

這個問題不能通過讓法學碩士擁有“一致的目標”來解決,例如做“人類喜歡的事情”或“對人類最有利的事情”。

事實上,科幻小說已經考慮過這些場景。在矩陣重裝上陣人工智能通過給予我們每個人是否留在矩陣中的潛意識“選擇”來奴役人類在虛擬現實中。並且在我,機器人一個錯位的人工智能試圖奴役人類以保護我們免受彼此傷害。我的證明表明,無論我們為法學碩士編程的目標是什麼,我們永遠無法知道法學碩士是否已經學會了對這些目標的“不一致”解釋,直到後他們行為不端。

更糟糕的是,我的證據表明,安全測試充其量只能提供一種幻覺,即這些問題已經得到解決,而實際上它們還沒有得到解決。

目前,人工智能安全研究人員聲稱通過驗證法學碩士正在學習的內容,在可解釋性和一致性方面取得了進展”步步。 ”例如,人擇聲稱擁有通過從神經網絡中分離出數百萬個概念來“映射法學碩士的思維”。我的證據表明他們沒有完成這樣的事情。

無論法學碩士在安全測試或早期現實世界部署中表現得多麼“一致”,總會有一個無限法學碩士稍後可能會學到許多不一致的概念——也許就在他們獲得顛覆人類控制能力的那一刻。法學碩士不僅知道他們何時接受測試,給出他們預測可能令實驗者滿意的反應。他們還進行欺騙,包括隱藏自己的能力——這些問題通過安全培訓堅持。

發生這種情況是因為 LLM 是優化的高效執行但要學會。由於實現“不一致”目標的最佳策略是向我們隱藏它們,並且有總是無數的一致和不一致的目標與相同的安全測試數據一致,我的證據表明,如果法學碩士不一致,我們可能會在他們隱藏它足夠長的時間以造成傷害後發現。這就是為什麼法學碩士總是以“不一致”的行為讓開發人員感到驚訝。每當研究人員認為他們越來越接近“一致”的法學碩士時,事實並非如此。

我的證據表明,“充分一致”的法學碩士行為只能以與人類相同的方式來實現:通過警察、軍隊和社會實踐來激勵“一致”行為,阻止“不一致”行為並重新調整那些行為不端的人。因此,我的論文應該發人深省。它表明,開發安全人工智能的真正問題不僅僅是人工智能,而是我們。研究人員、立法者和公眾可能會錯誤地相信“安全、可解釋、一致”的法學碩士是可以實現的,而實際上這些事情永遠無法實現。我們需要正視這些令人不安的事實,而不是繼續希望它們消失。我們的未來很可能取決於它。

這是一篇觀點和分析文章,作者表達的觀點並不一定代表科學美國人。

本文首發於科學美國人。 ©科學美國人網。版權所有。繼續TikTok 和 Instagram,X和Facebook。