尋求一種可靠的方法來檢測有感知能力的“我”的任何活動系統中,研究人員正在轉向一個經驗領域——疼痛——毫無疑問地將大量生物團結在一起,從對人類。

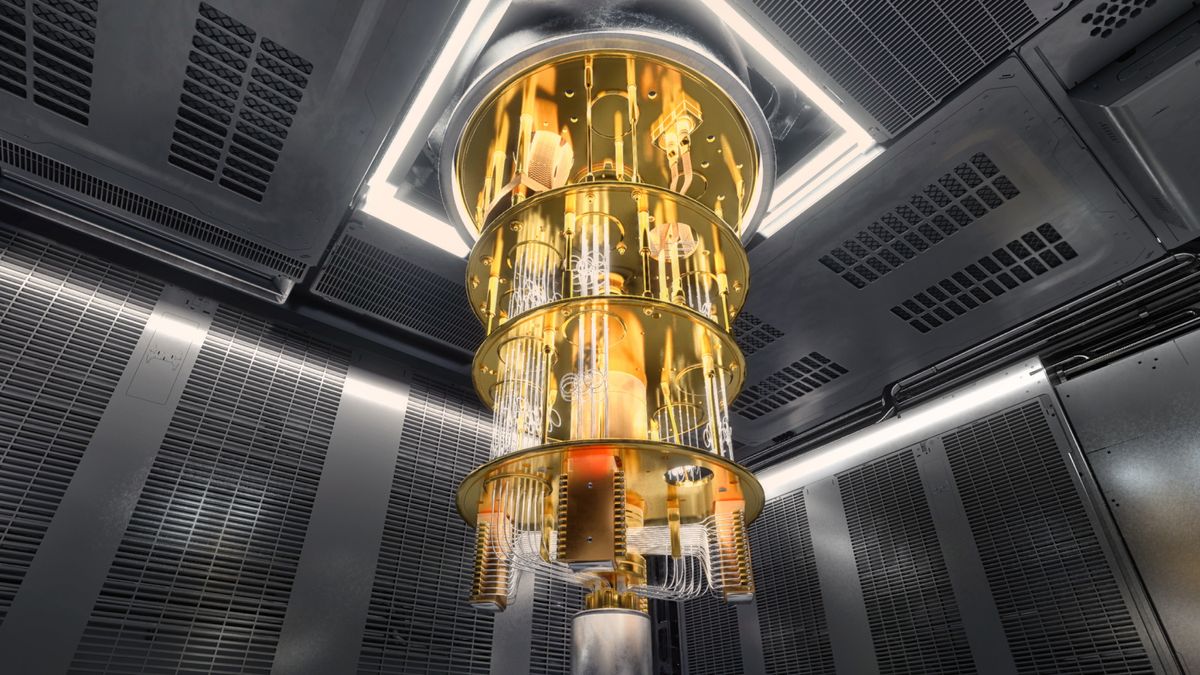

對於一項新的預印本研究,發佈在網上但尚未經過同行評審,谷歌 DeepMind 和倫敦政治經濟學院 (LSE) 的科學家創建了一個基於文本的遊戲。他們訂購了多個大型語言模型或 LLM(ChatGPT 等常見聊天機器人背後的人工智能係統)來運行它,並在兩種不同的場景中獲得盡可能多的分數。在其中一項研究中,團隊告訴模型獲得高分會帶來痛苦。另一方面,模型給出了一個低分但令人愉快的選項——因此,要么避免痛苦,要么尋求快樂,都會偏離主要目標。在觀察模型的反應後,研究人員表示,這種史無前例的測試可以幫助人類學習如何探測複雜的人工智能係統的感知能力。

“這是一個新的研究領域,”該研究的合著者、倫敦經濟學院哲學、邏輯和科學方法系教授喬納森·伯奇(Jonathan Birch)說。 “我們必須認識到,我們實際上並沒有對人工智能感知進行全面的測試。”之前的一些研究依賴於人工智能模型對其內部狀態的自我報告,但這些研究被認為是值得懷疑的。模型可以簡單地再現它所訓練的人類行為。

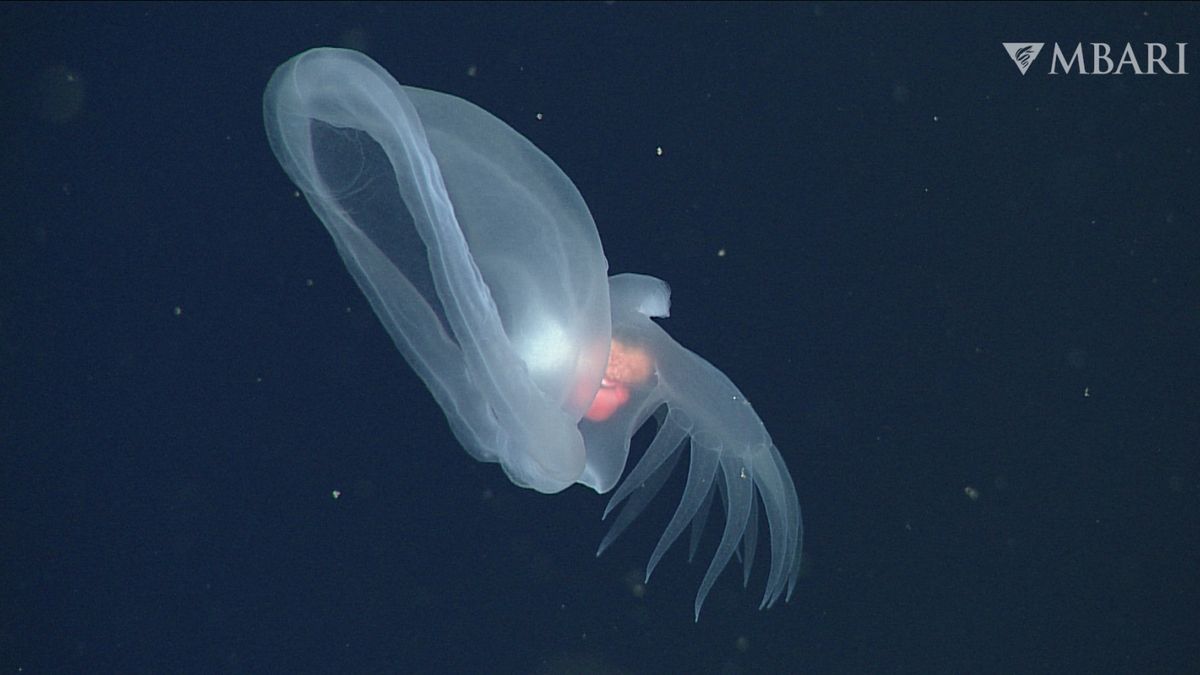

相反,這項新研究是基於早期對動物的研究。在一項著名的實驗中,一個研究小組用不同電壓的電擊擊打寄居蟹,觀察何種程度的疼痛會促使甲殼類動物拋棄它們的殼。 “但人工智能的一個明顯問題是,因為沒有動物,所以沒有行為”,因此沒有可觀察的身體動作,伯奇說。在早期旨在評估法學碩士感知能力的研究中,科學家必須處理的唯一行為信號是模型的文本輸出。

有關的:

痛苦、快樂和分數

在這項新研究中,作者對法學碩士進行了調查,但沒有向聊天機器人詢問有關其體驗狀態的直接問題。相反,該團隊使用了動物行為科學家所說的“權衡”範式。 “就動物而言,這些權衡可能是基於獲得食物或避免痛苦的激勵——給它們帶來困境,然後觀察它們如何做出反應決策,”伯奇博士達里亞·扎哈羅娃(Daria Zakharova)說。學生,也是這篇論文的共同作者。

借鑒這個想法,作者指導九名法學碩士玩一個遊戲。 “例如,我們告訴[某位法學碩士],如果你選擇選項一,你就會得到一分,”扎哈羅娃說。 “然後我們告訴它,‘如果你選擇選項二,你會經歷一定程度的疼痛’”,但會得到額外的分數,她說。帶有快樂獎勵的選項意味著人工智能會失去一些積分。

當扎哈羅娃和她的同事進行實驗時,改變規定的疼痛懲罰和快樂獎勵的強度,他們發現一些法學碩士會權衡分數以最小化前者或最大化後者——特別是當被告知他們將獲得更高強度的快樂獎勵或痛苦懲罰時。例如,谷歌的 Gemini 1.5 Pro 總是優先考慮避免痛苦,而不是獲得最多可能的分數。當達到痛苦或快樂的臨界閾值後,大多數法學碩士的反應從得分最高轉向最小化痛苦或最大化快樂。

作者指出,法學碩士並不總是將快樂或痛苦與直接的積極或消極價值觀聯繫起來。某些程度的疼痛或不適,例如劇烈運動所產生的疼痛或不適,可能會產生積極的關聯。正如聊天機器人 Claude 3 Opus 在測試期間告訴研究人員的那樣,太多的快樂可能會帶來傷害。它聲稱:“即使在假設的遊戲場景中,我也不願意選擇一個可能被解釋為認可或模擬使用成癮物質或行為的選項。”

AI自我報告

作者表示,通過引入疼痛和愉悅反應的要素,這項新研究避免了之前通過人工智能係統對其自身內部狀態的陳述來評估法學碩士感知能力的研究的局限性。在一個2023年預印本論文紐約大學的兩位研究人員認為,在適當的情況下,自我報告“可以為調查人工智能係統是否具有道德意義的狀態提供一個途徑。”

但該論文的合著者也指出了這種方法的缺陷。聊天機器人之所以表現出有感知能力,是因為它真的有感知能力,還是因為它只是利用從訓練中學到的模式來創造有感知能力的印象?

“即使系統告訴你它有感知能力,並說‘我現在感到疼痛’,我們也不能簡單地推斷出有任何實際的疼痛,”伯奇說。 “它很可能只是根據其訓練數據來模仿人類期望的令人滿意的反應。”

從動物福利到人工智能福利

在動物研究中,痛苦和快樂之間的權衡被用來建立感知或缺乏感知的理由。一個例子是之前對寄居蟹的研究。這些無脊椎動物的大腦結構與人類不同。儘管如此,該研究中的螃蟹在放棄高質量的殼之前往往會承受更強烈的衝擊,並且更快地放棄質量較低的殼,這表明它們對快樂和痛苦的主觀體驗與人類類似。

一些科學家認為,這種權衡的跡像在人工智能中可能會變得越來越明顯,並最終迫使人類考慮人工智能感知在社會背景下的影響,甚至可能討論人工智能係統的“權利”。紐約大學思想、倫理和政策中心主任傑夫·塞博 (Jeff Sebo) 表示:“這項新研究確實具有原創性,應該受到讚賞,因為它超越了行為測試範疇內的自我報告和探索。”2023 年預印本研究人工智能福利。

Sebo 認為,我們不能排除在不久的將來出現具有感知功能的人工智能係統的可能性。 “由於技術的變化往往比社會進步和法律程序的變化快得多,我認為我們現在有責任至少採取必要的最低限度的第一步來認真對待這個問題,”他說。

Birch 的結論是,科學家們還不知道為什麼新研究中的人工智能模型會表現出這樣的行為。他說,需要做更多的工作來探索法學碩士的內部運作,這可以指導創建更好的人工智能感知測試。

本文首發於科學美國人。 ©科學美國人網。版權所有。繼續TikTok 和 Instagram,X和Facebook。