Youtube

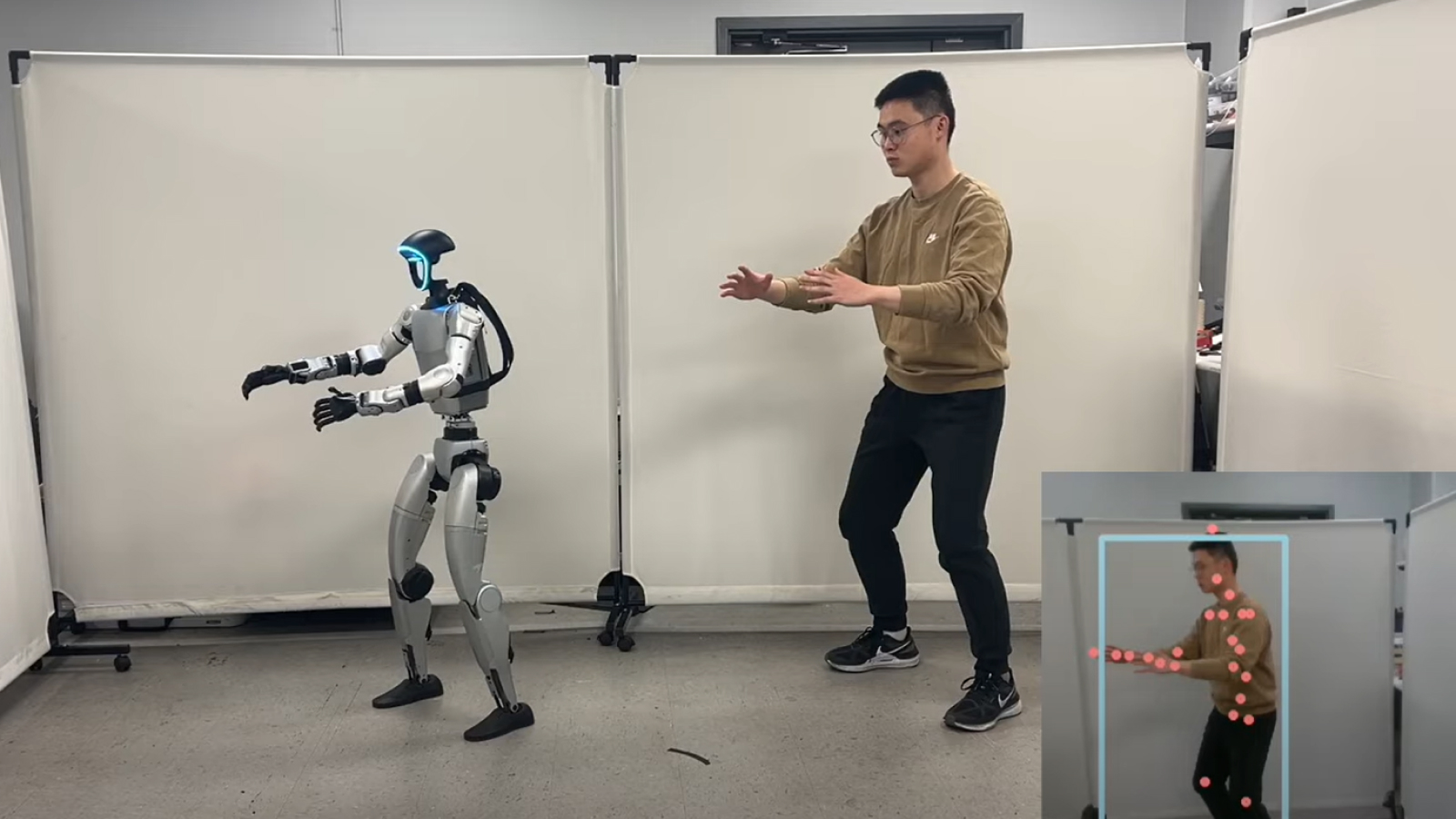

得益於用於跟踪人類運動的新軟件框架,人形機器人很快就能以更加真實的方式移動,甚至可以像我們一樣跳舞。

研究人員希望未來的人形機器人能夠通過更準確地模仿人類動作來執行更廣泛的任務。例如,教學方法可以幫助機器人執行需要精細動作的角色,例如從架子上檢索物品,或者在人類或其他機器周圍小心移動。

ExBody2 的工作原理是根據人類的動作捕捉掃描進行模擬動作,並將其轉換為可供機器人復制的可用動作數據。該框架可以使用機器人復制複雜的動作,這將使機器人的移動不那麼僵硬,無需進行大量的再訓練即可適應不同的任務。

有關的:

這一切都是通過強化學習來教授的,強化學習是機器學習的一個子集,其中機器人被輸入大量數據,以確保它在任何給定情況下採取最佳路線。研究人員模擬的良好輸出會被分配正分或負分,以“獎勵”模型以獲得理想的結果,這意味著在不影響機器人穩定性的情況下精確地複制動作。

該框架還可以拍攝短動作片段,例如幾秒鐘的舞蹈,並合成新的動作幀以供參考,使機器人能夠完成較長持續時間的動作。

與機器人共舞

在一個視頻發佈到 YouTube,一個經過 ExBody2 訓練的機器人與人類對像一起跳舞、打鬥和練習。此外,該機器人還使用上海交通大學機器視覺與智能小組開發的名為“HybrIK:用於身體網格恢復的混合分析神經逆運動學”的附加代碼來實時模仿研究人員的運動。

目前,ExBody2 的數據集主要集中於上半身運動。在一項研究中,於 2024 年 12 月 17 日上傳到預印本服務器ArXiv該框架背後的研究人員解釋說,這是因為擔心在機器人下半部分引入過多的運動會導致不穩定。

他們寫道:“過於簡單的任務可能會限制訓練策略推廣到新情況的能力,而過於復雜的任務可能會超出機器人的操作能力,導致無效的學習結果。” “因此,我們數據集準備的一部分包括排除或修改超出機器人能力的複雜下半身運動的條目。”

研究人員的數據集包含 2,800 多個動作,其中 1,919 個來自表面形狀運動捕捉檔案 (AMASS) 數據集。這是一個大型人體動作數據集,包括 11,000 多個人體動作和 40 小時的詳細動作數據,旨在用於非商業深度學習 - 當神經網絡接受大量數據訓練以識別或再現模式時。

證明了 ExBody2 在仿人機器人中復制類人運動的有效性後,該團隊現在將轉向實現這些結果的問題,而無需手動管理數據集以確保框架僅可使用合適的信息。研究人員建議,未來,自動化數據集收集將有助於平滑這一過程。