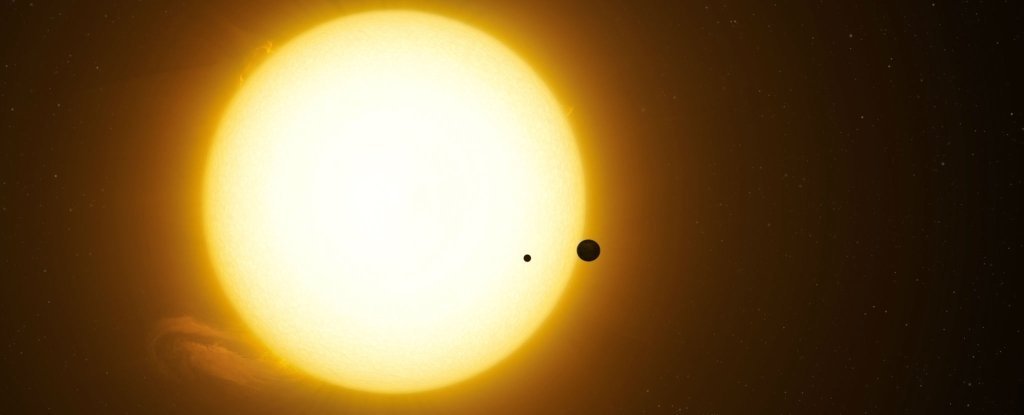

担心人类被迫逃离地球寻找新家园可能只是时间问题。

这位著名理论物理学家此前曾表示,他认为人类的生存将取决于我们的能力。

霍金在最近的一次采访中重申了——实际上是强调了——这一点。有线 他在其中指出,人类已经到了“无法回头的地步”。

霍金表示,为人类寻找第二个行星家园的必要性源于对人口增长的担忧以及人类发展所带来的迫在眉睫的威胁。(人工智能)。

他警告说,人工智能很快就会变得超级智能——有可能取代人类。

“精灵已经从瓶子里出来了。我担心人工智能可能会完全取代人类,”霍金告诉《连线》杂志。

这当然不是第一次霍金发出如此可怕的警告。 在三月份的采访中时代他表示,人工智能世界末日即将来临,有必要建立“某种形式的世界政府”来控制这项技术。

霍金也对影响提出警告人工智能将取代中产阶级工作,甚至呼吁彻底禁止开发用于军事用途的人工智能代理。

在这两种情况下,他的警告似乎基本上都被忽视了。 尽管如此,一些人仍认为智能机器已经取代了工作岗位,并且包括美国和俄罗斯在内的一些国家 -正在寻求某种人工智能武器供他们的军队使用。

近年来,人工智能发展已成为一个引起广泛争议的话题:一些专家提出了与霍金类似的论点,包括SpaceX 和特斯拉首席执行官兼创始人埃隆·马斯克和微软联合创始人比尔·盖茨。

马斯克和盖茨都认为人工智能的发展有可能导致人类灭亡。

另一方面,相当多名专家已经提出此类警告是不必要的恐慌,这可能是基于他们担心的牵强的超级智能人工智能接管场景扭曲公众对人工智能的看法。

就霍金而言,这种担忧是有道理的。

“如果人们设计计算机,有人会设计出能够自我改进和复制的人工智能。”霍金在接受采访时说道。有线。

“这将是一种超越人类的新生命形式。”

霍金似乎指的是人工智能的发展,它足够聪明,能够思考,甚至比人类更好——这一事件被称为技术奇点。

至于何时会发生(如果有的话),霍金没有提供确切的时间表。 我们可以假设它会在霍金为人类在地球上生存规定的 100 年最后期限内的某个时刻到来。

其他人,例如软银首席执行官孙正义和谷歌首席工程师雷·库兹韦尔,则将奇点出现的时间框架定得更早——在未来 30 年内。

我们还有很长的路要走开发真正智能的人工智能,而且我们还不知道奇点会带来什么。

它会预示着人类的灭亡,还是会开启人类与机器共存的新时代?

在任一情况下,人工智能的潜力既有好的一面也有坏的一面要求我们采取必要的预防措施。