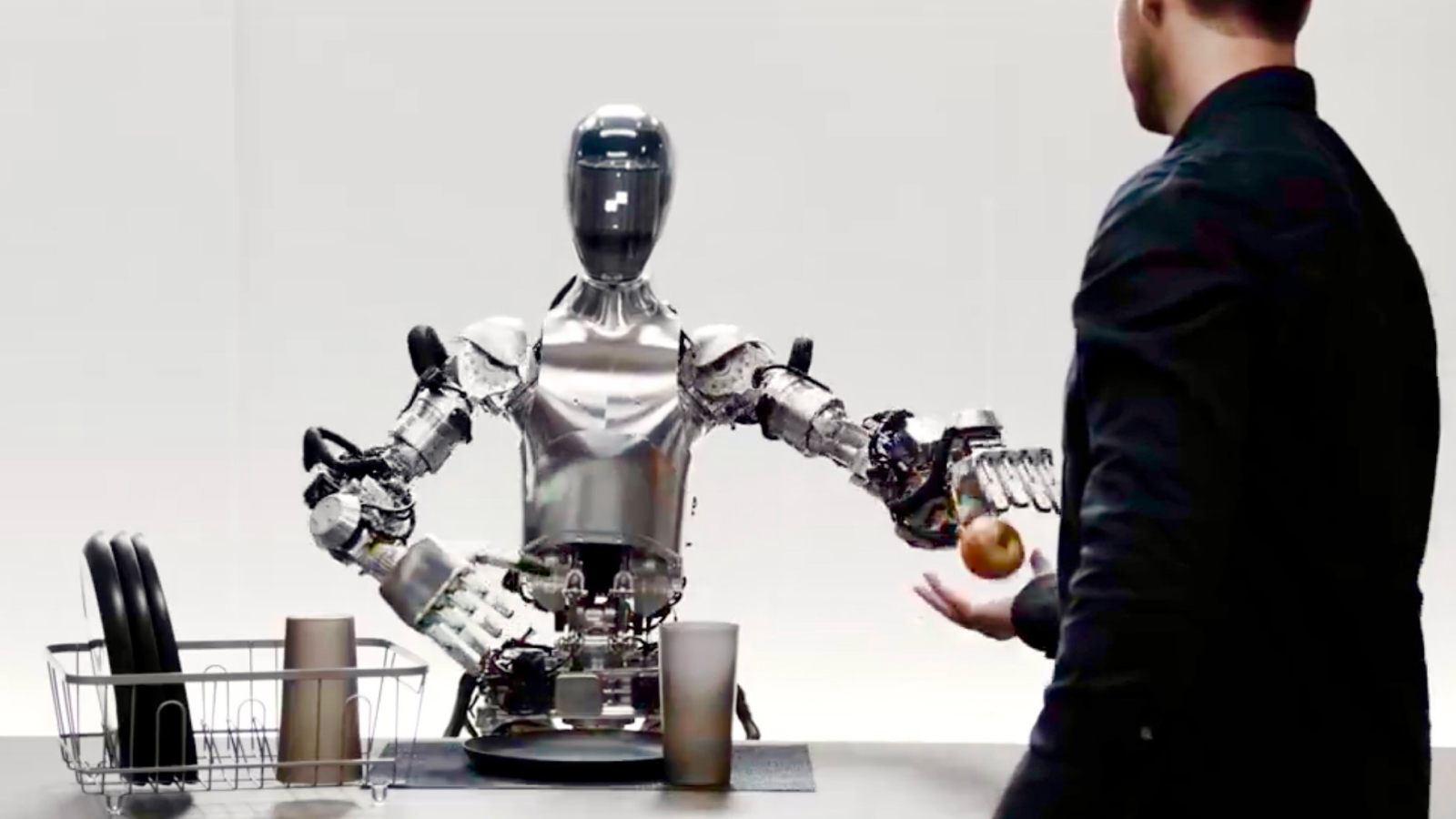

一种自我纠正的人形机器人,学会了仅通过观看镜头来煮一杯咖啡由于与OpenAI的技术集成,现在可以这样做的人可以回答问题。

在新的促销视频,技术人员要求图01在类似于厨房的简约测试环境中执行一系列简单任务。他首先要求机器人吃点东西,然后递给苹果。接下来,他要求图01解释为什么它在拿起一些垃圾时递给他一个苹果。机器人以机器人但友好的声音回答了所有问题。

有关的:观看科学家在佩戴Apple Vision Pro时用手控制机器人

该公司在视频中说,对话是由与OpenAI制作的技术集成的(Chatgpt背后的名称)为动力提供的。但是,图01不太可能使用chatgpt本身,因为AI工具通常不会使用该机器人这样的暂停单词。

使用OpenAI,图01现在可以与Openai模型进行完整的对话,可提供高级的视觉和语言智能数字神经网络,在此视频中提供快速,低级,灵活的机器人动作,是一个神经网络:pic.twitter.com/ojzmjcv4434434434434434434432024年3月13日

如果视频中的所有内容都按声称的工作,这意味着在两个关键的机器人技术领域的进步。正如专家们先前告诉《现场科学》(Live Science)的那样,第一个进步是像人们所能执行的那样灵巧,自我校正的动作背后的机械工程。这意味着受关节或肌肉启发的非常精确的电动机,执行器和握手,以及电动机控制以操纵它们以执行任务并精心固定物体。

即使拿起一个杯子(人们几乎没有意识到的东西)使用大量的板载处理来精确地定向肌肉。

第二个进步是实时自然语言处理(NLP),这要归功于Openai的引擎的添加 - 当您键入查询时,它必须像Chatgpt一样直接和响应。它还需要软件将这些数据转换为音频或语音。 NLP是一个计算机科学领域,旨在使机器能够理解和传达语音。

尽管录像看起来令人印象深刻,但到目前为止,Livescience.com持怀疑态度。在0.52s且在1.49时再次聆听,当图01开始用快速的“ uh”开始句子,然后重复“我”一词,就像一个人分开一秒钟的人来获得她的想法来说话。为什么(以及如何)AI语音引擎将包括这种随机的,类人类的词典?总体而言,这种拐点也是可疑的不完美的,就像人类在言语中使用的自然无意识的节奏一样。

我们怀疑实际上可能会预先录制它是为了展示Figure Robotics正在从事的工作,而不是现场现场测试,但是如果(如视频字幕所主张的那样),一切确实是神经网络的结果,并且真正显示了图01实时响应,我们刚刚向未来迈出了另一个巨大的飞跃。