五分之一的英國醫生使用生成式(GenAI) 工具——例如 OpenAI 的 ChatGPT 或谷歌的 Gemini——來協助臨床實踐。這是根據一個最近的調查約 1,000 名全科醫生。

醫生報告稱,他們使用 GenAI 在預約後生成文檔,幫助做出臨床決策並向患者提供信息,例如易於理解的出院摘要和治療計劃。

考慮到圍繞人工智慧的炒作以及衛生系統面臨的挑戰,醫生和政策制定者都將人工智慧視為現代化和衛生系統的關鍵也就不足為奇了。改變我們的醫療服務。

但 GenAI 是一項最新的創新,它從根本上挑戰了我們對病人安全的看法。我們還有很多需要知道在 GenAI 可以安全地用於日常臨床實踐之前。

GenAI 的問題

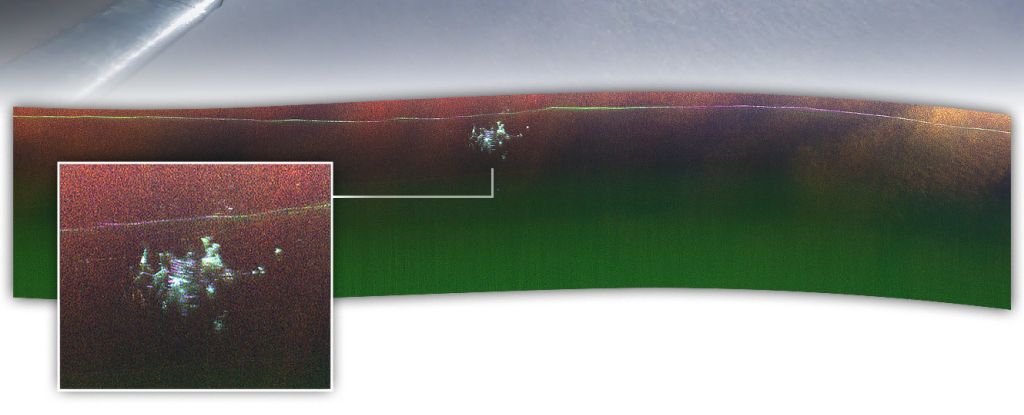

傳統上,人工智慧應用程式是為了執行非常具體的任務而開發的。例如,深度學習神經網路已用於成像和診斷中的分類。事實證明,此類系統可有效分析乳房 X 光照片,以幫助乳癌篩檢。

但 GenAI 並未接受過執行狹義任務的訓練。這些技術是基於所謂的基礎模型,具有通用功能。這意味著它們可以生成文字、像素、音訊甚至這些的組合。

然後,針對不同的應用程式對這些功能進行微調,例如回答使用者查詢、產生程式碼或建立圖像。與此類人工智慧互動的可能性似乎僅受用戶想像力的限制。

至關重要的是,由於該技術尚未開發用於特定環境或用於特定目的,因此我們實際上不知道醫生如何安全地使用它。這只是 GenAI 尚不適合在醫療保健領域廣泛使用的原因之一。

在醫療保健中使用 GenAI 的另一個問題是有據可查的現象的「幻覺」。幻覺是基於已提供的輸入的無意義或不真實的輸出。

幻覺是在 GenAI 創建文本摘要的背景下進行研究的。一項研究發現各種 GenAI 工具產生的輸出根據文本中的內容創建了錯誤的鏈接,或者摘要中包含文本中甚至未提及的資訊。

幻覺的出現是因為 GenAI 的工作原理是可能性原則(例如預測在給定上下文中將出現哪個單字),而不是基於人類意義上的「理解」。這意味著 GenAI 產生的輸出是看似合理但不一定真實。

這種合理性是在常規醫療實踐中安全使用 GenAI 為時過早的另一個原因。

想像 GenAI 工具可以監聽病人的諮詢,然後產生電子摘要記錄。一方面,這使全科醫生或護士能夠騰出時間更好地與患者互動。但另一方面,GenAI 可能會根據它認為合理的內容產生註釋。

例如,GenAI 摘要可能會改變患者症狀的頻率或嚴重程度,增加患者從未抱怨過的症狀或包含患者或醫生從未提及的資訊。

醫生和護士需要對人工智慧生成的任何筆記進行敏銳的校對,並擁有出色的記憶力來區分事實資訊和看似合理但虛構的資訊。

這在傳統的家庭醫生環境中可能沒問題,因為全科醫生非常了解患者,可以辨識不準確的地方。但在我們支離破碎的衛生系統由於患者經常由不同的醫護人員接診,患者記錄中的任何不準確都可能對其健康造成重大風險,包括延誤、治療不當和誤診。

與幻覺相關的風險是巨大的。但值得注意的是,研究人員和開發人員目前正在努力減少產生幻覺的可能性。

病人安全

在醫療保健領域使用 GenAI 還為時過早的另一個原因是患者安全取決於相互作用與人工智慧一起確定它在特定背景和環境中的運作情況——研究技術如何與人合作,它如何適應更大的衛生系統內的規則和壓力以及文化和優先事項。這樣的系統視角將確定 GenAI 的使用是否安全。

但由於 GenAI 並不是為特定用途而設計的,這意味著它具有適應性,並且可以以我們無法完全預測的方式使用。除此之外,開發人員定期更新他們的技術,並添加新的通用功能改變行為GenAI 應用程式的一部分。

此外,即使技術看起來安全且按預期運行,也可能會造成傷害——同樣,這取決於使用環境。

例如,引入 GenAI 對話代理進行分診可能會影響不同患者參與醫療保健系統的意願。數位素養較低的患者、第一語言不是英語的患者以及非語言患者可能會發現 GenAI 難以使用。因此,雖然該技術原則上可能“有效”,但如果該技術不能平等地為所有用戶工作,這仍然可能造成傷害。

這裡的重點是,透過傳統的安全分析方法很難預先預測 GenAI 的此類風險。這些涉及了解技術失敗如何可能會造成傷害在特定的背景下。醫療保健可以受益匪淺得益於 GenAI 和其他人工智慧工具的採用。

但在這些技術能夠更廣泛地應用於醫療保健之前,安全保證和監管需要對這些技術的使用地點和方式的發展做出更敏感的反應。

GenAI 工具的開發人員和監管機構也有必要與...一起工作社區使用這些技術來開發可以在臨床實踐中定期、安全地使用的工具。![]()