對於失去說話能力的人來說,有了新的希望。

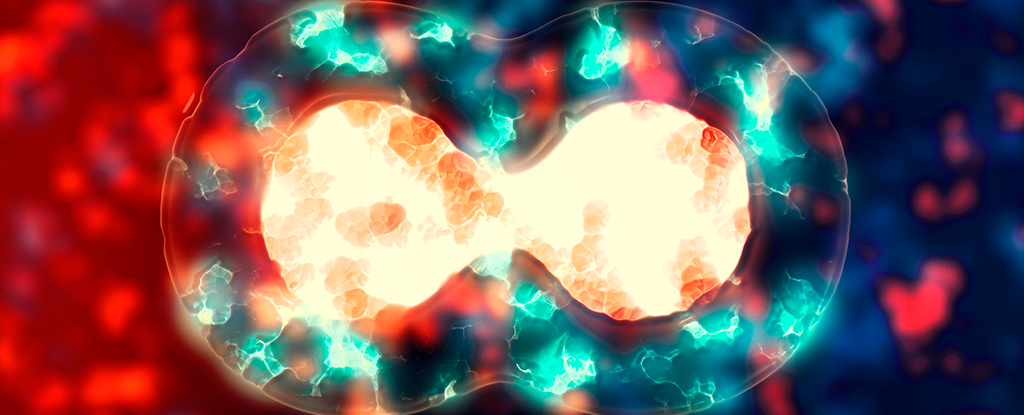

在兩個不同的案例中,科學家們成功地使用了大腦植入物機器學習在患者失聲後恢復其聲音; 一個是中風,一個是肌萎縮側索硬化症(如果)。 總之,這些結果代表了為癱瘓患者提供與周圍世界溝通的新方式的希望。

“我希望病人……看到我並知道他們的生命還沒有結束,”安寫道2005 年中風後經歷了閉鎖綜合症。

近年來,腦介面技術取得了長足的進步,但它並不是萬能的解決方案。

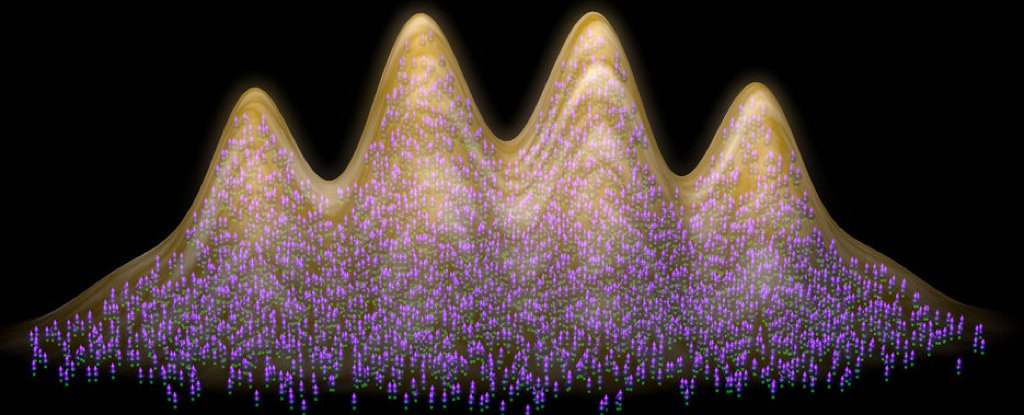

電極用於記錄一個人在考慮執行特定任務或動作時的神經活動。 然後,這些錄音用於訓練硬體或軟體來執行該任務; 例如,義肢當有人想要彎曲手臂時,它會彎曲。

然而,每個人的大腦活動都不同,因此必須為每個患者重新訓練機器來解碼他們的神經訊號。 考慮到語言本身非常複雜,完成大腦介面絕非易事,或者神經假體,可以將一個人的想法轉化為口語。

加州大學舊金山分校的神經外科醫生愛德華·張(Edward Chang)和他的同事負責恢復安的言語,而史丹佛大學的神經科學家弗蘭克·威利特(Frank Willett)和他的同事則為因運動神經元疾病ALS而失去說話能力的帕特·貝內特(Pat Bennett)恢復了言語; 同樣的情況也影響了已故物理學家,史蒂芬·霍金。

“想像,”貝內特寫道”,“當非語言的人能夠實時交流他們的想法時,購物、赴約、點餐、去銀行、打電話、表達愛或感激——甚至爭論——等日常活動將會有多麼不同。

兩個團隊都採用了類似的方法。 電極陣列被植入每位患者的大腦中——Bennett 的大腦中植入了 128 個電極,Ann 的大腦中植入了 253 個電極。

然後,他們每個人都經歷了思考說出不同單字和句子的艱苦過程。

安的曲目有 1,024 個單詞,但她也考慮過製作面部表情。 此外,人工智慧接受的訓練不是識別單詞,而是識別音素——構成單字的基本聲音單位。 這大大減少了人工智慧需要理解的單元數量。

團隊利用這些數據以及安中風前的演講錄音,創建了一個用她的聲音說話的虛擬化身。

最終,透過她的化身,安幾乎能夠與周圍的人一樣快地進行交流。

“當我在康復醫院時,言語治療師不知道該怎麼對待我,”她寫道。 「參與這項研究給了我一種目標感,我覺得我正在為社會做出貢獻。感覺就像我又找到了一份工作。我活了這麼久真是太棒了;這項研究讓我真正地生活了我還活著!

另一方面,Bennett 接受了大約 100 小時的訓練,訓練也是基於音素,重複從大型資料集中隨機選擇的句子。 經過這次訓練後,系統在 50 個單字的詞彙量上的錯誤率僅為 9.1%,Bennett 的語音解碼速度約為每分鐘 62 個單字。

125,000 個單字的詞彙量的錯誤率為 23.8%,但研究人員指出,這是第一次使用此類技術測試如此大的詞彙量。 所有人都同意,結果非常有希望。

“這些初步結果證明了這個概念,最終技術將迎頭趕上,讓不會說話的人也能輕鬆使用它,”貝內特寫道。

「對於那些不會說話的人來說,這意味著他們可以與更大的世界保持聯繫,也許可以繼續工作,維持朋友和家庭關係。”