只有透過吞噬大量的圖像、文字或其他形式的人類表達,生成式人工智慧模型可以炮製出他們自己的邊緣不可思議的解釋。

當靈感儲藏室變得空無一物時? 就像少數被困的水手一樣,人工智慧只能依靠自己來獲得經過嚴格處理的數位營養來源; 這個選擇可能會帶來一些相當令人擔憂的後果。

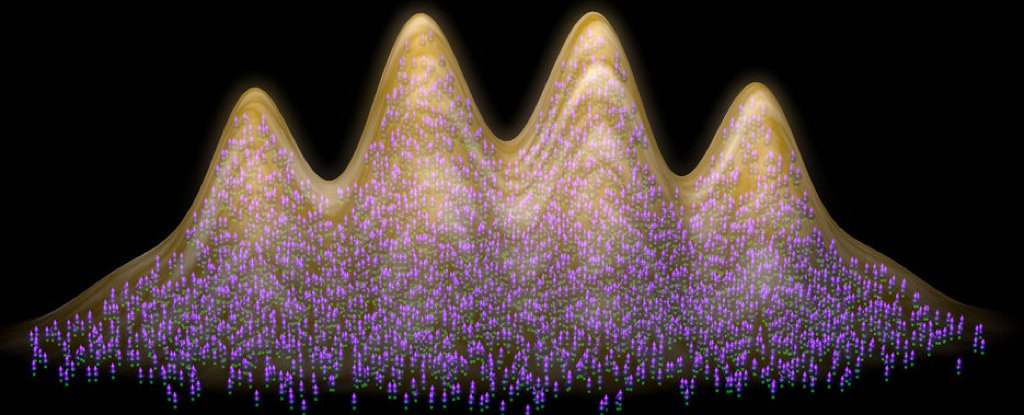

美國萊斯大學和史丹佛大學的研究人員進行的一項新研究提供了證據,表明當人工智慧引擎接受合成的機器輸入而不是真人生成的文字和圖像的訓練時,其輸出的品質開始受到影響。

研究者將這種效應模型稱為自噬混亂(瘋狂)。 人工智慧有效地消耗了自己,這意味著有相似之處瘋牛症– 用其他牛的受感染遺骸餵養的牛出現神經系統疾病。

研究表明,如果沒有新鮮的真實數據,人工智慧生成的內容的品質水準和/或多樣性水準都會下降。 這是對未來的警告AI 坡度從這些模型中。

“我們的理論和實證分析使我們能夠推斷出隨著生成模型變得無處不在並在自我消耗循環中訓練未來模型可能會發生什麼,”說萊斯大學的電腦工程師理查德‧巴拉尼克 (Richard Baraniuk)。

“一些後果是顯而易見的:如果沒有足夠的新鮮真實數據,未來的生成模型注定會變得瘋狂。”

Baraniuk 和他的同事與視覺生成AI模型,在三種不同類型的資料上進行訓練:完全合成、與固定的真實訓練資料混合的合成以及與不斷刷新的真實訓練資料的合成混合。

隨著前兩個場景中循環的重複,模型的輸出變得越來越扭曲。 表現出來的一種方式是透過更明顯的偽影,以網格狀疤痕的形式出現在電腦生成的臉孔。

更重要的是,當不涉及新鮮的、人工生成的訓練資料時,這些臉孔開始看起來越來越相似。 在使用手寫數字的測驗中,數字逐漸變得難以辨認。

如果使用真實數據,但以固定方式使用而不添加新數據,輸出的品質仍然會下降,只是需要更長的時間才能分解。 看來新鮮度很重要。

“我們的團隊在這種反饋循環方面進行了廣泛的研究,壞消息是,即使經過幾代這樣的訓練,新模型也可能會變得無法挽回地損壞,”說巴拉紐克。

團隊表示,雖然這項特定研究的重點是影像生成大型語言模型旨在生成文本的法學碩士(LLM)也會以同樣的方式失敗。 這確實已經被注意到其他研究。

專家有已經警告過生成式人工智慧工具已經沒有足夠的數據來訓練自己了——而這項最新研究是對人工智慧炒作的另一個檢驗。 這無疑是一項很有前景的技術,但它也有其局限性。

“一種末日情景是,如果幾代人都不受控制,MAD 可能會毒害整個互聯網的數據質量和多樣性,”說巴拉紐克。

“如果做不到這一點,即使在短期內,人工智慧自噬也將不可避免地產生迄今為止未見的意想不到的後果。”