谷歌宣布再次大力推进人工智能,揭示了一种新方法机器学习在哪里神经网络用于构建更好的神经网络——本质上是教人工智能自学。

这些人工神经网络旨在模仿大脑的学习方式,谷歌表示,其名为 AutoML 的新技术可以开发更强大、更高效且易于使用的网络。

谷歌首席执行官桑达尔·皮查伊 (Sundar Pichai) 本周在 Google I/O 2017 的舞台上展示了 AutoML,这是谷歌为应用程序员和硬件制造商举办的年度开发者大会,旨在揭示其产品的下一步发展方向。

“它的工作方式是,我们采用一组候选神经网络,将它们视为小神经网络,然后我们实际上使用神经网络来迭代它们,直到达到最佳神经网络,”皮查伊解释道。

这个过程称为强化学习,计算机可以将尝试和错误与某种奖励联系起来,就像教狗新把戏一样。

这需要大量的计算能力才能完成,但谷歌的硬件现在已经达到了一个神经网络可以分析另一个神经网络的阶段。

神经网络通常需要由科学家和工程师组成的专家团队花费大量时间才能完成,但借助 AutoML,几乎任何人都可以构建人工智能系统来处理他们喜欢的任何任务。

“我们希望 AutoML 能够具备当今少数博士所具备的能力,并使数十万开发人员能够在三到五年内为他们的特殊需求设计新的神经网络,”皮查伊在博客文章中写道。

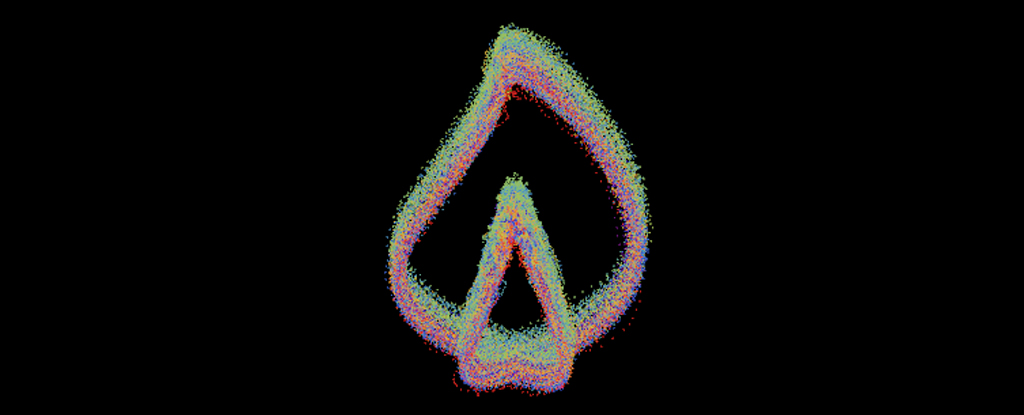

一个神经网络选择其他神经网络。 信用:谷歌

一个神经网络选择其他神经网络。 信用:谷歌

机器学习——让计算机根据样本数据做出自己的决策——是开发人工智能的一种方法,涉及两个主要步骤:训练和推理。

训练正是如此,因此它可能需要计算机查看数千张猫和狗的照片,以了解每种动物的像素组合类型。 推理部分是系统利用所学到的知识做出自己有根据的猜测的部分。

用神经网络代替猫和狗,您就会了解 AutoML 的工作原理,但它不是识别动物,而是识别哪些系统最聪明。

基于Google 看到的结果,AutoML 在识别解决问题的最佳方法方面可能比人类专家更聪明。 这可能会在构建未来人工智能系统的过程中节省大量工作,因为它们可以部分自行构建。

谷歌表示,AutoML 仍处于早期阶段,但人工智能、机器学习和深度学习(旨在模仿大脑神经元的先进机器学习技术)都在进入我们日常使用的应用程序。

在 I/O 舞台上的演示中,谷歌展示了其机器学习技术如何使黑暗图片变亮或消除图像中的障碍物,所有这些都基于从数百万个其他样本快照中获得的训练。

谷歌表示,它的计算机现在比人类更能识别照片中的内容。 即将推出的一款名为 Google Lens 的应用程序将能够通过手机的摄像头为您识别鲜花或街道上的商家。

这些超强大的深度学习算法也正在进入健康领域,在该领域,图像处理系统可以认识癌症的迹象比专业人士更准确。

在 AutoML 的帮助下,我们的 AI 平台应该更快地变得更加智能,尽管您可能需要一段时间才能看到 Android 相机应用程序的优势。 在此之前,应用程序开发人员和科学家将能够利用 AutoML。

正如谷歌研究科学家Quoc Le 和 Barret Zoph 解释道:“我们认为这可以激发新型神经网络的诞生,并使非专家能够创建适合其特定需求的神经网络,从而使机器学习对每个人产生更大的影响。 ”