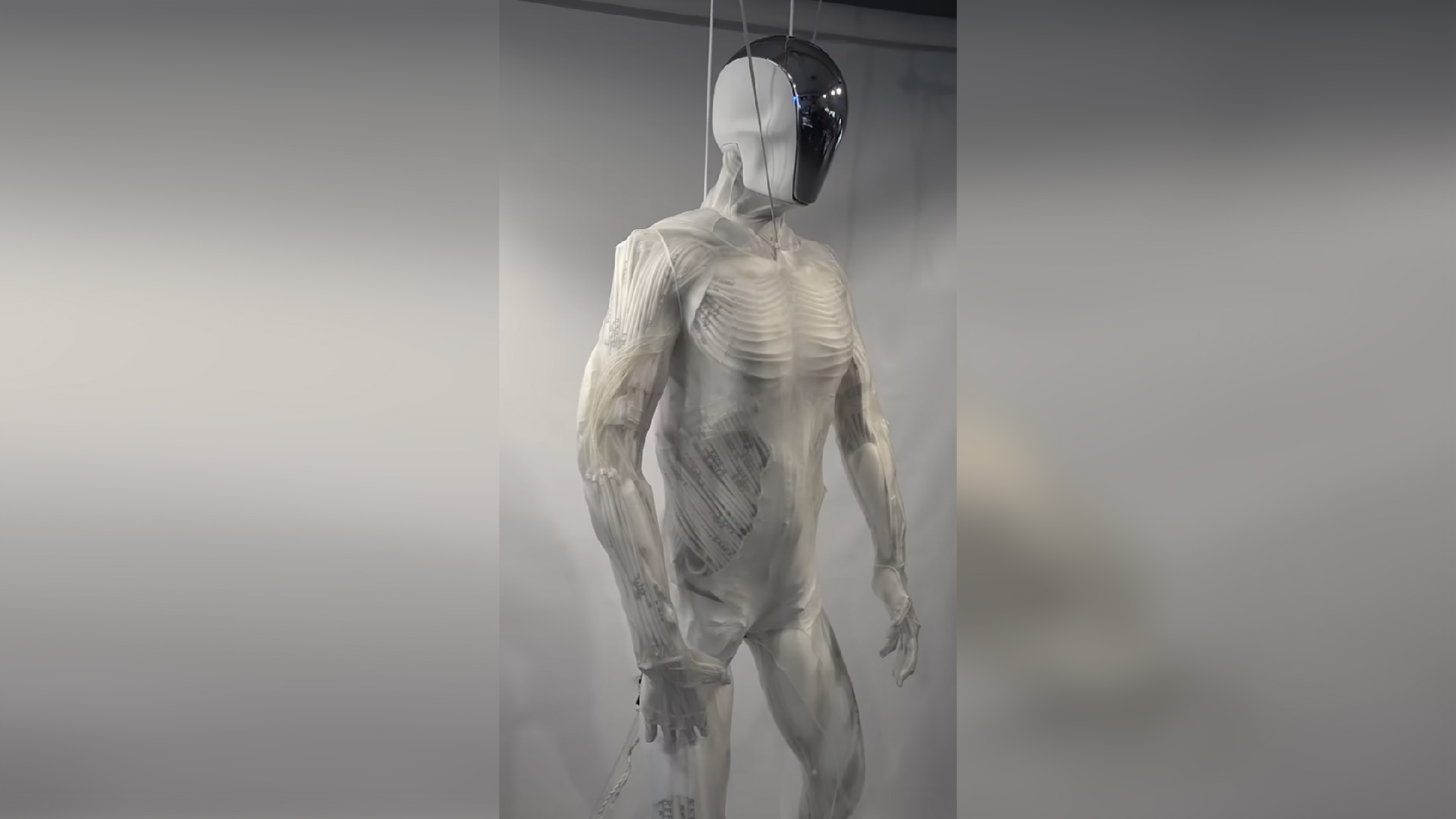

通过检查一个人的大脑活动,人工智能(AI)可以产生与个人最近听到的音乐类型,节奏,情绪和乐器相匹配的歌曲。

科学家以前已经从大脑活动中“重建”了其他声音,例如人类的言论,鸟儿和马的抱怨。但是,很少有研究试图从大脑信号中重新创建音乐。

现在,研究人员已经建立了一条名为Brain2Music的基于AI的管道,该管道利用大脑成像数据生成音乐,类似于一个人在扫描大脑时正在听的简短片段。他们在7月20日发布给预印度数据库的论文中描述了该管道arxiv,尚未经过同行评审。

科学家使用了以前通过一种称为功能磁共振成像(fMRI)的技术收集的脑扫描,该技术跟踪富含氧气的血液向大脑的流动,以查看哪些区域最活跃。这些扫描是从五名参与者那里收集的,他们听了15秒的音乐剪辑,这些剪辑涉及一系列流派,包括布鲁斯,古典,乡村,迪斯科,嘻哈,爵士和流行音乐。

研究人员使用一部分大脑成像数据和歌曲剪辑,首先培训了一个AI程序,以查找音乐功能之间的联系,包括所使用的乐器及其类型,节奏和情绪,以及参与者的大脑信号。音乐的心情是由研究人员使用诸如快乐,悲伤,温柔,令人兴奋,愤怒或恐怖的标签来定义的。

AI是为每个人定制的,在其独特的大脑活动模式和各种音乐元素之间绘制了联系。

在接受了一些数据选择的培训后,AI可以将剩余的,以前看不见的大脑成像数据转换为代表原始歌曲剪辑的音乐元素的形式。然后,研究人员将此信息提供给了先前由Google开发的另一种AI模型,称为Musiclm。 Musiclm最初是为了从文本描述中产生音乐而开发的,例如“以扭曲的吉他即兴演奏为后盾的镇静小提琴旋律”。

Musiclm使用这些信息生成可以在线收听的音乐片段尽管AI捕获了原始音乐的某些功能,但与其他歌曲相当准确地类似于原始歌曲片段。

“就重建音乐和原始音乐的心情而言,该协议约为60%,”蒂莫·丹克(Timo Denk)瑞士的Google的软件工程师告诉Live Science。重建和原始音乐中的类型和仪器比偶然的预期要多得多。在所有类型中,AI可以最准确地区分古典音乐。

丹克说:“在我们评估的五个主题中,该方法非常强大。” “如果您带一个新人并为他们培训模型,那么它也可能会很好。”

最终,这项工作的目的是阐明大脑如何处理音乐的方式。Yu Takagi,日本大阪大学的计算神经科学和AI助理教授。

正如预期的那样,该团队发现在主要听觉皮层中聆听音乐激活的大脑区域,那里的耳朵信号被解释为声音。高吉说,大脑的另一个区域,称为侧向前额叶皮层,对于处理歌曲的含义似乎很重要,但这需要通过进一步的研究来证实。众所周知,大脑的这个区域也参与计划和解决问题。

有趣的是,过去的一项研究发现,前额叶皮质不同部分的活性自由式说唱歌手即兴创作时,急剧转移。

Takagi补充说,未来的研究可以探索大脑如何处理不同类型或情绪的音乐。该团队还希望探索AI是否可以重建人们只想想象自己的脑海而不是实际听的音乐。