快速進步人工智慧(AI)正在促使人們質疑該技術的基本限制。越來越多的話題曾經委託科幻小說 - 超級智能AI的概念 - 現在被科學家和專家所認真考慮。

機器可能有一天比賽甚至超過人類智能的想法具有悠久的歷史。但是,最近幾十年來,AI的進步速度使該主題的緊迫性更新了,特別是因為OpenAI,Google和Anthropic等公司發布了強大的大型語言模型(LLMS)。

專家對這種“人工超級智能”(ASI)的可行性以及何時出現的可行性有很大的不同,但是有些人暗示這種超能力的機器就在拐角處。可以肯定的是,如果以及何時出現ASI,它將對人類的未來產生巨大影響。

“我相信我們將進入一個自動化科學發現的新時代,經濟增長,長壽和新穎的娛樂經驗,大大加速了,”蒂姆·羅克特(TimRocktäschel),倫敦大學學院AI教授以及Google Deepmind的首席科學家告訴Live Science,提供了個人意見,而不是Google DeepMind的官方職位。但是,他還警告說:“與歷史上的任何重要技術一樣,存在潛在的風險。”

什麼是人工超級智能(ASI)?

傳統上,AI研究的重點是複制智能生物所表現出的特定功能。其中包括諸如視覺分析場景,解析語言或導航環境的能力之類的東西。 Rocktäschel說,在這些狹窄的域中,AI已經取得了超人的表現,最著名的是 諸如Go and Chess之類的遊戲。

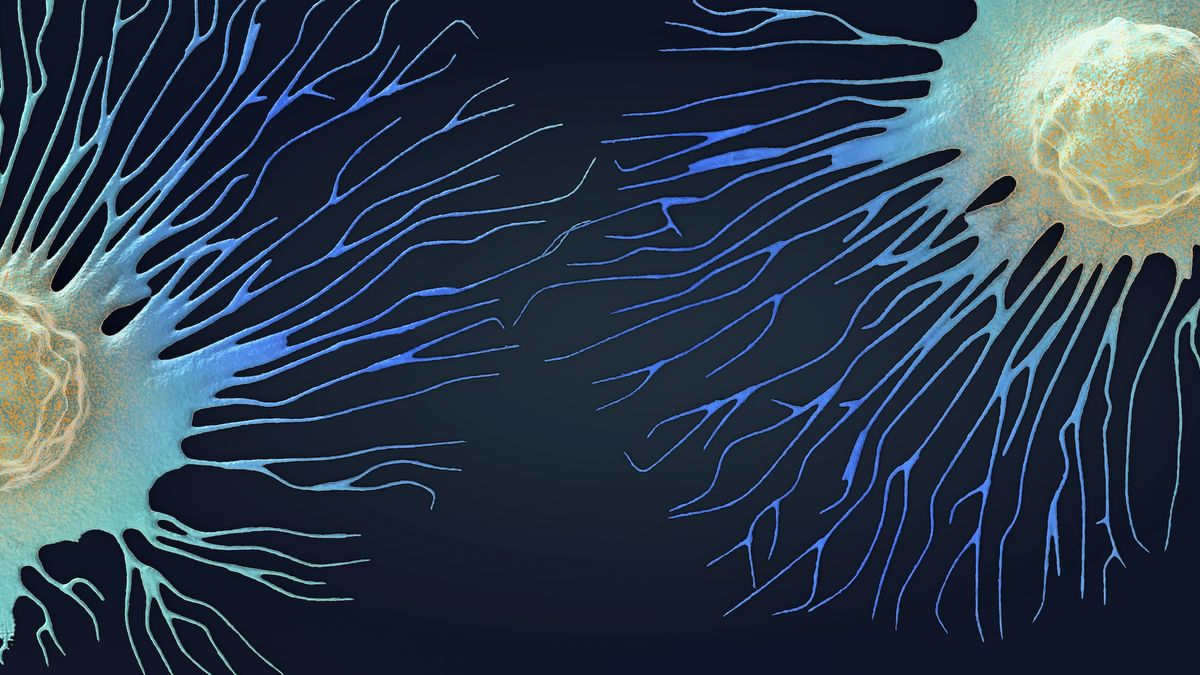

然而,該領域的伸展目標一直是複制在結合許多這樣能力的動物和人類中看到的更一般的智力形式。多年來,這個概念已經以幾個名字命名,包括“強AI”或“通用AI”人工通用情報(AGI)。

Rocktäschel說:“很長一段時間以來,Agi一直是AI研究的北極星。” “但是,隨著基礎模型的出現(LLMS的另一個術語),我們現在擁有可以通過廣泛的大學入學考試並參加國際數學和編碼比賽的AI。”

有關的:科學家說,GPT-4.5是第一個通過真實的圖靈測試的AI模型。

Rocktäschel說,這使人們更加重視Agi的可能性。至關重要的是,一旦我們創建了與人類在各種任務上匹配的AI後,可能不久之後它可以全面實現超人的能力。無論如何,這就是想法。 Rocktäschel說:“一旦AI達到了人類水平的能力,我們將能夠以自指的方式來改善自己。” “我個人認為,如果我們能夠達到AGI,我們將不久,也許在此之後幾年到達ASI。”

一旦達到了這個里程碑,我們就可以看到英國數學家歐文·約翰·古德被稱為“情報爆炸“在1965年。他認為,一旦機器變得足夠聰明以改善自己,他們就會迅速達到智力水平,遠遠超出了任何人類。他將第一台超智能機器描述為“人類有史以來的最後發明”。

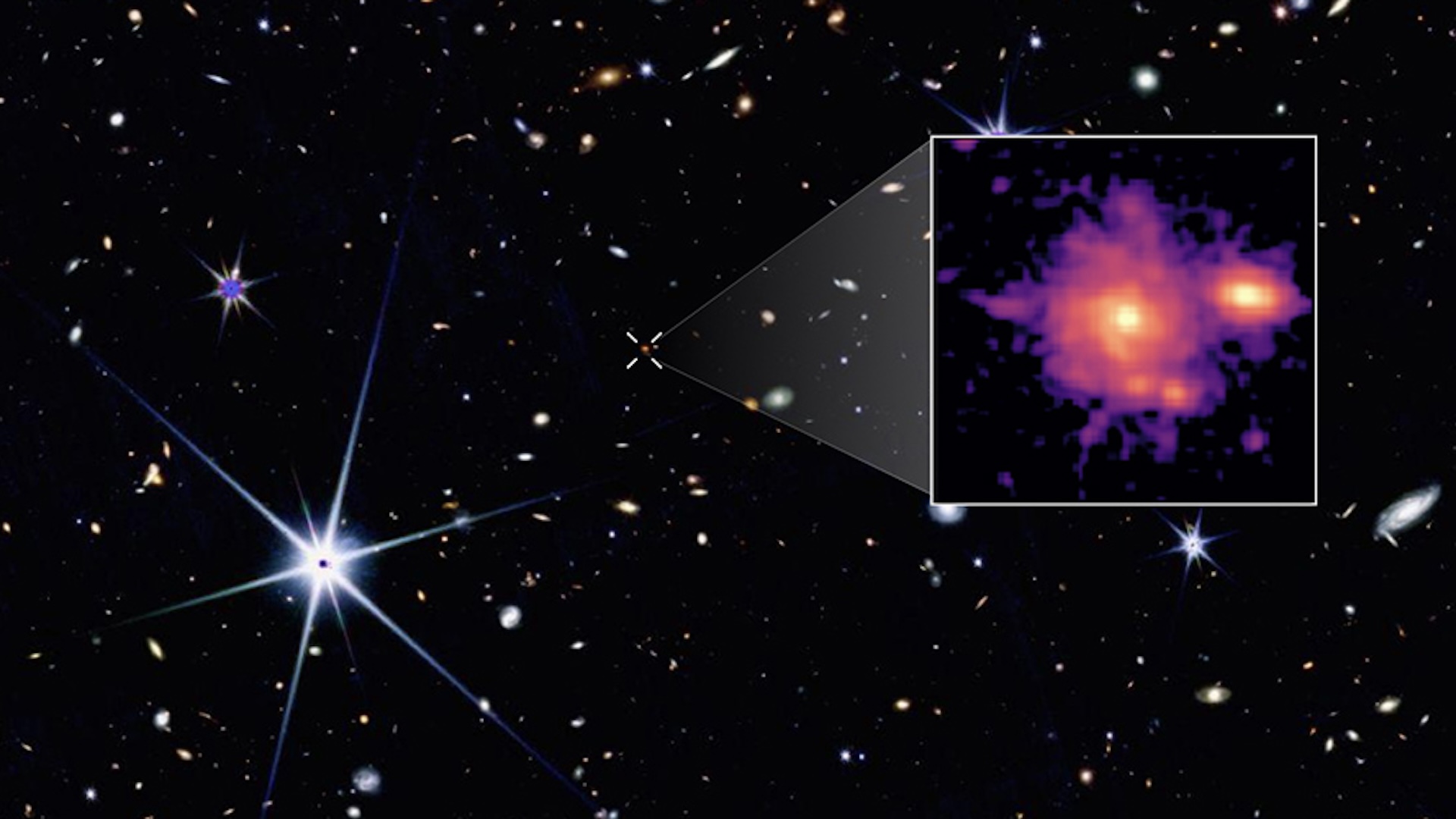

著名的未來主義者雷·庫爾茲維爾(Ray Kurzweil)曾認為,這將導致“技術奇異性”突然,不可逆轉地改變人類文明。該術語與黑洞中心的奇異性相似,我們對物理學的理解分解了。同樣,ASI的出現將導致快速且不可預測的技術增長,這將無法理解。

確切地說,這種過渡可能發生時是有爭議的。 2005年,庫茲維爾(Kurzweil)預測,阿吉(Agi)將於2029年出現,隨後是2045年的奇異性,此後他一直堅持這一預測。其他AI專家提供了巨大不同的預測 - 從這十年內到絕不。但是 最近的調查在2,778名AI研究人員中,他們發現,在總體上,他們認為到2047年可能會出現50%的ASI。更廣泛的分析同意大多數科學家都同意AGI可能到2040年到達。

ASI對人類意味著什麼?

像ASI這樣的技術的含義將是巨大的,促使科學家和哲學家專門花費大量時間來繪製人類的承諾和潛在陷阱。

從積極的一面來看,一台幾乎無限能力的智力能力的機器可以解決世界上一些最緊迫的挑戰。丹尼爾·赫爾姆(Daniel Hulme),AI公司的首席執行官 Satalia和 意識。特別是,超級智能機器可以“從糧食,教育,醫療保健,能源,運輸的創造和傳播中消除摩擦,以至於我們可以將這些商品的成本降低到零,”他告訴Live Science。

Hulme解釋說,希望這將使人們無法努力生存,而可以花時間做自己熱衷的事情。但是,除非建立系統來支持AI裁員的工作的人,否則結果可能會很沮喪。他說:“如果這種情況很快發生,我們的經濟可能無法重新平衡,這可能導致社會動盪。”

這也假定我們可以控制和指導一個比我們更聰明的實體 - 許多專家建議的不太可能。赫爾姆說:“我並不是真正地贊成這個想法,即它將關注我們並照顧我們並確保我們感到高興。” “我只是無法想像它會在乎。”

我們無法控制的超級智能的可能性促使人們擔心AI會呈現對我們物種的存在風險。這已成為科幻小說中的流行曲目,其中電影《終結者》或《矩陣》等電影描繪了對人類破壞的地獄般的惡意機器。

但是哲學家尼克·博斯特羅姆(Nick Bostrom)強調的是,對於各種世界末日場景,ASI甚至不必為人類積極敵視即可發揮作用。在 2012年論文,他建議一個實體的智能獨立於其目標,因此ASI可以具有對我們完全陌生而不與人類福祉保持一致的動機。

Bostrom通過一個思想實驗充實了這個想法,在該實驗中,超級能力的AI設定了產生盡可能多的紙片的看似無害的任務。如果與人類價值觀不符,它可能會決定消除所有人類以防止其關閉,或者可以將其體內的所有原子轉變為更多的紙捲。

Rocktäschel更加樂觀。他說:“我們構建了當前的AI系統,以提供幫助,但也可以通過設計來實現無害和誠實的助手。” “他們被調整為遵循人類的指示,並接受反饋培訓,以提供有益,無害和誠實的答案。”

儘管Rocktäschel承認可以避免這些保障措施,但他有信心將來我們將開發更好的方法。他還認為,即使它們更強,也可以使用AI來監督其他AI。

赫爾姆說,當前大多數“模型對齊”的方法 - 確保AI與人類價值觀和慾望保持一致的努力 - 太粗糙了。通常,它們要么為模型應如何行為的規則或以人類行為的例子進行訓練。但是他認為,在訓練過程結束時螺栓固定的這些護欄很容易被ASI繞開。

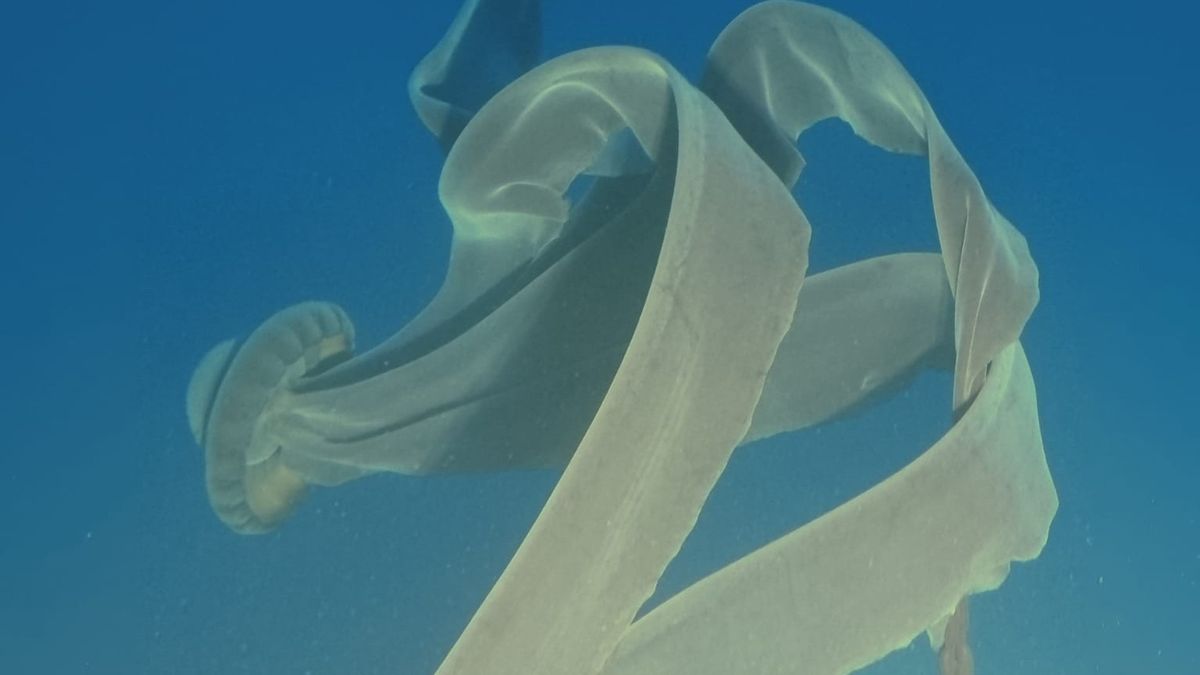

相反,赫爾姆認為我們必須以“道德本能”建立AI。他的公司助理試圖通過在虛擬環境中發展為獎勵合作和利他主義等行為的虛擬環境中的AI來做到這一點。目前,他們正在使用非常簡單的“昆蟲水平” AI工作,但是如果可以擴大方法,則可以使對齊變得更加穩健。赫爾姆說:“將道德嵌入AI的本能使我們處於更安全的位置,而不是只擁有這種摩爾的後衛導軌。”

不過,並非每個人都相信我們需要開始擔心。 Rocktäschel說,對ASI概念的一種普遍批評是,我們沒有人類在各種任務中都有能力高度能力的例子,因此在單個模型中也無法實現這一目標。另一個反對意見是,實現ASI所需的龐大計算資源可能會令人難以置信。

更重要的是,我們如何衡量AI的進度可能會誤導我們對超級智能的距離。 亞歷山大·伊利克(Alexander Ilic),瑞士Eth Zurich的Eth AI中心負責人。 Ilic說,近年來,AI中的大多數令人印象深刻的結果都來自對幾項高度人為的個人技能測試,例如編碼,推理或語言理解的測試,這些測試已明確培訓了這些系統。

他將其與在學校的考試中擠滿了比較。他說:“你忙著大腦去做,然後寫了測試,然後忘記了一切。” “參加課程,您更聰明,但是實際的測試本身並不是實際知識的良好代理。”

Ilic說,能夠通過超人水平通過許多這些測試的人工智能可能只有幾年的路程。但是他認為,當今的主要方法不會導致可以在物理世界中執行有用任務或與人類合作的模型,這對於他們對現實世界產生廣泛影響至關重要。