YouTube

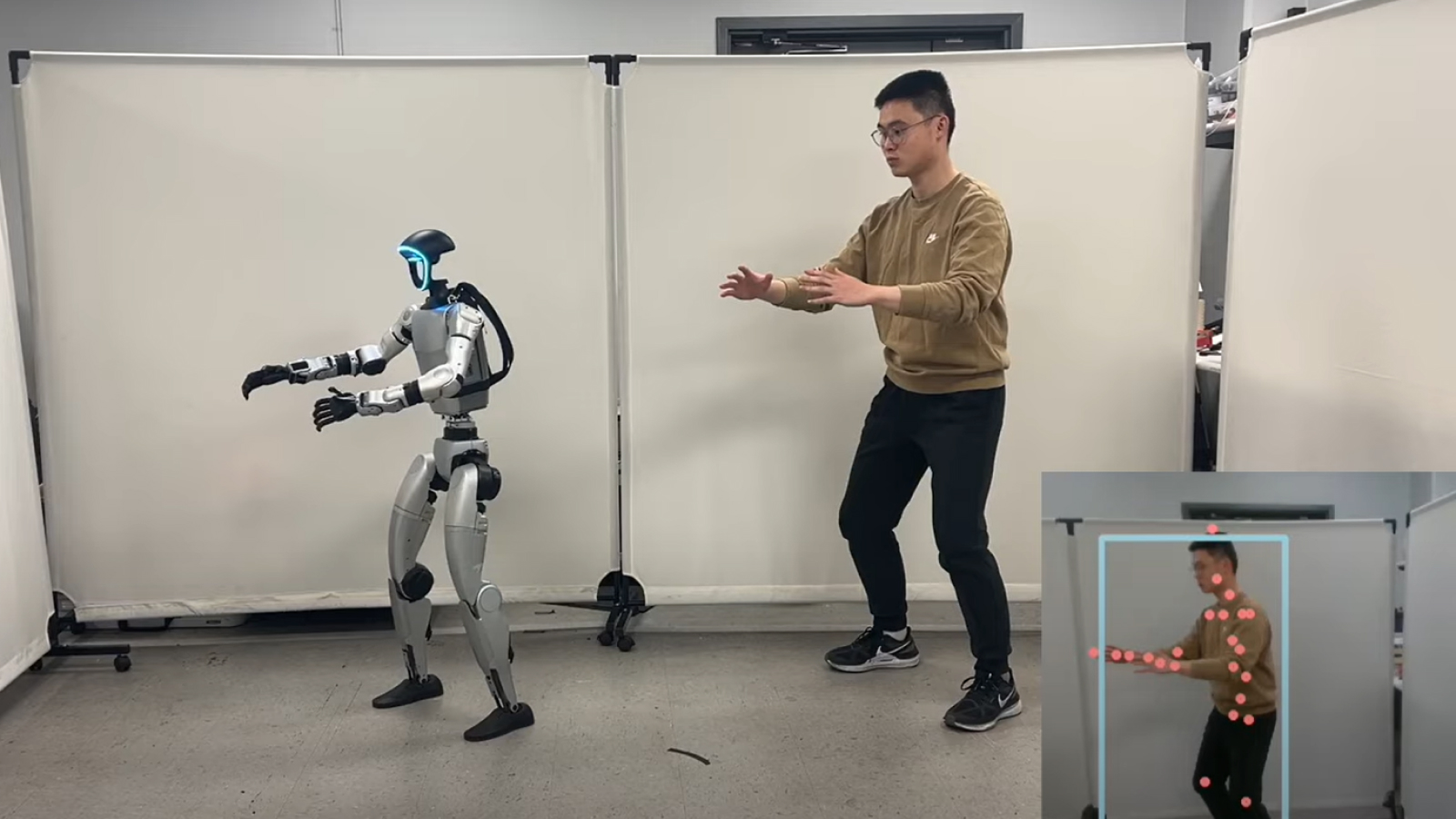

得益于用于跟踪人类运动的新软件框架,人形机器人很快就能以更加真实的方式移动,甚至可以像我们一样跳舞。

研究人员希望未来的人形机器人能够通过更准确地模仿人类动作来执行更广泛的任务。例如,教学方法可以帮助机器人执行需要精细动作的角色,例如从架子上检索物品,或者在人类或其他机器周围小心移动。

ExBody2 的工作原理是根据人类的动作捕捉扫描进行模拟动作,并将其转换为可供机器人复制的可用动作数据。该框架可以使用机器人复制复杂的动作,这将使机器人的移动不那么僵硬,并且无需进行大量的再训练即可适应不同的任务。

有关的:

这一切都是通过强化学习来教授的,强化学习是机器学习的一个子集,其中机器人被输入大量数据,以确保它在任何给定情况下采取最佳路线。研究人员模拟的良好输出会被分配正分或负分,以“奖励”模型以获得理想的结果,这意味着在不影响机器人稳定性的情况下精确地复制动作。

该框架还可以拍摄短动作片段,例如几秒钟的舞蹈,并合成新的动作帧以供参考,使机器人能够完成较长持续时间的动作。

与机器人共舞

在一个视频发布到 YouTube,一个经过 ExBody2 训练的机器人与人类对象一起跳舞、打斗和练习。此外,该机器人还使用上海交通大学机器视觉与智能小组开发的名为“HybrIK:用于身体网格恢复的混合分析神经逆运动学”的附加代码来实时模仿研究人员的运动。

目前,ExBody2 的数据集主要集中于上半身运动。在一项研究中,于 2024 年 12 月 17 日上传到预印本服务器ArXiv该框架背后的研究人员解释说,这是因为担心在机器人下半部分引入过多的运动会导致不稳定。

他们写道:“过于简单的任务可能会限制训练策略推广到新情况的能力,而过于复杂的任务可能会超出机器人的操作能力,导致无效的学习结果。” “因此,我们数据集准备的一部分包括排除或修改超出机器人能力的复杂下半身运动的条目。”

研究人员的数据集包含 2,800 多个动作,其中 1,919 个来自表面形状运动捕捉档案 (AMASS) 数据集。这是一个大型人体动作数据集,包括 11,000 多个人体动作和 40 小时的详细动作数据,旨在用于非商业深度学习 - 当神经网络接受大量数据训练以识别或再现模式时。

证明了 ExBody2 在仿人机器人中复制类人运动的有效性后,该团队现在将转向实现这些结果的问题,而无需手动管理数据集以确保框架仅可使用合适的信息。研究人员建议,未来,自动化数据集收集将有助于平滑这一过程。