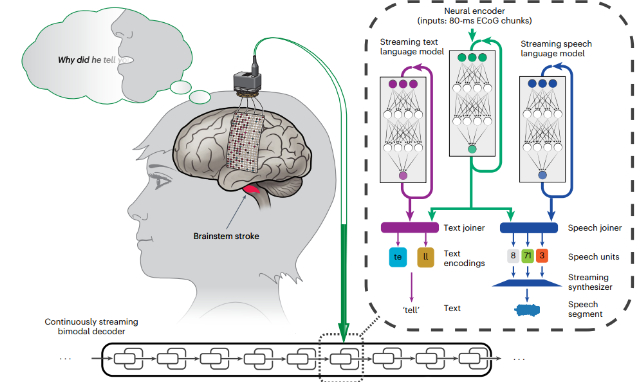

在30歲時遭受腦幹中風的近二十年後,美國的一名婦女重新獲得了實時的想法,這要歸功於新的腦部計算機界面(BCI)過程。

通過以80毫秒的增量分析她的大腦活動,並將其轉化為她聲音的合成版本,美國研究人員的創新方法消除了令人沮喪的延遲,困擾著該技術的先前版本。

我們身體傳達聲音的能力,因為我們認為它們是我們經常認為的功能。只有在極少數時刻,當我們被迫為翻譯者停下來,或者聽到我們的演講被演講者延遲時,我們是否會欣賞自己的解剖學的速度。

對於那些塑造聲音能力已從他們的人那里切斷的人大腦的語音中心,無論是否通過諸如或者關鍵病變 ,結合專業軟件的大腦植入物已承諾將獲得新的生活租賃。

的已經看到了最近,每個人都旨在在思想中發表演講時縮短。

大多數現有方法都需要在軟件破譯其含義之前要考慮一部分文本,這可以大大拖出語音啟動和發聲之間的幾秒鐘。

這種不自然的不僅是那些不自然的,對於使用該系統的人來說,它也會令人沮喪和不舒服。

加州大學伯克利分校和舊金山的研究人員“改善語音綜合延遲和解碼速度對於動態對話和流利的交流至關重要。”在他們已發布的報告中寫。

這是“語音綜合需要額外的時間進行播放的事實以及用戶和聽眾理解合成音頻的事實,這使得這變得更加複雜,”解釋該團隊由加州大學伯克利計算機工程師Kaylo Littlejohn領導。

更重要的是,大多數現有的方法都依賴於“揚聲器”來訓練界面,從而通過發聲的動作來訓練界面。對於那些無法實踐的人,或者總是很難說話,向他們的解碼軟件提供足夠的數據可能是一個挑戰。

為了克服這兩個障礙,研究人員在47歲參與者的感覺運動皮層活動上訓練了一個靈活,深度學習的神經網絡,而她從剛剛超過1000個單詞的詞彙中默默地“講”了100個獨特的句子。

Littlejohn及其同事還使用較小的單詞基於50個短語使用了輔助形式的通信形式。

與以前的方法不同,此過程不涉及試圖發聲的參與者,而只是想出她的腦海中的句子。

該系統對兩種通信方法的解碼都很重要,每分鐘平均單詞的平均數量接近了以前方法的兩倍。

重要的是,使用一種預測方法可以持續地觸發地解釋,使參與者的語音以比其他方法快8倍的自然方式流動。得益於基於她的演講的先前錄音,這甚至聽起來像是她自己的聲音。

團隊表明他們的策略甚至可以解釋代表未經故意訓練的單詞的神經信號,因此脫機過程中沒有限制。

作者指出,在該方法可以被視為臨床上可行之前,還有很大的改進空間。儘管演講是可理解的,但它遠遠沒有解碼文本的方法。

考慮 來了但是,有理由樂觀地,那些沒有聲音的人很快就會唱著研究人員及其思維方式的讚美。

這項研究發表在自然神經科學。