(Tridsanu Thophet/EyeEm/Getty Images)

(Tridsanu Thophet/EyeEm/Getty Images)

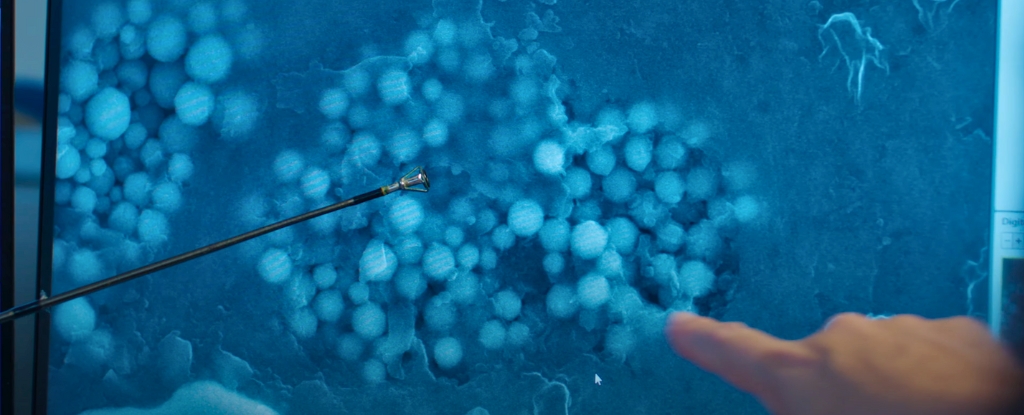

基于深度学习模型新研究表明,仅通过 X 光就可以识别某人的种族? 对于人类医生来说,查看相同的图像是不可能的。

这些发现提出了一些关于人工智能在医疗诊断、评估和治疗中的作用的令人不安的问题:在研究此类图像时,计算机软件是否会无意中应用种族偏见?

来自美国、加拿大和台湾的一个国际健康研究小组使用数十万张标有患者种族详细信息的现有 X 射线图像来训练他们的人工智能,并在计算机软件未检测到的 X 射线图像上测试了他们的系统。以前没有见过(并且没有更多信息)。

人工智能可以以惊人的准确度预测这些图像上报告的患者的种族身份,即使扫描是从同龄和同性别的人身上进行的。 系统对某些图像组达到了 90% 的水平。

研究人员在论文中写道:“我们的目标是对人工智能从医学图像中识别患者种族身份的能力进行全面评估。”发表论文。

“我们表明,标准的人工智能深度学习模型可以经过训练,通过跨多种成像模式的高性能医学图像来预测种族,并且在外部验证条件下保持不变。”

该研究呼应了一项研究的结果之前的研究研究发现,人工智能对 X 射线图像的扫描更有可能漏掉黑人的疾病迹象。 为了阻止这种情况发生,科学家首先需要了解它发生的原因。

就其本质而言,人工智能模仿人类思维来快速发现数据中的模式。 然而,这也意味着它可能会不知不觉地屈服于同样类型的偏见。 更糟糕的是,它们的复杂性使得我们很难消除我们融入其中的偏见。

目前,科学家们还不确定为什么人工智能系统如此擅长从不包含此类信息的图像中识别种族,至少在表面上是这样。 即使提供的信息有限,例如通过消除骨密度的线索或关注身体的一小部分,模型在猜测文件中报告的种族方面仍然表现得令人惊讶。

该系统可能正在寻找黑色素的迹象,黑色素是赋予皮肤颜色的色素,但科学界尚不清楚这一点。

“我们发现人工智能可以准确地预测自我报告的种族,即使是从损坏、裁剪和噪声的医学图像中预测,而临床专家通常无法做到这一点,这给医学成像中的所有模型部署带来了巨大的风险,”写给研究人员。

该研究增加了越来越多的证据人工智能系统通常可以反映人类的偏见和成见,无论是种族主义、性别歧视还是其他什么。 不正确的训练数据可能会导致不正确的结果,从而使它们的用处大大降低。

这需要与人工智能的强大潜力相平衡,人工智能可以比人类更快地处理更多数据,无论从哪里疾病检测技术到楷模。

这项研究仍有许多未解答的问题,但目前重要的是要意识到人工智能系统中出现种族偏见的可能性? 特别是如果我们将来要向他们移交更多责任的话。

“我们需要暂停一下,”麻省理工学院的研究科学家兼医生利奥·安东尼·塞利(Leo Anthony Celi)告诉《科学》杂志。波士顿环球报。

“在我们确定医院和诊所不会做出种族主义决定或性别歧视决定之前,我们不能急于将算法引入医院和诊所。”

该研究发表于柳叶刀数字健康。