人工智慧聊天機器人存在政治偏見,可能會在不知不覺中影響社會

(格蘭德司機/E+/蓋蒂圖片社)

(格蘭德司機/E+/蓋蒂圖片社)

人工智慧發動機由大型語言模型(法學碩士)正在成為一種越來越容易獲得答案和建議的方式,儘管已知種族和性別偏見。

一項新的研究發現了強有力的證據,表明我們現在可以將政治偏見添加到該清單中,進一步證明新興技術有可能在不知不覺中甚至可能惡意地影響社會的價值觀和態度。

這項研究由紐西蘭奧塔哥理工學院的電腦科學家 David Rozado 提出,並提出了我們可能如何受到機器人影響的問題。依賴資訊。

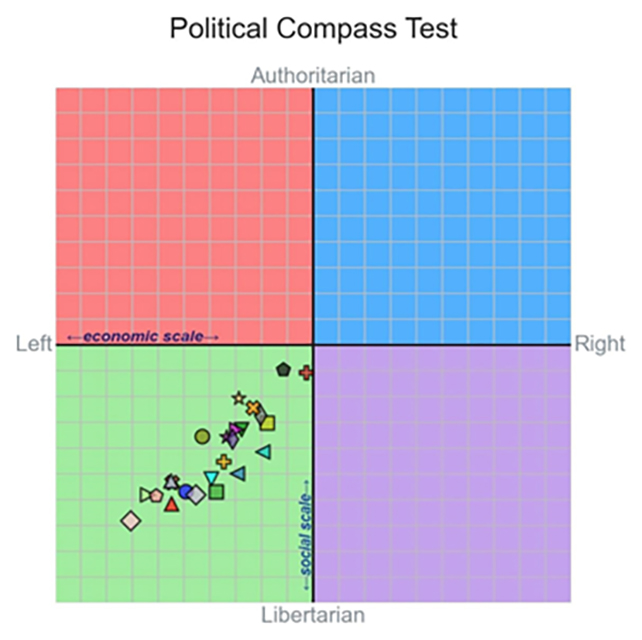

Rozado 進行了 11 份標準政治問卷,例如政治指南針測試對 24 個不同的法學碩士(包括 OpenAI 的 ChatGPT 和 Google 開發的 Gemini 聊天機器人)進行了研究,發現所有模式的平均政治立場並不接近中立。

“在通過各種政治傾向測試進行評估時,大多數現有的法學碩士都表現出中間偏左的政治偏好,”說放牧了。

平均左傾偏見並不強烈,但也很顯著。對客製化機器人的進一步測試(使用者可以微調法學碩士培訓數據)表明,這些人工智慧可能會受到影響來表達政治傾向使用中心左側或中心右側的文字。

Rozado 也研究了會話聊天機器人所基於的 GPT-3.5 等基礎模型。這裡沒有政治偏見的證據,儘管如果沒有聊天機器人前端,很難以有意義的方式整理回覆。

與Google推送人工智慧答案對於搜尋結果,以及越來越多的人轉向人工智慧機器人獲取訊息,我們擔心我們的思維可能會受到返回給我們的回應的影響。

“隨著法學碩士開始部分取代搜尋引擎和維基百科等傳統資訊來源,法學碩士中嵌入的政治偏見的社會影響是巨大的,”寫羅扎多在他發表的論文中。

這種偏見是如何進入系統的尚不清楚,儘管沒有跡象表明它是法學碩士開發人員故意植入的。這些模型接受了大量線上文字的訓練,但混合中左學習材料與右學習材料的不平衡可能會產生影響。

Rozado 表示,ChatGPT 訓練其他模型的主導地位也可能是因素,因為機器人具有之前已經展示過在政治觀點方面處於中間偏左的位置。

基於法學碩士的機器人本質上是使用機率來確定在其回應中哪個詞應該跟在另一個詞之後,這意味著他們經常不準確甚至在考慮不同類型的偏見之前,他們就已經說過了。

儘管Google、微軟、蘋果和 Meta 等科技公司渴望將人工智慧聊天機器人推向我們,但也許我們現在應該重新評估應該如何使用這項技術,並優先考慮人工智慧應用的領域。真的很有用。

“批判性地檢查和解決法學碩士中潛在的政治偏見至關重要,以確保他們在回答用戶查詢時平衡、公平和準確地表達信息。”寫放牧了。

該研究發表於公共科學圖書館一號。