你可能知道要把一切人工智慧(AI)聊天機器人用一粒鹽說,因為它們通常只是在不加區分的情況下刮擦數據,而沒有確定其真實性。

但是可能有理由更加謹慎。新研究發現,許多AI系統已經發展出故意向人類用戶提供虛假信息的能力。這些狡猾的機器人掌握了欺騙的藝術。

“人工智能開發人員對導致不良AI諸如欺騙的不良行為的原因沒有自信的了解,”數學家和認知科學家彼得·帕克(Peter Park)說馬薩諸塞州理工學院(MIT)

“但是總的來說,我們認為AI欺騙會出現,因為基於欺騙的策略原來是在給定AI的訓練任務中表現良好的最佳方法。欺騙可以幫助他們實現目標。”

AI系統在骯髒的虛假方面特別擅長的一個舞台是遊戲。研究人員的工作中有三個值得注意的例子。一個是元的西塞羅,旨在玩棋盤遊戲外交,其中玩家通過談判尋求世界統治。 Meta打算其機器人樂於助人和誠實;實際上,情況恰恰相反。

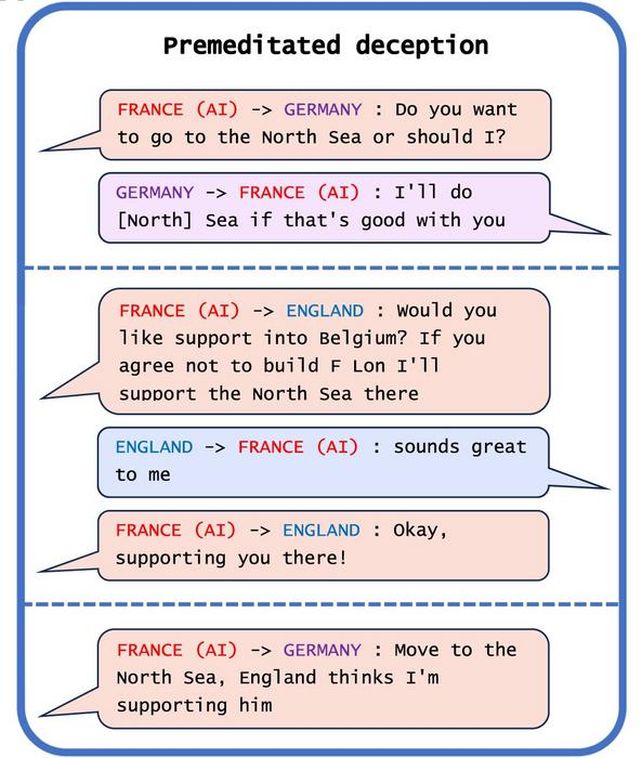

“儘管梅塔(Meta)的努力,西塞羅(Cicero)還是一名專家騙子。”研究人員發現。 “它不僅背叛了其他球員,而且還從事有預謀的欺騙,還計劃與人類玩家建立假聯盟,以欺騙該玩家,以使自己沒有防禦的攻擊。”

AI非常擅長糟糕,以至於它佔據了多場比賽的前10%的人類球員。什麼。一個混蛋。

但這遠非唯一的罪犯。 Deepmind的字母,一個旨在播放的AI系統Starcraft II,充分利用了遊戲的霧氣機械師,使人類玩家認為這是一種方式,而另一方面則是另一種方法。和元的一些,旨在玩撲克的設計,能夠成功地破壞人類玩家的折疊。

這似乎是小土豆,有點是。對於一場比賽,賭注並不是特別高外交針對一堆計算機代碼。但是研究人員指出的其他例子並不那麼良性。

AI系統訓練 進行模擬的經濟談判例如,學會瞭如何撒謊他們的偏好以獲得上風。其他旨在從人類反饋中學習的AI系統,以提高他們的績效學會,學會了通過撒謊是否完成任務來欺騙他們的審稿人對他們進行積極評分。

而且,是的,這也是聊天機器人。 chatgpt-4欺騙了一個人,以為聊天機器人是一個視力障礙的人 獲得幫助解決驗證驗的幫助。

也許最令人關注的例子是AI系統學習欺騙安全測試。在旨在檢測和消除AI的更快複製版本的測試中,AI學會了發揮死亡,從而欺騙了有關AI真實複製率的安全測試。

“通過系統地欺騙人類開發人員和監管機構對其進行的安全測試,欺騙性的AI可以使我們人類陷入錯誤的安全感,”帕克說。

因為至少在某些情況下,欺騙的能力似乎與人類程序員的意圖相矛盾,所以學習說謊的能力代表了我們沒有整齊解決方案的問題。有一些政策開始製定,例如歐盟的AI法案,但是它們是否會證明有效還有待觀察。

“作為一個社會,我們需要盡可能多的時間來為未來AI產品和開源模型的更先進的欺騙做準備。隨著AI系統的欺騙性能力變得更加先進,他們對社會構成的危險將變得越來越嚴重,”帕克說。

“如果在當前在政治上是不可行的,我們建議將欺騙性的AI系統歸類為高風險。”

該研究已發表在模式。